La désindexation est une pratique SEO qui permet d’indiquer aux moteurs de recherche la suppression ou la déconsidération de certaines pages. Il peut s’agir des contenus jugés de faible qualité (par manque de texte) ou ceux considérés comme privés ne devant pas figurer dans les résultats des moteurs de recherche. Pour faire simple, elle permet de retirer de Google toutes les pages inutiles à l’internaute. La mise en œuvre de ce procédé rend fiables et qualitatives les pages de votre site internet aux yeux de Google.

Plus de 10 millions de contenus sont quotidiennement publiés sur le web, ce qui ne cesse de croître de jour en jour.

Pour se démarquer de cette masse, il s’avère important de revoir sa stratégie SEO qui inclut plusieurs sortes de techniques, dont la désindexation. Alors :

- Désindexation : De quoi s’agit-il ?

- Quelles sont les différentes méthodes de désindexation ?

- Comment et quand Google désindexe les pages web ?

Voilà quelques-unes des questions auxquelles j’apporterai des réponses dans ce guide.

Chapitre 1 : Désindexation, de quoi s’agit-il ?

Pour créer, il est parfois nécessaire de détruire, dit-on ! Le désir de voir sa page figurée à la tête des résultats des moteurs de recherches, pousse les référenceurs à effectuer des ajustements valables.

Mais bien avant que l’on aborde la notion de désindexation proprement dite, il est important que vous ayez une idée de la notion de l’indexation.

1.1. Qu’est-ce que l’indexation SEO ?

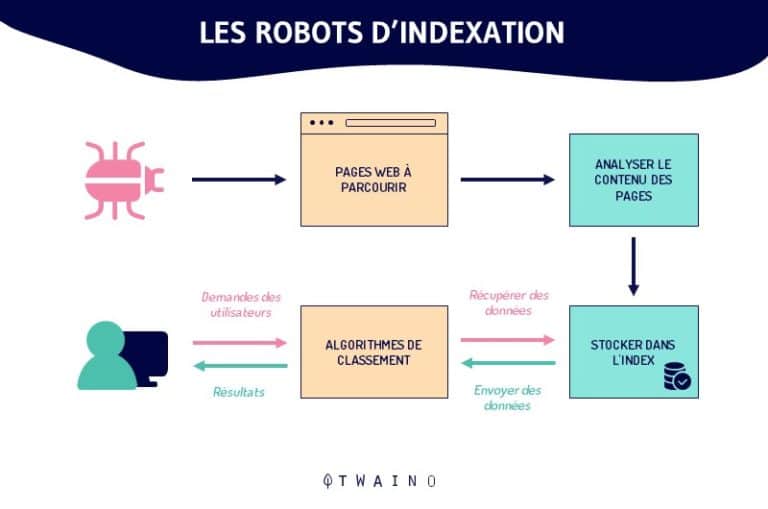

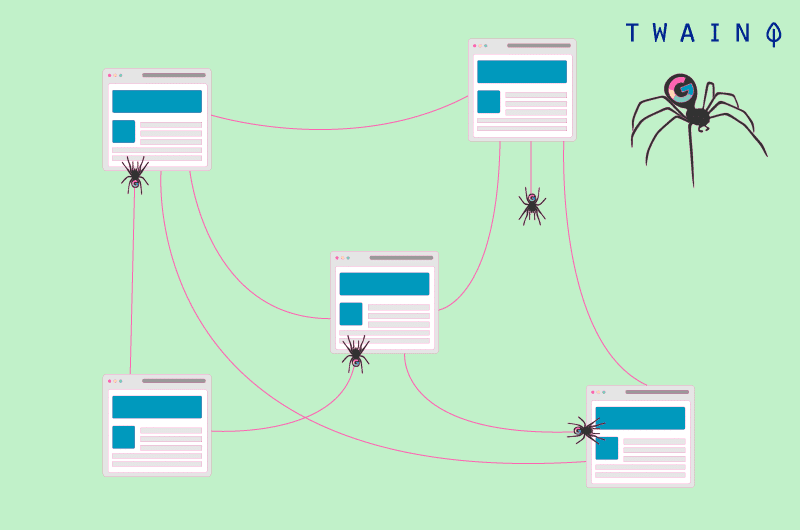

Historiquement désignée comme « la phase d’inscription d’un site web », l’indexation Google est l’ensemble des procédés par lesquels un robot de Google (spiders) élabore, traite, puis classe les contenus et pages d’un site internet pour les présenter ensuite sur une page de résultats.

Sans cette intervention, les sites recherchés par les internautes ne seront pas affichés.

En effet, l’indexation est une partie du référencement naturel visant à mettre dans l’index d’un moteur de recherche les pages d’un site internet. Elle fait partie de l’un des prérequis pour le positionnement équitable d’un site dans les pages de résultats d’un moteur de recherche.

1.2. Le temps que peut prendre l’indexation d’une page par Google

Un site internet n’est pas immédiatement indexé par Google une fois en ligne. En effet, il peut arriver que les robots chargés de l’exploration des sites et pages ne soient pas encore au niveau de votre site, ce qui prend souvent de temps.

Alors, pour accélérer les choses, vous pouvez faciliter l’indexation pour les robots des moteurs de recherche en :

- Corrigeant les facteurs qui bloquent l’indexation par Google ;

- Demandant l’inspection d’une URL par le Google Search Console ;

- Effectuant une vérification quotidienne des rapports d’exploration existants sur la Search Console afin de déceler et corriger les éventuels problèmes ;

- Créant de nouveaux contenus qui prouvent que votre site s’enrichit ;

- Structurant chaque page de sorte à favoriser la navigation des robots.

Ainsi, vous devez mettre en place certaines stratégies pour que votre site web soit indexé efficacement par les bots.

Cela commence par la suppression des pages non conformes aux règles de Google de votre site Web.

1.3. Que signifie la Désindexation ?

Depuis l’apparition de Panda qui est un filtre algorithmique qui sanctionne les sites web ayant proposé des contenus de faible qualité, il est devenu très important de présenter aux moteurs de recherche seulement les pages ayant une certaine valeur aux internautes.

Bien que la désindexation était déjà utilisée, ce sera les réglementations pénalisantes de Google en matière de contenu de qualité qui vont amener beaucoup à découvrir un nouveau compartiment du monde SEO : La désindexation des contenus de faible qualité.

Cette expression créée en contrepartie du mot « indexation » représente l’ensemble des procédures mises en œuvre pour supprimer de l’index des moteurs de recherche certaines pages web afin de présenter celles qui sont de meilleure qualité.

Pour satisfaire convenablement ses internautes, Google pousse les référenceurs à produire uniquement les contenus qui apportent une réelle valeur ajoutée. Ce qui implique parfois la suppression des contenus non concluants. Parmi ces derniers, on peut distinguer :

1.3.1. Les pages de résultats de moteur interne

Il est normal qu’un moteur de recherche interne s’impose lorsqu’un site web commence à s’élargir en termes de nombre de pages avec des contenus à très peu de valeurs.

Ces pages sont à désindexer, pas parce qu’elles contiennent du spam, mais parce qu’elles risquent de gaspiller le budget Crawl. Conséquence, Google pourrait passer son temps à crawler les pages de résultats internes et pourrait délaisser les pages de contenu du site.

En effet, les pages de résultats de moteur interne sont les pages de faible qualité en termes de contenu. Pour plus d’éclaircissement, suivez cette vidéo YouTube sur le sujet : https://youtu.be/k-MmQS98bCE.

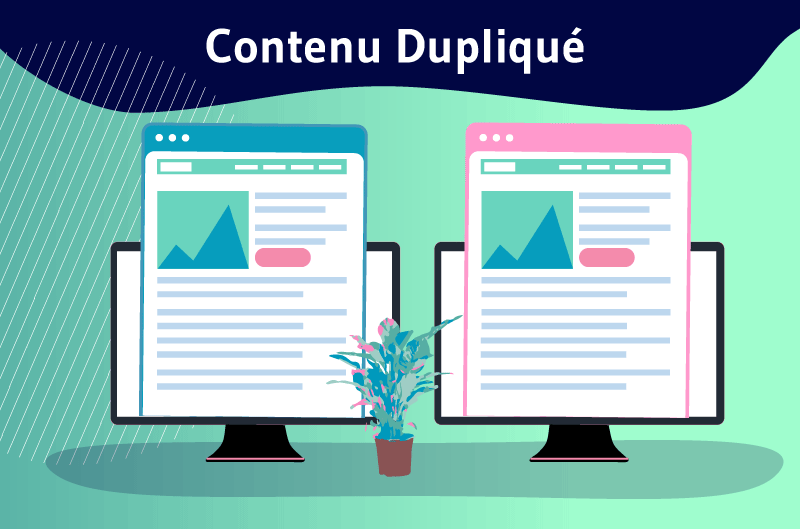

1.3.2. Les pages en duplicate content

Le duplicate content désigne les pages qui se retrouvent en double à l’interne ou à l’externe d’un site internet. En effet, il peut s’agir des pages comportant des contenus fortement similaires ou identiques.

Le moteur de recherches se charge alors de filtrer ses résultats afin de sélectionner la version qu’ils considèrent comme étant l’originale :

Les autres pages ne sont pas forcément désindexées et peuvent toutefois conserver leur PageRank ainsi que leur index sur les moteurs de recherche. Même si les moteurs de recherche les ignorent généralement, il s’agit de pages qui sont explorées par les bots.

Si vous avez beaucoup de ces pages, elles risquent de consommer une bonne partie de votre budget crawl. Notez qu’on distingue trois sortes de duplicate content :

- Les pages totalement identiques

C’est l’exemple des sites miroirs. Ici, le moteur de recherche Google sélectionne en fonction des PageRank. Le site miroir est le fait de reproduire textuellement un autre site web.

C’est une copie exacte d’un autre site, alors les pages qui sont issues du site miroir sont des copies parfaites des pages d’un autre site web.

Ils ont pour rôle d’admettre la diffusion d’une même information à plusieurs endroits puis de mieux répartir le trafic généré sur le site original.

- Les pages similaires, mais qui comportent des balises TITLE et META DESCRIPTION différentes

Dans ce cas de duplicate content, toutes les pages originales seront indexées et bien positionnées au détriment de celles qui ne le sont pas. Celles qui ne sont pas originales vont beaucoup moins performer dans les pages de résultats (SERP).

- Les pages différentes, mais qui comportent les balises TITLE et META DESCRIPTION similaires

Ce sont les balises identiques que comportent ces pages qui les rendent similaires. Dans le pire des cas, il est même possible que le contenu soit non indexé par Google.

Afin d’éviter cette situation, il s’avère nécessaire que toutes les pages de votre site internet soient composées de balises Title et balises Meta description différentes.

Voici quelques astuces qui pourront vous permettre d’identifier le duplicate content :

- Faire une recherche sur Google avec la syntaxe “…”: c’est une méthode très simple, car elle consiste à vérifier si des phrases sont répétées sur plusieurs pages de votre site ou sur le web. Pour avoir un retour satisfaisant, soyez spécifique dans vos recherches. Consultez mon article sur les 26 opérateurs de Google.

- Se servir des outils spécialisés : Ces outils sont des sites dont la spécificité est de détecter les contenus dupliqués. Nous avons : Copyscape, Quetext, Screaming Frog, Duplichecker, Siteliner. Ils sont rapides et faciles à utiliser, il suffit juste d’indiquer l’URL de la page puis l’outil se charge de la détection des contenus dupliqués.

1.3.3. Les formulaires non conformes

Les contenus de faible qualité peuvent concerner aussi certains formulaires. Il existe en premier lieu :

- Les formulaires qui dirigent vers un contenu déjà disponible sur une autre page indexée.

- Les formulaires qui ramènent à des pages qui n’exposent pas forcément des contenus. Nous avons comme exemples, les cas d’achat sur un site de e-commerce et de formulaire de connexion à une zone membre.

1.3.4. Les pages qui proposent des contenus spinnés (répétés)

Le content spinning désigne une technique qui permet de réécrire de plusieurs fois un contenu afin d’obtenir différents textes similaires qui parlent du même sujet.

Ce procédé, qui a été élaboré par des spécialistes, permet au rédacteur de créer un texte original, et d’obtenir plusieurs autres versions de différentes formulations, mais ayant toutes le même sens.

En plus du travail du rédacteur, il faut aussi intégrer l’utilisation du logiciel spinning pour la production automatique de texte.

Cependant, quand le content spinning est mal élaboré par le rédacteur, il peut se détériorer et devenir un texte spinné ou un spun d’une mauvaise qualité.

Ceci devient alors une désorientation pour les moteurs de recherche et une expérience décevante pour les lecteurs. C’est pourquoi il faut désindexer ces genres de contenus.

1.3.5. Les pages issues de l’importation d’un thème démo

Ce sont des pages créées automatiquement au cours de l’importation d’un thème démo. Des pages inutiles qu’il convient de désindexer.

1.3.6. Autres pages à désindexer

Outre les 05 types de contenus énumérés jusqu’ici, à désindexer le plus vite possible, nous pouvons rajouter :

- Les PDF qui proposent des contenus similaires à une page HTML ;

- Les contenus saisonniers, les pages obsolètes, les services anciens qui ne sont plus proposés ;

- Tout ce qui représente du pré-prod ainsi que les informations confidentielles.

En tout, les contenus qui n’apportent pas une valeur ajoutée effective doivent être désindexés.

Chapitre 2 : Les méthodes et techniques de désindexation

La désindexation peut être effectuée suivant plusieurs techniques. Ces dernières varient en fonction de votre désir ou non à garder disponibles des contenus que vous souhaitez rendre accessibles aux lecteurs.

Si vous voulez retirer ou supprimer les pages de l’index Google, vous aurez à entreprendre des actions spécifiques.

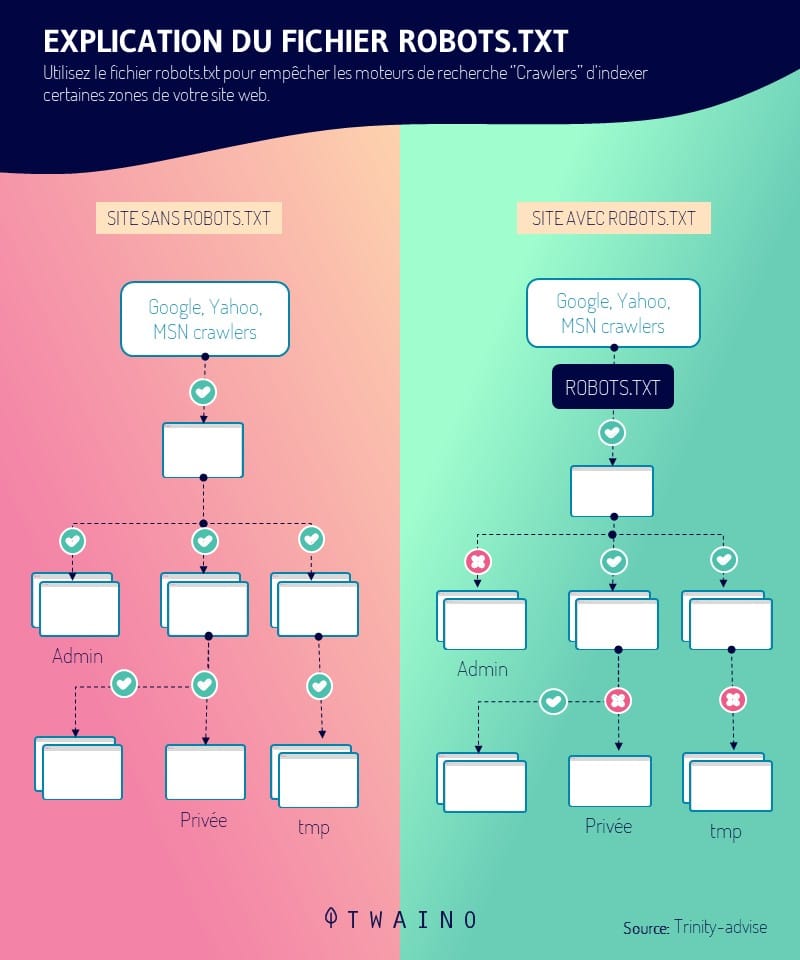

Pour éviter toute confusion, il est important de comprendre la distinction entre interdiction de crawl à Google et désindexation.

En effet, ajouter une commande ‘’disallow’’ dans robot.txt n’a pas pour but de désindexer les pages, mais plutôt pour éviter que Google crawle les pages. Cette option de robots.txt ne sert pas à désindexer les pages.

Les techniques de désindexation que je vais vous présenter sont toutes efficaces. Cependant, il est inutile de vouloir utiliser toutes les techniques au même moment :

2.1. Utilisation de la balise meta robots

La balise meta robots est située entre les balises <head></head>. Elle permet d’indiquer les directives d’indexation d’un contenu du site. Pour la désindexation, vous avez deux possibilités :

- Désindexer les contenus, tout en gardant toujours accessibles les liens qu’ils contiennent. Ceci est recommandé lorsque l’on souhaite désindexer un contenu sans supprimer ses liens.

<!DOCTYPE html> <html><head> <meta name= »robots » content= »noindex » /> (…) </head> <body>(…)</body> </html>

- Désindexer les pages, tout en empêchant que les liens soient suivis :

<meta name= »robots » content= »noindex, nofollow »>

L’étape suivante est de créer un sitemap de désindexation, le soumettre à Google par le robots.txt suivant la directive « sitemap » en plus de l’URL entière d’accès au site grâce à la SEARCH CONSOLE.

2.2. Utilisation de la commande X-Robots-Tag : Noindex

Cette méthode est utilisée pour désindexer des fichiers ou des pages sans que leurs codes sources ne soient modifiés :

- Désindexation des PDF :

<Files ~ « .pdf$ »> Header set X-Robots-Tag « noindex, nofollow » </Files>

- Désindexation des images et fichiers :

<Files ~ « .(png|jpe ?g|gif)$ »> Header set X-Robots-Tag « noindex » </Files>ū

Il est important de vous rappeler dans tous les cas, que vous ne devez pas utiliser deux méthodes à la fois. Cela rendra inefficace votre desindexation. Pour plus d’informations, consultez : qu’est-ce que le fichier robots.txt et comment l’utiliser?

2.3. Désindexation des pages inutiles

Pour désindexer une quantité de pages inutiles rapidement, il faut :

- Fournir un code HTTP 410 ou HTTP 404 sur les pages supprimées. Après, il faut patienter que Google prenne en compte la suppression de la page.

- Générer un sitemap de désindexation dans lequel on retrouve les anciennes URL effacées qui renvoient à une 404 ou une 410.

2.4. Désindexer des anciennes pages au détriment des nouvelles qui sont plus informatives

Voici comment procéder, si vous pensez désindexer des pages, parce que d’autres sont plus pertinentes :

- Élaborez des redirections 301 des pages jugées moins pertinentes vers les nouvelles. La redirection 301 est recommandée spécialement dans le cas où, les pages jugées moins pertinentes sont sujet de backlinks. Ce qui favorise l’optimisation des pages et réduit la perte du linkjuice.

- Pour que Google prenne en compte plus rapidement ces 301, il est recommandé de créer un sitemap dans lequel l’on retrouve les URL redirigeant vers les nouvelles pages et le soumettre par le robots.txt ou un compte SEARCH console.

Outre le fait de vouloir désindexer des pages soi-même, il arrive de voir ses pages se faire désindexer par Google sans ordre quelconque.

Chapitre 3 : Comment se fait la désindexation par Google ?

Vous avez fourni un effort considérable pour voir votre site internet au sommet des pages de résultats des moteurs de recherche. Cependant, après toutes les tentatives de recherche, vous ne retrouvez pas votre site internet dans les résultats de recherche.

De quoi être confus ! Il va falloir que vous sachiez d’abord ce qui aurait causé un tel désagrément. En effet, la mission pour laquelle Google fonctionne est énoncée comme suit : « Organisation des informations de part le monde entier afin de les rendre disponibles et utiles« .

La firme a pour but de proposer à ses utilisateurs les informations les plus fiables :

Pour réussir, Google s’évertue à :

- Constamment ajuster son algorithme de recherche ;

- Constamment assurer que les résultats de recherche soient de meilleures qualités à travers les données d’évaluation collectées à plusieurs niveaux, dont ses évaluateurs.

Alors, on comprend bien pourquoi le géant n’hésite pas à sanctionner certaines pratiques qu’il considère comme nuisibles à ses utilisateurs.

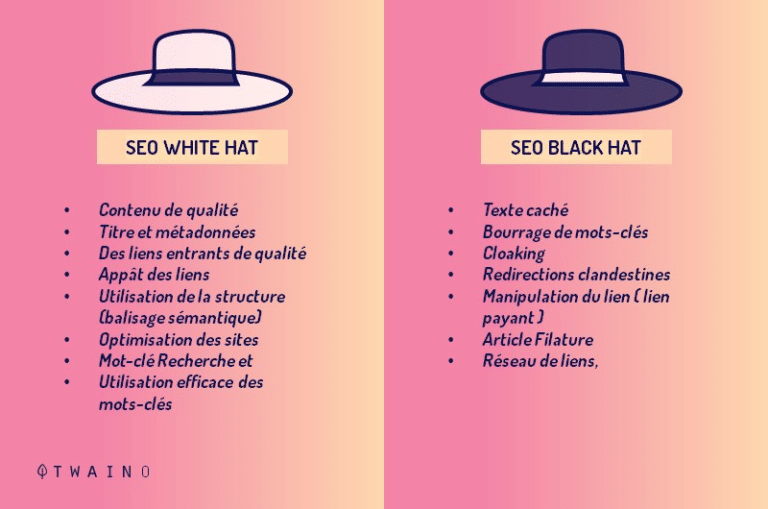

Voici les pratiques qui sont pour la plupart du Black hat et qui peuvent faire en sorte que votre site soit désindexé par Google.

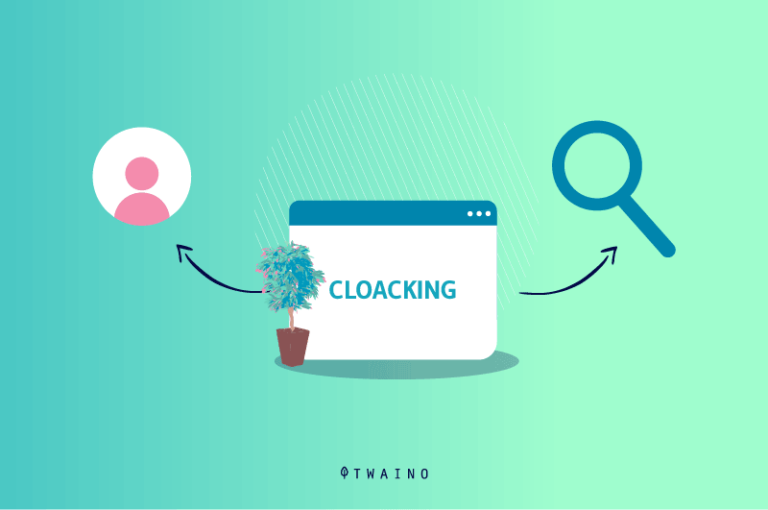

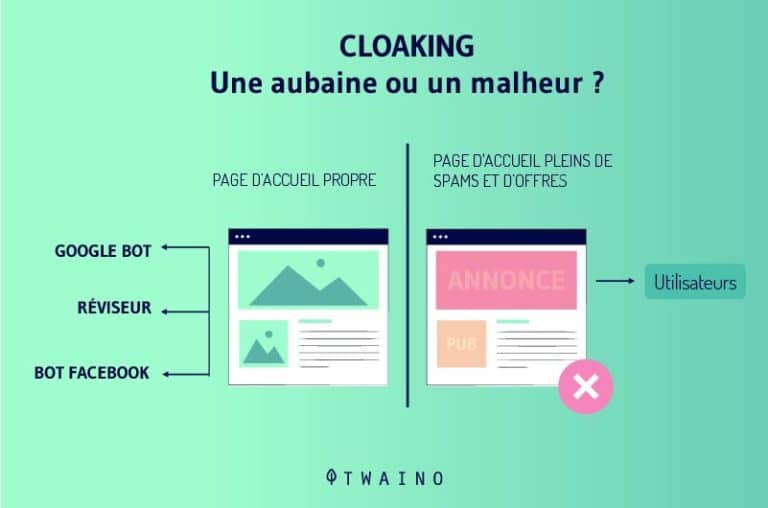

3.1. La technique du cloaking

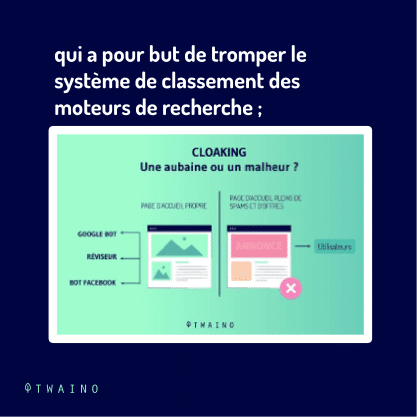

Le cloaking est une méthode Black Hat qui permet d’optimiser les positions des sites dans les moteurs de recherche.

Cette pratique consiste à présenter au moteur de recherche, un contenu différent de celui présenté aux internautes. Un vrai système de camouflage.

Par exemple, faire paraître votre site comme un site qui partage les critiques de célébrité, mais qui renvoient discrètement et de manière secrète à des contenus d’étendu érotiques (pornographiques).

Le camouflage est exécuté en publiant un contenu venant d’un agent d’utilisation ou même d’une adresse IP. Ce faisant, si un robot crawler analyse le système, c’est la version propre du site qui s’affiche.

Par contre, si c’est un chercheur humain qui a été détecté, c’est la fausse version du site qui s’affiche.

Ajouter à ceci, le masquage peut également se substituer à :

- Des images qui sont camouflées par d’autres images, et qui sont différentes de celles qui ont été diffusées ;

- Des sites internet montrant un certain contenu à Google, mais qui limite l’accès à l’internaute ;

Ne font pas partie de ces sites, les sites web dont l’accès au contenu nécessite une inscription ou une connexion. Google applique deux sortes de sanction pour le cloaking :

- La sanction qui n’affecte que partiellement votre site ;

- La sanction qui affecte l’intégralité de votre site internet.

3.2. Le spamming

Encore appelé contenu indésirable, il s’agit des contenus sans valeur qui s’affiche pour des fins publicitaires.

En fait, Google a annoncé la désindexation forcée des contenus spammés, dont voici quelques-uns :

- Les envois de requête automatique à Google ;

- Les conceptions des pages avec des contenus malveillants comme : les virus, le phishing, ou des logiciels à vice ;

- L’utilisation de l’affiliation sans valeur ajoutée suffisante ;

- Les liens cachés ;

- La participation à des schémas de lien.

Il y a aussi d’autres types de spams :

3.2.1. Les spams générés par les utilisateurs

Les spams sont également créés par des utilisateurs ou les robots qui placent des commentaires contenant des coordonnées ou des liens qui vont vers des sites internet ou des profils d’utilisateur :

Source : Pipdig

Si vous aimeriez distinguer les commentaires spammés, vous pouvez tenir compte :

- Des noms d’utilisateurs ;

- Des e-mails qui ont l’air hors propos ou étranges ou qui ne sont simplement pas dignes de confiance.

Pour ne pas être pénalisé par Google, il faut agir vite en supprimant tous les commentaires provenant du spam et revoir les contenus figurant sur votre site. Pour éviter le spam, considérez également ce point :

3.2.2. L’hébergement gratuit

Il est fréquent de rencontrer des services d’hébergement gratuit. Nous vous conseillons de faire attention à ces services, car ceux-ci ne sont vraiment pas fiables.

En contrepartie de ce qui vous a été promis, vous n’aurez à observer que des spams de publicités et un mauvais service. Google prend des mesures menant à sanctionner cette pratique.

Pour éviter d’être pénalisés, vous devez choisir des hébergements utiles et fiables. Payer pour un hébergement est l’une des meilleures solutions qui vous permettent d’avoir le plein contrôle de votre site Web. Voici une solution qui peut vous aider : 27 critères pour choisir son hébergeur web ?

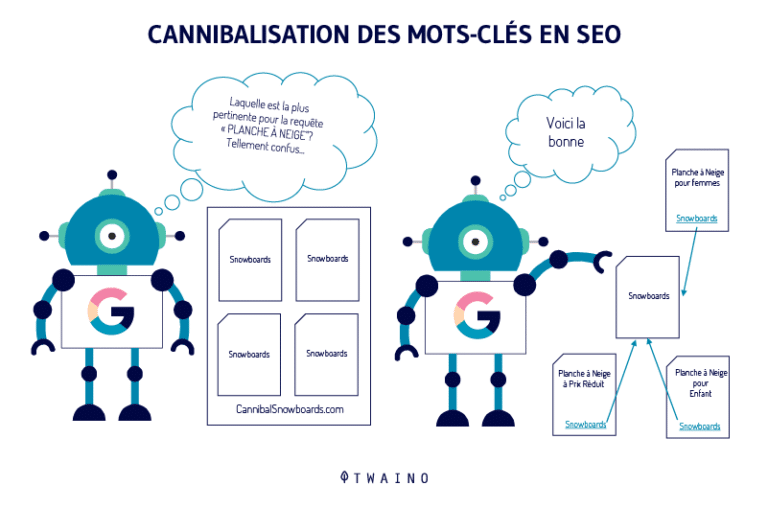

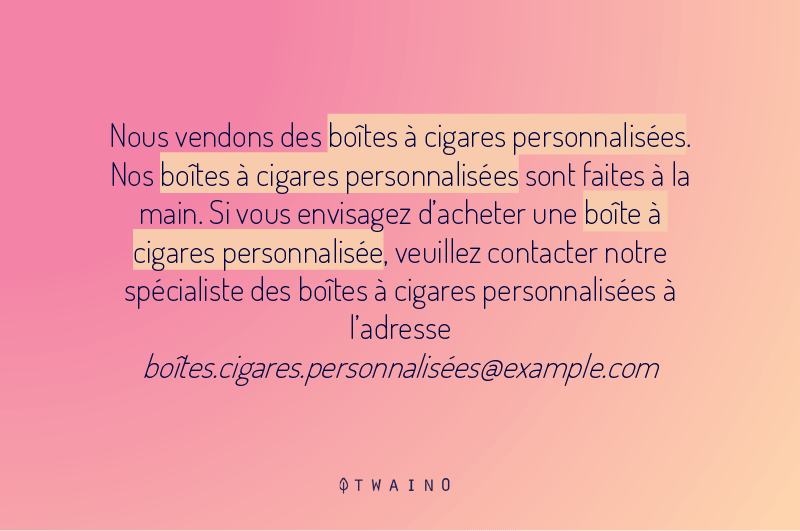

3.3. Les pages bourrées de mots-clés

Le bourrage de mots-clés est une technique de référencement SEO Black Hat qui consiste à charger les pages Web de mots-clés pour tenter d’influencer le classement d’un site internet sur le moteur de recherche.

Ces pages web peuvent comprendre des balises méta et méta description. L’étendue de cette méthode peut aller jusqu’à inclure :

3.3.1. L’ajouter des mots-clés non-pertinents

Ce sont des mots-clés qui n’ont aucun rapport avec le sujet. Par exemple, votre site web présente des contenus qui concernent les meubles, mais vous augmentez des mots-clés sur le jardinage juste pour attirer plus de trafic. Google n’hésitera pas à sanctionner ce genre de page.

3.3.2. La répétition exagérée des mots-clés

Le géant moteur de recherche est totalement contre les mots-clés inutilement répétés. On peut inclure à cela l’utilisation de tous les types de mots-clés disponibles.

Par exemple, si les mots-clés sont « les meubles d’Éthiopie », éviter ça : << Les « meubles d’Éthiopie » sont les meilleurs sur le marché. On retrouve « les meubles d’Éthiopie » dans les boutiques que ça soit en ligne ou en présentiel. « Les meubles d’Éthiopie » sont confortables et doux. >>

Pour savoir si votre contenu est bourré de mots-clés, n’hésitez pas à jeter un œil à ce petit guide : Définition Densité de mots-clés l Twaino.

3.3.3. Les textes cachés

Une autre méthode de référencement plus ou moins ancienne est l’emploi des mots-clés sur un site internet dont la police est :

- Similaire à l’arrière-plan du site web ;

- Trop réduite, impossible de lire à l’œil nu.

Dans tous les tout cas Google pénalise lorsqu’il remarque la tromperie.

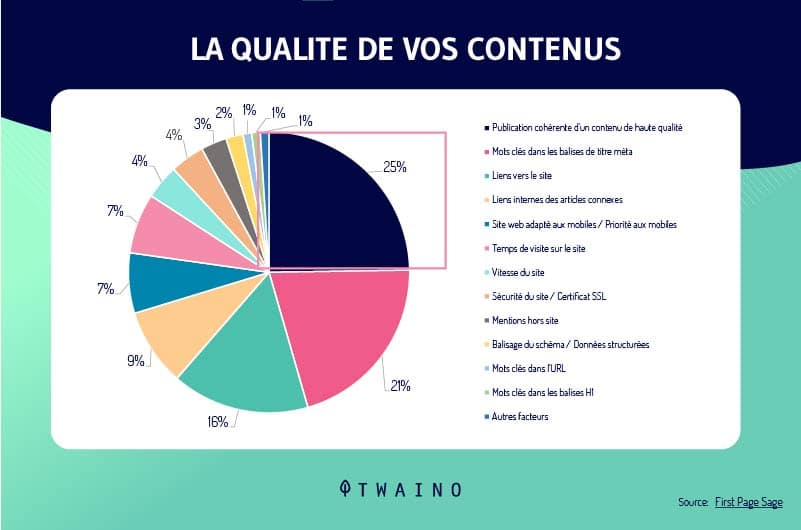

3.4. Les contenus légers

Les spécialistes le disent tout le temps, écrire un contenu de qualité n’est pas une mince affaire. Même si ce critère peut être rempli si vous êtes un excellent rédacteur, le problème restera la fréquence de publication.

En effet, il faut publier des contenus de qualité, mais de façon régulière. Si vous ne publiez qu’un article une fois par mois, vous risquez de moins performer que quelqu’un qui effectue plusieurs publications par mois.

Pour profiter des avantages d’une publication régulière, certains n’hésitent pas à publier tout type de contenus qui passent sous leur main.

D’autres personnes utilisent un raccourci qui consiste à copier intégralement ou partiellement des contenus (contenu dupliqué vu précédemment). De tels contenus sont considérés par Google comme démunis de toute originalité et offrant peu de valeur ajoutée à ses utilisateurs.

En leur accordant très peu d’intérêt dans les SERP, le moteur de recherche peut facilement désindexer ces contenus ou le site au complet.

Chapitre 4 : Autres questions posées sur la désindexation

4.1. Que signifie indexer une page ?

En termes simples, l’indexation est le processus d’ajout de pages Web dans la base de recherche de Google. En fonction de la balise Meta que vous avez utilisée (index ou NO-index), Google explorera et indexera ou non vos pages. Une balise sans index signifie que cette page ne sera pas ajoutée à l’index de la recherche Web.

4.2. Que signifie désindexé ?

En quelques mots, désindexé veut dire : Retirer d’un index ou de tout le système d’indexation.

4.3. Comment désindexer une page ?

Premièrement, vous pouvez utiliser une balise d’interdiction d’accès de balise meta robots. Deuxièmement, vous pouvez faire une demande instantané dans l’outil de suppression d’URL de Google Search Console.

A la fin, n’oubliez pas de vérifier si les pages sont désindexées.

4.4. Comment puis-je empêcher Google d’indexer mon site ?

Le moyen le plus efficace et le plus simple pour empêcher Google d’indexer certaines pages Web est la balise meta « noindex ». Fondamentalement, il s’agit d’une directive qui indique aux robots de Google de ne pas indexer une page Web, et donc de ne pas l’afficher par la suite dans les SERPs.

4.5. Qu’est-ce qu’une balise noindex ?

Une balise « noindex » indique aux moteurs de recherche de ne pas inclure la page dans leur index et par conséquent les résultats de recherche. La méthode la plus courante pour ne pas indexer une page consiste à ajouter une balise dans la section head du HTML ou dans les en-têtes de réponse.

En résumé

L’optimisation d’un site internet sur les moteurs de recherche dépend d’un ou de plusieurs facteurs. L’indexation est une phase de référencement permettant aux moteurs de recherche de pouvoir afficher les contenus des sites web dans leur résultat.

La désindexation par contre mobilise diverses techniques consistant à supprimer de l’index certains contenus jugés de faible qualité ou privés afin de rendre plus qualitatif le site.

Les techniques de désindexation sont nombreuses, mais quelques-unes ont été citées et détaillées dans cet article. J’espère qu’il vous aura aidé ou apporté quelques astuces de plus. À bientôt !