Conosciuti anche come “stringhe di query” o “parametri di query URL”, i parametri URL sono un mezzo per tracciare le informazioni e il traffico di un sito web. Sono i dati dinamici inseriti nella stringa URL dopo l’esecuzione della query, per filtrare informazioni aggiuntive su un determinato sito o per strutturare i contenuti del sito.

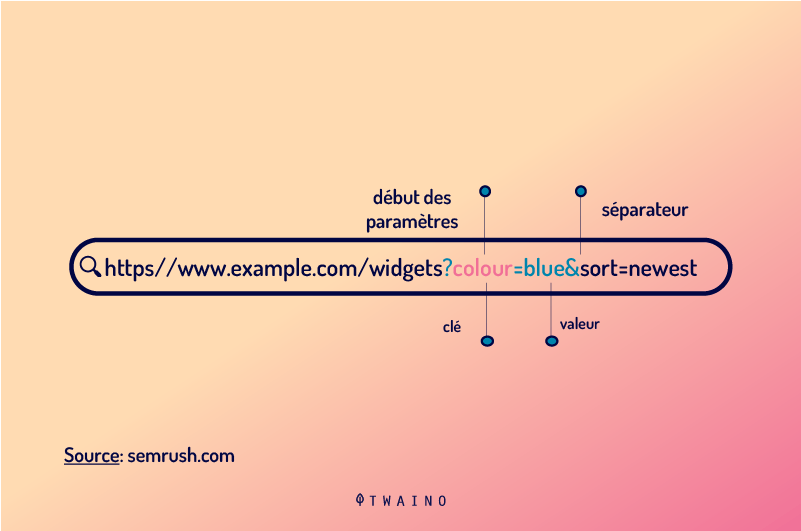

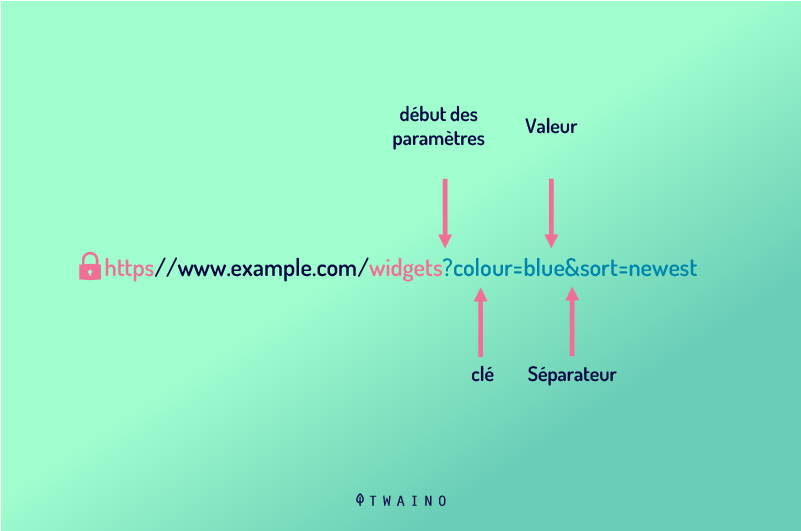

I parametri URL si trovano solitamente nella stringa dopo il simbolo (?). Sono costituiti da una chiave e da un valore separati da un segno di uguale (=). Tuttavia, è possibile aggiungere più parametri URL a una stringa separandoli con il simbolo dell’ampersand (&).

Le stringhe di query sono parte integrante dell’URL di un sito web e sono una grande risorsa per i professionisti SEO

Tuttavia, possono essere la fonte di molti problemi per i siti web, soprattutto per quanto riguarda il posizionamento delle pagine web nelle SERP di Google.

- Come risolvere i problemi causati dai parametri?

- Non vale la pena di rimuovere i parametri URL?

In questo articolo, spiegherò in dettaglio l’uso delle stringhe di query, dalla definizione alle diverse tecniche per risolvere i problemi dei parametri URL.

Capitolo 1: Che cos’è un parametro URL?

I parametri URL sono elementi dinamici di una stringa di query. Una stringa di query è la parte dell’URL che segue il simbolo del punto interrogativo (?).

Esempio: www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date

In questa stringa, tutti gli elementi che vengono dopo il (?) sono chiamati “parametri URL”.

1.1. Di cosa sono fatti i parametri URL?

La costituzione di una stringa URL casuale può sembrare molto complicata a prima vista. Soprattutto il mix di lettere, numeri e simboli le darà probabilmente l’impressione di un codice piuttosto complicato da decifrare.

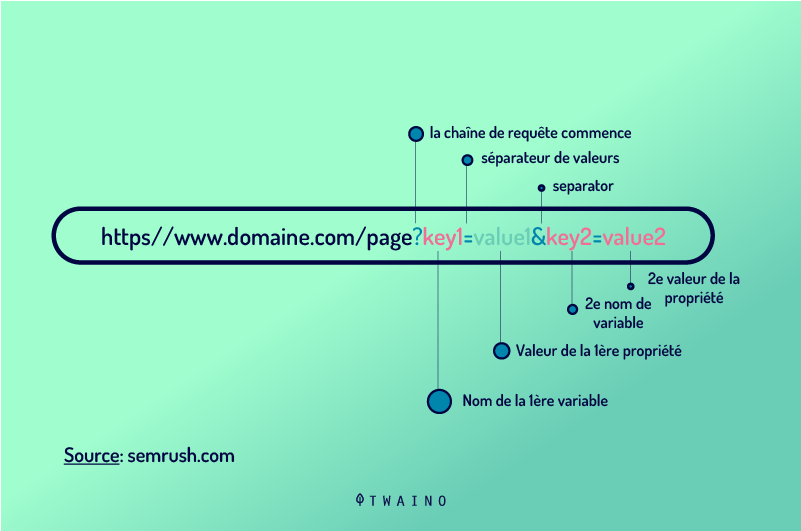

Ma in realtà, è possibile dare un senso a tutti gli elementi o dati che compongono una stringa URL, una volta compresa l’anatomia di un parametro URL. Ecco i diversi elementi possibili che si possono trovare in una stringa URL

- Il punto interrogativo (?): il punto interrogativo segna l’inizio di un parametro URL in una stringa URL. Esempio: www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date (threadid=64&sort=date) ;

- L’ampersand: gli ampersand sono utilizzati quando ci sono diversi parametri nella stringa URL. La presenza di un ampersand segna la fine di un parametro URL e l’inizio di un altro. Esempio: (?threadid=64& sort=date=64& sort=date);

- Il nome della variabile o “Chiave”: si tratta del titolo o dell’etichetta del parametro URL. Esempio: ?threadid=64&sort=date=64&sort=date;

- Il valore: si tratta del valore specifico separato dal nome della variabile da un segno di uguale (=). Esempio: ?threadid=64&sort=date=64&sort=date.

I parametri URL sono normalmente utilizzati per svolgere due compiti principali: migliorare il contenuto di una pagina e tracciare le informazioni sui clic tramite l’URL. In base a questi due tipi di utilizzo, esistono due parametri URL principali: Parametri URL attivi e passivi.

- Parametri URL attivi, noti anche come parametri di modifica del contenuto: questo tipo di parametro URL viene utilizzato per modificare il contenuto delle pagine di un sito web.

Esempio

- Riordino dei contenuti: (?sort=price_ascending) “Visualizza i contenuti in un ordine particolare su una pagina web”.

- Per segmentare il contenuto di una pagina: (?page=1, ?page=2, ?page=3). Questo parametro URL viene utilizzato per segmentare i contenuti di grandi dimensioni in tre parti più piccole.

- Per limitare il contenuto: (?type=yellow). Questo parametro URL viene utilizzato per far apparire solo i contenuti “gialli” su una pagina web.

Per reindirizzare un contenuto specifico (A), ad esempio, è sufficiente inserire la sua stringa nell’utente web: http://domain.com?productid=A

- Parametri URL passivi: a differenza dei parametri URL attivi, quelli passivi non modificano il contenuto di una pagina web, ma vengono utilizzati per il tracciamento dei clic attraverso l’URL. Questi parametri le permettono di avere tutte le informazioni sul clic, cioè l’origine, la campagna, ecc. Questi dati saranno utili per valutare le prestazioni delle sue recenti campagne di marketing. Ecco alcuni esempi di parametri URL passivi.

Esempio

- I parametri URL passivi possono essere utilizzati per identificare le visite o le sessioni di un sito. Per tracciare il traffico della sua campagna e-mail, può inserire nella stringa: https://www.domain.com/?utm_source=emailing&utm_medium=email.

- I parametri URL possono essere utilizzati per identificare l’origine e tutti i dati (fonte, mezzo e persino campagna) relativi a una visita a un sito web. Per raccogliere i dati della campagna: https://www.domain.com/?utm_source=twitter&utm_medium=tweet&utm_campaign=summer-sale.

- Infine, i parametri URL possono agire anche come identificatori di affiliazione. Questa funzione è spesso utilizzata da blogger e influencer per generare ricavi per clic.

1.2. come applicare i parametri URL?

Nei negozi online, ad esempio, i parametri di query URL sono comunemente utilizzati per facilitare la navigazione degli utenti. In effetti, i parametri vengono eseguiti in questo caso per ordinare e selezionare le pagine da categorie specifiche.

Questo permette all’utente di essere reindirizzato direttamente ai prodotti che potrebbero interessargli. Potranno anche visualizzare un numero definito di articoli per pagina, ordinando le pagine in base ai filtri.

Inoltre, i parametri URL passivi sono molto utilizzati dai marketer digitali. Queste metriche consentono loro di tracciare la provenienza del traffico del loro sito web, per determinare la portata o il successo del loro ultimo investimento in una strategia di marketing digitale.

Ecco alcuni dei casi d’uso più comuni delle metriche URL:

- Filtraggio dei contenuti: scegliere quali pagine visualizzare in base ai colori e ai prezzi dei prodotti in un negozio online, ad esempio: ?type=widget, color=blue o ?price-range=20-50 ;

- Tracciamento del traffico: ?utm_medium=social, ?sessionid=123 o ?affiliateid=abc ;

- Traduzione: ?lang=en, ?language=de o ;

- Riorganizzazione dei contenuti di una pagina web: ?sort=prezzo più basso, ?order=prezzo più alto o ?so=più nuovo;

- Identificazione di un prodotto in una categoria: ?product=small-blue-widget, categoryid=124 o itemid=24AU ;

- Segmentare il contenuto di una pagina: ?page=2, ?p=2 o viewItems=10-30 ;

- Esecuzione di una ricerca specifica: ?query=users-query, ?q=users-query o ?search=drop-down-option.

Capitolo 2: I vari problemi SEO causati dai parametri URL

Per quanto siano buoni e utili, è importante che qualsiasi SEO o esperto SEO moderi o stia lontano dall’uso dei parametri URL il più possibile. Questo perché i parametri URL tendono a creare molti problemi che possono avere un impatto sulla SEO di un sito web.

Questi includono problemi legati al consumo eccessivo del budget di crawl, impedendo ai crawler di effettuare il crawling delle pagine web e l’indicizzazione. Un errore nella strutturazione dei parametri URL passivi, ad esempio, può portare alla creazione di contenuti duplicati.

In questo capitolo, troverà i probabili problemi che potrebbero costituire un ostacolo alla SEO del suo sito, causati dai parametri URL.

2.1. Creare contenuti duplicati

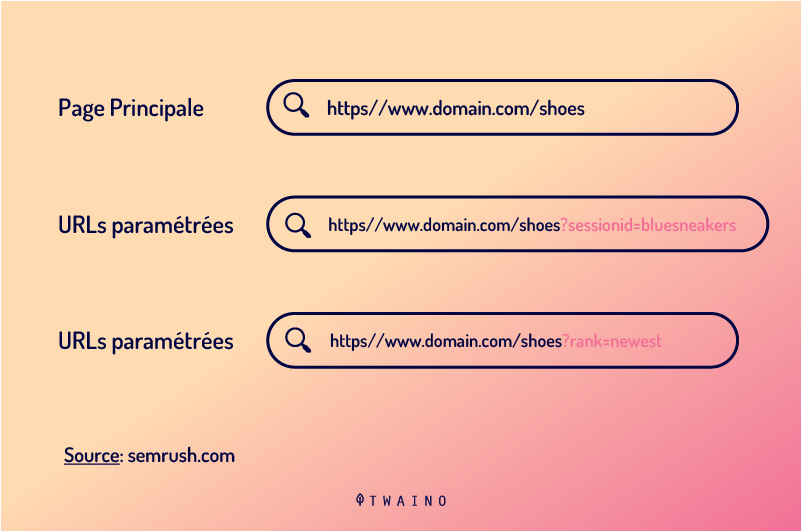

Google e altri motori di ricerca considerano ogni URL come un’intera pagina web. Di conseguenza, più versioni della stessa pagina create con parametri URL saranno considerate pagine indipendenti e quindi contenuti duplicati.

L’utilizzo dei parametri URL attivi per riorganizzare una pagina web non apporta grandi cambiamenti alla pagina originale. Alcuni parametri URL utilizzati per riorganizzare una pagina web possono persino presentare esattamente la stessa pagina della pagina originale.

Allo stesso modo, l’URL di una pagina web con tag di tracciamento o un identificatore di traffico è identico all’URL originale.

Esempio

- URL statico: https://www.example.com / widget

- Parametro di tracciamento: https://www.example.com/widgets ?sessionID=32764

- Parametro di riorganizzazione: https://www.example.com /widgets?sort=newest

- Parametro di identificazione: https://www.example.com ?categoria=widget

- Parametro di ricerca: https://www.example.com/products ?search=widget

Si può notare che ci sono diversi URL che hanno tutti lo stesso contenuto. Se ha un negozio online e lo fa per ogni categoria, si accumulerà e avrà un numero considerevole di URL.

Il problema è quando i crawler di Google visitano il suo sito. Un URL trovato è considerato una nuova pagina dai crawler. Pertanto, tratteranno ogni parametro URL come una pagina indipendente.

Scopriranno quindi contenuti duplicati che trattano lo stesso argomento semantico su URL diversi, considerati come pagine diverse. Inutile dire che i contenuti duplicati sono una delle infrazioni punite da Google.

E anche se la presenza di questi parametri URL che creano contenuti duplicati non è un motivo sufficiente perché Google bandisca il suo sito dalle SERP, possono comunque causare la cannibalizzazione delle parole chiave.

2.2. sprecare il budget per le strisciate

Una struttura URL abbastanza semplice è un vantaggio per l’ottimizzazione del suo sito. Una buona mappa del sito consente ai crawler di scansionare facilmente le diverse pagine del suo sito senza consumare molta larghezza di banda.

D’altra parte, gli URL complessi contenenti molti parametri causano la creazione di molti URL che puntano allo stesso contenuto. Questo rende la struttura del suo sito web più complessa e fa perdere tempo ai crawler.

Il crawling o la scansione di un sito con una struttura molto complessa può esaurire il budget di crawling e ridurre la capacità dei crawler di indicizzare le sue pagine web per il posizionamento nelle SERP.

2.3. I parametri URL portano alla cannibalizzazione delle parole chiave

Poiché i diversi parametri aggiunti all’URL originale mirano allo stesso contenuto, e quindi alle stesse parole chiave, l’indicizzazione può mettere in competizione pagine diverse che mirano alle stesse parole chiave.

Questo fatto può portare i robot di indicizzazione a svalutare queste parole chiave. Potrebbero ritenere che tutte le pagine contenenti queste parole chiave non forniscano alcun valore aggiunto agli utenti.

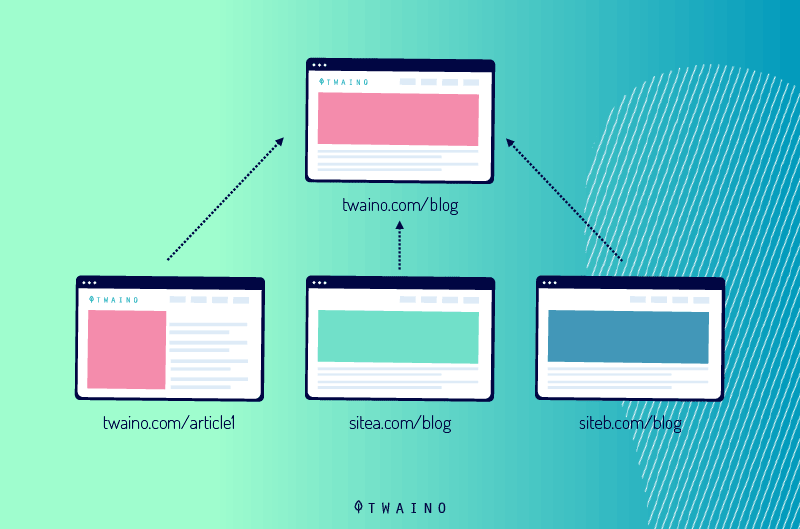

2.4. I parametri URL diluiscono i segnali di ranking

Se ha più parametri URL che puntano allo stesso contenuto, le visite provenienti dalle condivisioni sui social media e dai link andranno a qualsiasi versione della sua pagina

Questo non solo le farà perdere traffico, ma le sue pagine non si classificheranno bene.

Infatti, la diversificazione delle visite confonderà i crawler e quindi diluirà i suoi segnali di ranking. I bot diventeranno incerti e avranno difficoltà a sapere quale pagina concorrente deve essere posizionata nei risultati di ricerca.

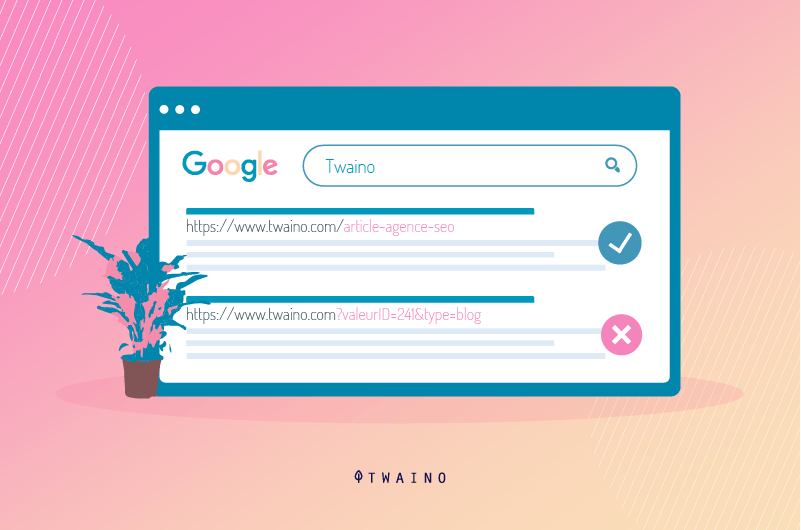

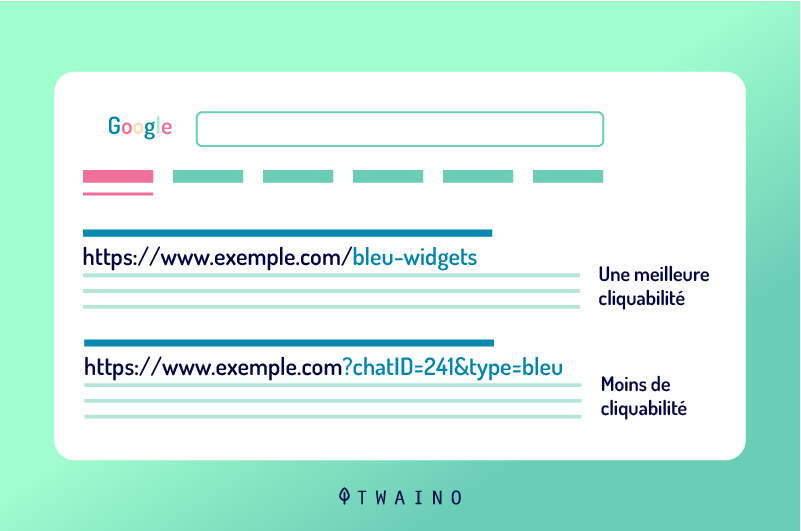

2.5. I parametri URL rendono gli URL meno attraenti

Per ottimizzare al meglio il suo sito web, gli URL devono essere esteticamente gradevoli, leggibili e semplici da capire. Un URL con parametri è solitamente complesso e illeggibile per i visitatori.

La presentazione di un URL parametrato non riflette la fiducia, perché sembra che sia spammoso. È quindi improbabile che gli utenti clicchino o condividano.

Le impostazioni degli URL possono quindi avere un impatto negativo sulle prestazioni delle sue pagine web. In primo luogo, il CTR può essere una parte del motivo del posizionamento.

Ma le sue pagine non beneficiano di questo motivo, perché la complessità degli URL rallenterà il tasso di click-through. In secondo luogo, diminuirà anche il traffico dai social network, dalle e-mail… perché gli utenti saranno sospettosi del suo URL parametrizzato.

Va notato che le implicazioni della condivisione di tweet, e-mail… nello sviluppo della notorietà di una pagina web non sono così minime

In sostanza, la scarsa leggibilità degli URL del suo sito web può essere un ostacolo al coinvolgimento del suo marchio con i clienti o con gli utenti di Internet in generale.

Capitolo 3: Come può gestire i parametri URL in modo che non influiscano sulla SEO del suo sito?

La maggior parte dei problemi SEO causati dai parametri URL che ho menzionato nel capitolo precedente hanno tutti una cosa in comune: il crawling e l’indicizzazione di URL parametrizzati. Tuttavia, questo non impedisce la generazione di nuovi URL parametrizzati sui siti web.

Scopra come risolvere i problemi dei parametri URL e creare nuovi URL tramite parametri senza causare problemi SEO alle sue pagine web.

3.1. Determinare l’entità dei problemi dei parametri URL

Prima di iniziare il processo di risoluzione dei problemi dei parametri URL su un sito web, è importante conoscere tutti i parametri che vengono inseriti nell’URL del sito

A meno che il suo sviluppatore non disponga di un elenco completo di tutti i parametri URL, sarà un vero mal di testa identificare tutti i parametri inseriti nell’URL del suo sito.

Fortunatamente, non deve farsi prendere dal panico

Le mostrerò in cinque passi come può trovare tutti i parametri dell’URL e il comportamento dei robot di indicizzazione.

- Utilizzando un crawler: eseguendo un crawler come Screaming Frog, può trovare un elenco di tutti i parametri utilizzati nell’URL del suo sito. Cerchi il simbolo (?) nell’URL e riceverà tutti i parametri.

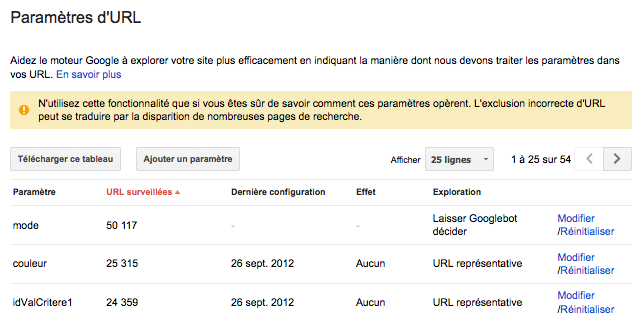

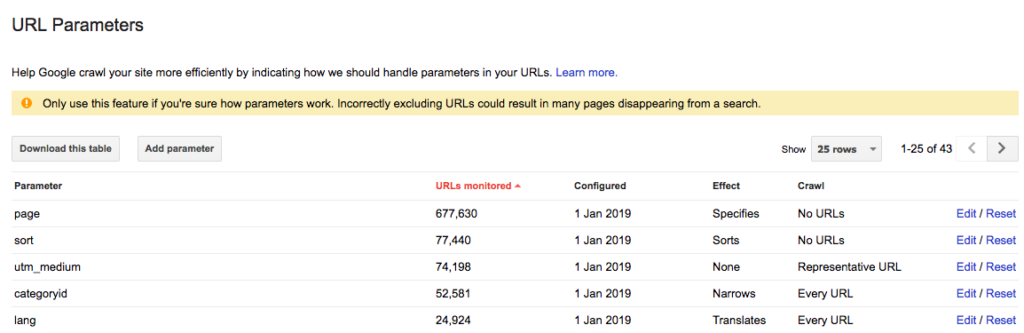

- Verifichi nella Google Search Console, in particolare nello strumento di impostazione degli URL. Google aggiunge automaticamente le stringhe di query. Quindi può trovare i parametri URL nella Search Console.

Fonte: WebRankInfo

- Analizzare i file di log: può anche vedere nei file di log se i crawler di Google hanno visitato URL con parametri.

- Effettua una query combinata con: inurl. Inserendo la chiave: inurl in una query combinata come: example.com inurl:key, può scoprire come i crawler di Google stanno indicizzando i parametri URL trovati sul suo sito.

- Cerca nel rapporto di Google Analytics tutti i parametri URL: Può cercare il simbolo (?) in Google Analytics per vedere come i suoi utenti interagiscono con i parametri URL. Ma prima di farlo, è importante verificare se i parametri URL sono presenti nel parametro di visualizzazione.

Con questi dati, può ora pensare a come gestire ciascuno dei parametri URL.

3.2. Controlli costantemente il suo budget di crawl e limiti le impostazioni degli URL

Il numero totale di pagine che i Googlebot o altri crawler dei motori di ricerca devono visitare sul suo sito si chiama crawl budget. Il budget di crawl è diverso da un sito all’altro, perché non tutti i siti hanno lo stesso numero di pagine web.

È quindi necessario assicurarsi che il suo budget per le strisciate non vada sprecato. Come menzionato nel capitolo precedente, avere molti URL impostati sul suo sito esaurisce rapidamente il suo budget di crawling.

Per gestire questo problema, può fare una rapida analisi sull’utilità di ogni parametro che ha generato per la SEO del sito. Questa analisi le permetterà di ordinare i parametri ed eliminare quelli meno interessanti.

In ogni caso, troverà un motivo per ridurre gli URL impostati e quindi risparmiare il budget di crawling. Può seguire il seguente processo per ridurre il numero di URL impostati sul suo sito e minimizzare il loro impatto sulla SEO.

3.2.1. Ordinare ed eliminare i parametri non necessari

Inizi a richiedere al suo sviluppatore un elenco completo di tutte le impostazioni URL generate sul sito, oppure utilizzi uno dei metodi descritti nel sottocapitolo 3.1. per ottenere un elenco di tutte le impostazioni URL sul suo sito

In questo elenco, è probabile trovare parametri che non svolgono una funzione benefica

Può anche definire dei criteri di valutazione che le permetteranno di selezionare quali impostazioni URL sono valide e quali no

Può utilizzare il parametro sessionID, ad esempio, per identificare un gruppo target di utenti sul suo sito in un determinato momento.

Questo parametro rimarrà nella stringa URL anche se non lo utilizza più. In realtà, i cookie sono migliori per identificare gli utenti in generale. Il parametro sessionID non è quindi più necessario nella stringa URL. Quindi può rimuoverlo.

Allo stesso modo, potrebbe scoprire che uno dei filtri del browser potrebbe non essere mai utilizzato dai visitatori. Tutti questi parametri di query URL non necessari dovrebbero essere rimossi.

3.2.2. Valori limitanti senza una funzione specifica

I parametri che deve aggiungere al suo URL saranno utili solo se hanno una funzione specifica da svolgere. Dovrebbe quindi evitare di aggiungere un parametro se il suo valore è vuoto.

3.2.3 Inserimento di chiavi uniche

Tranne che nel caso di selezione multipla, dovrebbe evitare di inserire più parametri con lo stesso nome di variabile (Chiave) con valori diversi. Per le opzioni di selezione multipla, è addirittura consigliabile raggruppare i valori dopo un unico tasto.

3.2.4. Organizzazione dei parametri URL

È vero che l’ordine in cui sono presenti i parametri URL non ha molta importanza o esclude i contenuti duplicati. Anche se riorganizza i parametri, i crawler continueranno a considerare le diverse pagine come identiche.

Tuttavia, ogni combinazione dei diversi parametri esaurisce il budget di crawl e quindi impedisce a Googlebot di effettuare il crawling dell’intero sito per classificare le pagine meritevoli.

Può contrastare questo problema richiedendo al suo sviluppatore un ordine coerente quando scrive gli script dei parametri URL. Non c’è un ordine fisso da seguire, ma logicamente dovrebbe sempre iniziare con i parametri di traduzione, seguiti dai parametri diidentificazione, paginazione, sovrapposizione di filtri e tracciamento.

Questo metodo offre diversi vantaggi, soprattutto per quanto riguarda il riferimento al suo sito

Questi includono

- Garantire un uso normale del budget per le strisciate;

- Ridurre al minimo i problemi di contenuto duplicato;

- I segnali di ranking sono più consolidati su altre pagine del sito;

- Dare chiarezza e leggibilità al suo URL, che può incoraggiare le persone a cliccare e condividere il suo URL tramite i social network, le e-mail, ecc.

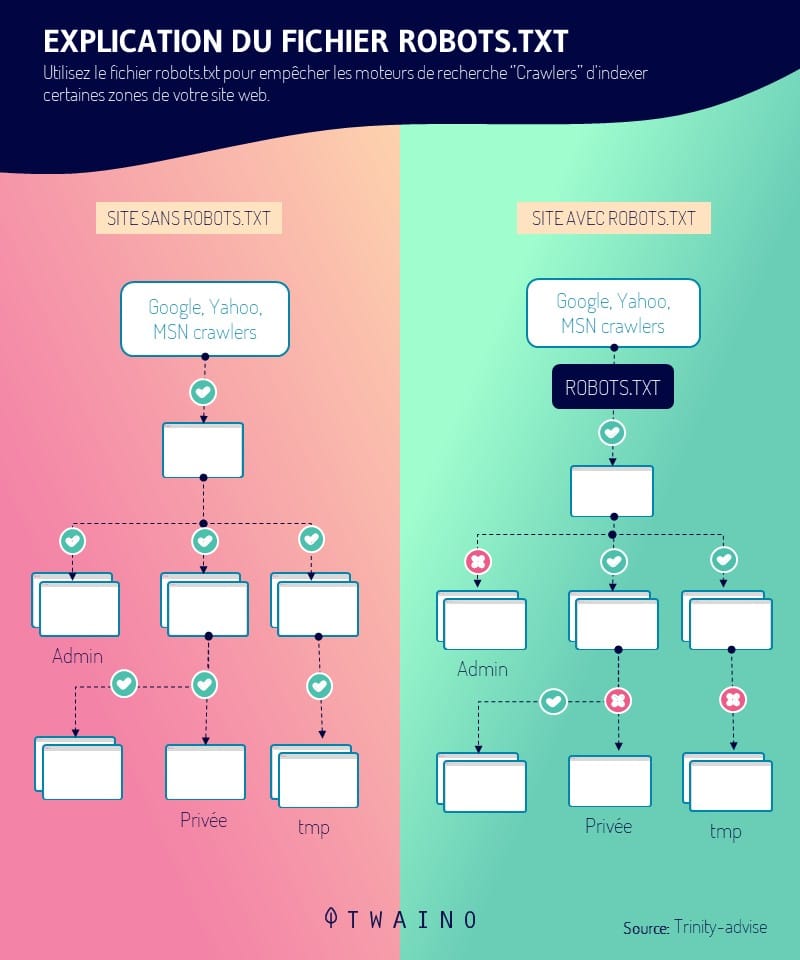

3.3. Blocco dell’accesso a determinate pagine per i crawler

Le varie impostazioni degli URL create per ordinare e filtrare le pagine web possono generare costantemente URL con contenuti duplicati

Quando scopre che il suo sito web ha molte impostazioni di URL, può decidere di bloccare alcuni accessi ai crawler e indicare quali pagine non devono essere indicizzate.

Dovrà inserire il tag di divieto per impedire a Googlebot di accedere alle sessioni del suo sito con contenuti duplicati. Questa è in realtà una tecnica che le dà la possibilità di controllare le varie azioni dei crawler sul suo sito.

Per farlo, è sufficiente inserire il file robots.txt per indicare ai motori di ricerca quali pagine devono essere carrellate e quali no. Ma prima è importante creare un link costante che punti alla pagina statica non impostata.

Poiché i crawler consultano il file robots.txt prima di iniziare la scansione di un sito web, questa tecnica è un ottimo modo per ottimizzare gli URL parametrizzati più rilevanti. La presenza del file robots.txt(disallow: /??tag=*) o (Disallow: /*?*) , ad esempio, impedirà l’accesso a qualsiasi URL con un punto interrogativo (?).

Deve quindi assicurarsi che anche altre parti del suo URL non contengano parametri, poiché questo tag impedirà a tutte le sessioni dell’URL di visualizzare questo simbolo. Utilizzando il file robots.txt per gestire il percorso del crawler, beneficia di vantaggi come

- Uso efficiente ed efficace del budget per le strisciate;

- Facilitare un’implementazione tecnica semplice;

- Limitare i problemi di contenuti duplicati;

- Applicabile a qualsiasi tipo di parametri URL.

3.4. inserire i tag canonici sugli URL parametrizzati

Dopo aver risolto i parametri dell’URL e aver deciso quale pagina statica deve essere ottimizzata e posizionata nelle SERP, può canonizzare gli URL parametrizzati che mostrano contenuti duplicati

I tag canonici rel=”canonical” sono attributi di collegamento che indicano ai crawler che una pagina web ha un contenuto duplicato o simile a un’altra pagina dello stesso sito.

Questi segnali consentono ai crawler di risparmiare il budget per il crawling e di consolidare gli sforzi di indicizzazione su URL rilevanti come canonici. Per quanto riguarda gli URL rilevanti che desidera indicizzare, può organizzarli e monitorare la SEO inserendo il tag rel=canonical.

Tuttavia, questa tecnica funziona correttamente solo quando il contenuto della pagina URL impostata assomiglia tipicamente alla pagina canonica. Con la canonizzazione dei suoi URL, ottiene vantaggi quali

- Consolidamento dei segnali di ranking agli URL statici o canonici delle pagine;

- Proteggere il suo sito da problemi di contenuti duplicati.

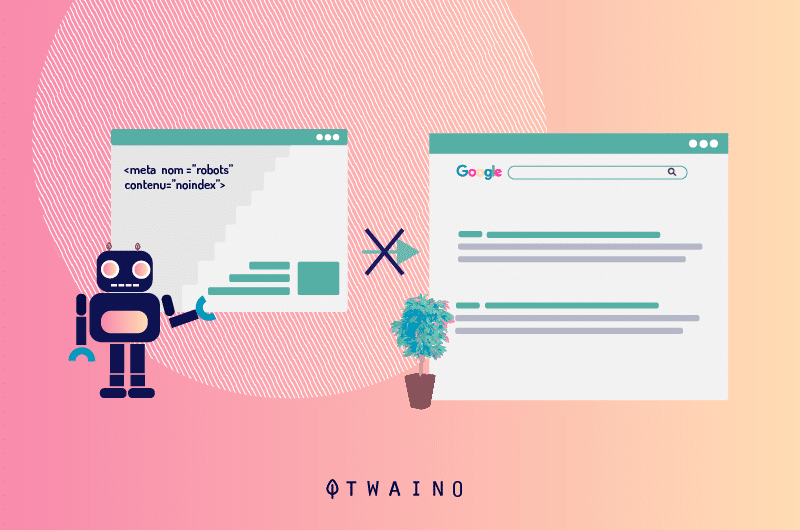

3.5. Utilizza un tag Noindex Meta Robots

Se specifica una direttiva noindex per le pagine con URL parametrizzati che contengono contenuti duplicati o non aggiungono alcun valore SEO, i crawler dei motori di ricerca non saranno più in grado di indicizzare queste pagine.

Tuttavia, la presenza di un tag “noindex” in un URL per un lungo periodo di tempo può anche far sì che i motori di ricerca smettano di seguire questi link.

3.6. Gestione delle impostazioni degli URL in Google Search Console

Quando le impostazioni degli URL tendono a danneggiare la SEO del suo sito, Google le invierà un avviso in Search Console, segnalandole che le impostazioni potrebbero causare il declassamento di molte delle sue pagine nei risultati di ricerca

La cosa più allarmante sono le pagine con contenuti duplicati che le impostazioni causano.

Sarebbe quindi molto utile imparare e padroneggiare la configurazione dei parametri URL in Search Console. Questo le permetterà di garantire l’integrità e l’autorità del suo sito, invece di lasciare che sia Googlebot a “decidere”

La cosa più importante è sapere come le impostazioni influenzano il contenuto delle sue pagine web.

- raccomandazione 1: impostare i parametri di tracciamento o i parametri URL passivi come URL rappresentativi. I parametri passivi o di tracciamento non modificano il contenuto delle pagine web. Pertanto, potrebbe preferirli ai parametri attivi.

- raccomandazione 2: inserire parametri attivi che organizzino il contenuto delle pagine web come “ordinamenti”. Se il parametro viene utilizzato dal visitatore, imposti Googlebot su“Nessun URL“.

Nel caso in cui l’impostazione dell’URL attivo sia utilizzata per impostazione predefinita, può impostarla su“Solo URL con valore” durante l’inserimento del valore predefinito.

- raccomandazione 3: impostare il crawling su“Nessun URL” per i filtri irrilevanti o che non hanno alcun beneficio SEO. Ma se ritiene che servano a qualcosa, può impostare il crawl su“Ogni URL“. Le impostazioni dei filtri selezionati come interessanti possono a loro volta essere impostate su “ristretto”.

- raccomandazione 4: le impostazioni che espongono gli elementi del sito o un gruppo di contenuti come “specifici” devono essere impostate su“Ogni URL“. Normalmente, questi parametri dovrebbero contenere un URL statico.

- raccomandazione 5: dovrebbe configurare le impostazioni che espongono una versione tradotta del contenuto della sua pagina web come“tradotta“. Se la traduzione non avviene di solito attraverso le sottocartelle, sarebbe meglio impostare questi parametri su“Ogni URL“.

- raccomandazione 6: configuri le impostazioni che visualizzano piccole sequenze di contenuti come “Paginazione”. Può impostare il crawl su “Nessun URL” per risparmiare il budget del crawl. Questo è vantaggioso se ha una struttura del sito XML che favorisce l’indicizzazione delle sue pagine. Altrimenti, imposti il crawling su“Ogni URL” per aiutare i crawler a passare.

In ogni caso, ci saranno delle impostazioni che Google aggiungerà per impostazione predefinita con il valore:“Lascia decidere a Googlebot“. Purtroppo, queste impostazioni non possono essere rimosse.

Fonte: Affde

Pertanto, è meglio configurare personalmente le impostazioni degli URL proattivi. Può decidere in qualsiasi momento di eliminare queste impostazioni in Google Search Console, se non servono più

NB: Le impostazioni che ha impostato su “Nessun URL” in Google devono essere aggiunte anche allo strumento “Ignora impostazioni URL” in Bing.

3.7. Converta l’URL dinamico in URL statico

Nel delineare i vari problemi che le impostazioni degli URL possono causare in un sito web, la maggior parte delle persone considera il divieto di tutte le impostazioni come una soluzione. È vero che questa è un’alternativa, ma non dimentichi che le sottocartelle sono un aiuto per Google.

Aiutano il motore di ricerca a capire la struttura del sito. Inoltre, gli URL statici con parole chiave pertinenti sono informazioni preziose che contribuiscono alla SEO del sito web. Per sfruttare questi URL, utilizzerà tecniche di riscrittura degli URL sul lato server per trasformare i parametri in URL di sottocartelle.

Esempio:

URL parametrizzato: www.example.com/view-product?id=482794

URL dopo la riscrittura: www.exemple.com/widgets/bleu

Questa tecnica funziona bene soprattutto con i parametri URL con parole chiave pertinenti alle query dei motori di ricerca. Ma questo metodo diventa un problema per i parametri di ricerca.

Questo perché ogni query effettuata dall’utente genererebbe una nuova pagina statica che diventa una pagina concorrente della pagina canonica per il ranking. Oppure, quando un utente cerca qualcosa che non è disponibile sul suo sito, la nuova pagina presenterebbe ai crawler un contenuto di bassa qualità che potrebbe non essere rilevante per la query.

Allo stesso modo, la conversione delle impostazioni degli URL dinamici in impostazioni statiche, in caso di eventi come la paginazione, i risultati della ricerca del sito o l’ordinamento, non risolve il problema dei contenuti duplicati né risparmia il budget per il crawling.

Sommario

Fondamentalmente, i parametri URL sono una pietra miliare per il funzionamento dei siti web

Sebbene presentino molti problemi SEO, come la creazione di contenuti duplicati, lo spreco di budget per il crawling…, i professionisti SEO esperti che hanno padroneggiato perfettamente il loro funzionamento traggono maggiori benefici.

In questo articolo, ho spiegato innanzitutto cosa significa un parametro URL, esponendo al contempo i possibili problemi che possono causare al suo sito e influire negativamente sul suo ranking

Le varie soluzioni ai problemi associati a queste stringhe di query che ho illustrato nell’ultima posizione la aiuteranno a integrare facilmente i parametri nell’URL del suo sito.

La cosa migliore di questi metodi è che può avere i parametri sul suo sito senza temere di perdere il suo posizionamento nelle SERP.

Le è piaciuto questo articolo? Ha qualche domanda sul funzionamento dei parametri di query? Non esiti a farmi la sua domanda nei commenti!