También conocidos como «cadenas de consulta» o «parámetros de consulta de la URL», los parámetros de la URL son un medio para rastrear la información y el tráfico de un sitio web. Son los datos dinámicos que se insertan en la cadena de URL tras la ejecución de la consulta para filtrar información adicional sobre un determinado sitio o para estructurar el contenido del mismo.

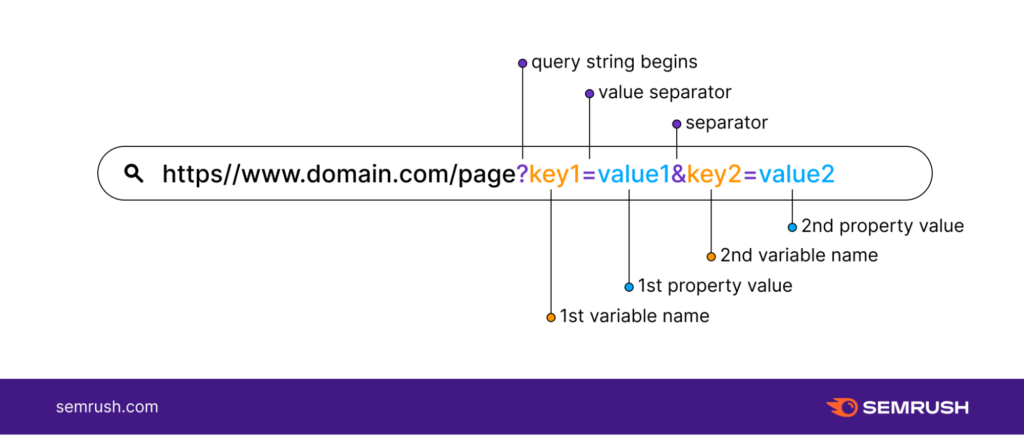

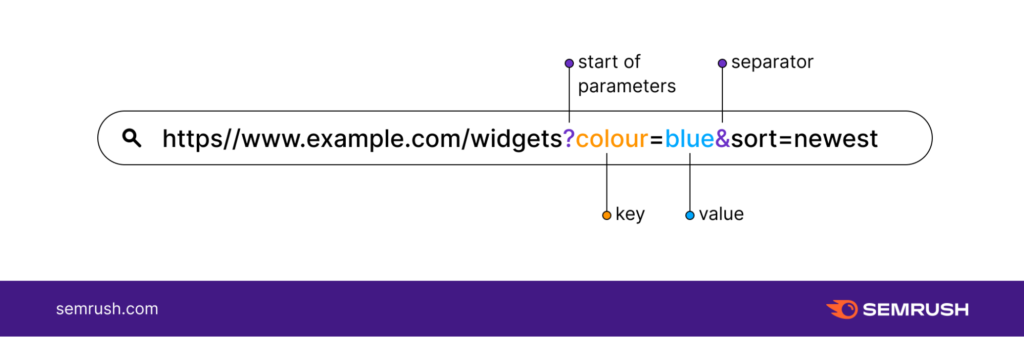

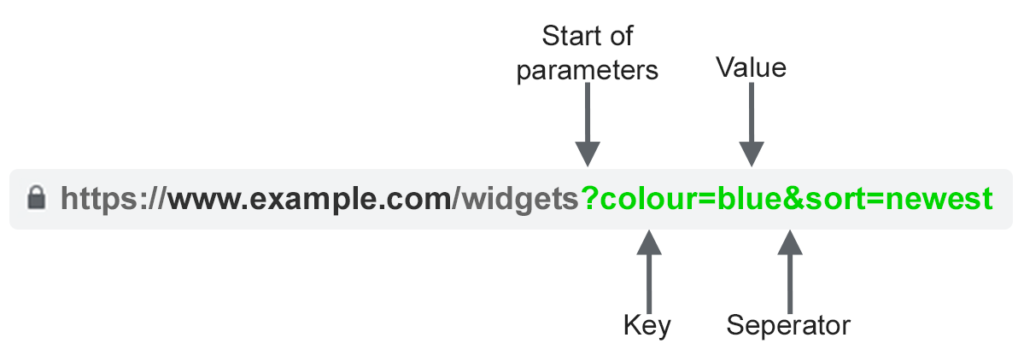

Los parámetros de la URL suelen encontrarse en la cadena después del símbolo (?). Constan de una clave y un valor separados por un signo de igualdad (=). Sin embargo, se pueden añadir varios parámetros de URL a una cadena separándolos con el símbolo del ampersand (&).

Las cadenas de consulta son una parte integral de la URL de un sitio web y son un gran activo para los profesionales de la SEO

Sin embargo, pueden ser la fuente de muchos problemas para los sitios web, especialmente a la hora de clasificar las páginas web en las SERP de Google.

- ¿Cómo resolver los problemas causados por los parámetros?

- ¿No vale la pena eliminar los parámetros de la URL?

En este artículo, explicaré en detalle el uso de las cadenas de consulta, desde la definición hasta las diferentes técnicas para resolver los problemas de los parámetros de la URL.

Capítulo 1: ¿Qué es un parámetro URL?

Los parámetros de la URL son elementos dinámicos de una cadena de consulta. Una cadena de consulta es la parte de la URL que sigue a un símbolo de interrogación (?).

Ejemplo: www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date

En esta cadena, todos los elementos que vienen después del (?) se denominan «parámetros de la URL».

1.1. ¿De qué están hechos los parámetros de la URL?

La constitución de una cadena URL aleatoria puede parecer muy complicada a primera vista. Sobre todo la mezcla de letras, números y símbolos le dará probablemente la impresión de un código bastante complicado de descifrar.

Pero en realidad, se puede dar sentido a todos los elementos o datos que componen una cadena de URL una vez que se llega a comprender la anatomía de un parámetro de URL. Estos son los diferentes elementos posibles que puede encontrar en una cadena de URL

- El signo de interrogación (?): El signo de interrogación marca el comienzo de un parámetro de la URL en una cadena de URL. Ejemplo: www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date (?threadid=64&sort=date) ;

- El ampersand: Los ampersands se utilizan cuando hay varios parámetros en la cadena URL. La presencia de un ampersand marca el final de un parámetro de la URL y el comienzo de otro. Ejemplo: (?threadid=64& sort=date=64& sort=date) ;

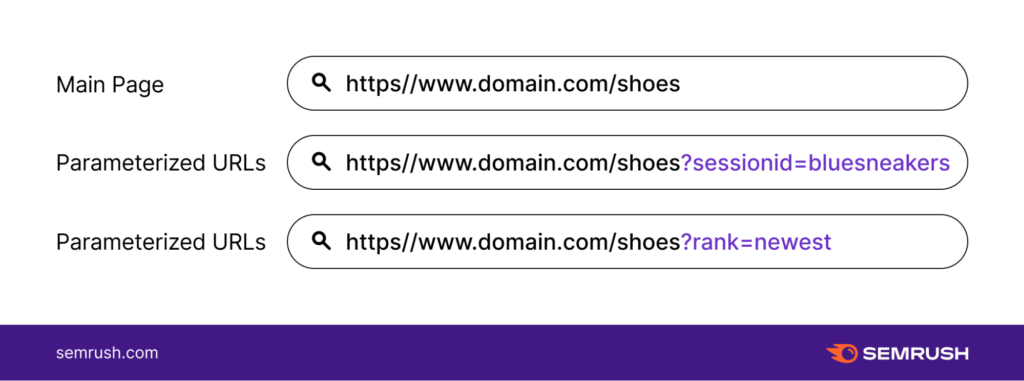

Fuente : SemRush

- El nombre de la variable o «Clave»: Es el título o la etiqueta del parámetro URL. Ejemplo: ?threadid=64&sort=date=64&sort=date;

- El valor: Es el valor específico separado del nombre de la variable por un signo de igualdad (=). Ejemplo: ?threadid=64&sort=date=64&sort=date.

Fuente: SemRush

Los parámetros de la URL se utilizan normalmente para realizar dos tareas principales: mejorar el contenido de una página y rastrear la información de los clics a través de la URL. De estos dos tipos de uso, se pueden distinguir dos parámetros principales de la URL, a saber Parámetros de URL activos y pasivos.

- Parámetros URL activos, también conocidos como parámetros modificadores de contenido: Este tipo de parámetro URL se utiliza para modificar el contenido de las páginas de un sitio web.

Ejemplo

- Reordenación del contenido: (?sort=price_ascending) «Mostrar el contenido en un orden determinado en una página web».

- Para segmentar el contenido de una página: (?página=1, ?página=2, ?página=3). Este parámetro de la URL se utiliza para segmentar el contenido grande en tres partes más pequeñas.

- Para limitar el contenido: (?type=yellow). Este parámetro de la URL se utiliza para que sólo aparezca el contenido «amarillo» en una página web.

Para redirigir un contenido concreto (A), por ejemplo, basta con insertar su cadena en el usuario web: http://domain.com?productid=A

- Parámetros de URL pasivos: A diferencia de los parámetros de URL activos, los pasivos no modifican el contenido de una página web, sino que se utilizan para el seguimiento de los clics a través de la URL. Estos parámetros le permiten disponer de toda la información sobre el clic, es decir, el origen, la campaña, etc. Estos datos serán útiles a la hora de evaluar el rendimiento de sus recientes campañas de marketing. Estos son algunos ejemplos de parámetros de URL pasivos.

Ejemplo

- Los parámetros de las URL pasivas pueden utilizarse para identificar las visitas o las sesiones de un sitio. Para rastrear el tráfico de su campaña de correo electrónico, puede insertar en la cadena: https://www.domain.com/?utm_source=emailing&utm_medium=email.

- Los parámetros de la URL pueden utilizarse para identificar el origen y todos los datos (fuente, medio e incluso campaña) relacionados con una visita a un sitio web. Para recoger los datos de la campaña: https://www.domain.com/?utm_source=twitter&utm_medium=tweet&utm_campaign=summer-sale.

- Por último, los parámetros de la URL también pueden actuar como identificadores de los afiliados. Esta función la utilizan a menudo los blogueros y los influencers para generar ingresos por clic.

1.2. ¿cómo aplicar los parámetros de la URL?

En las tiendas online, por ejemplo, los parámetros de consulta de la URL se utilizan habitualmente para facilitar la navegación a los usuarios. De hecho, los parámetros se ejecutan en este caso para ordenar y seleccionar páginas de categorías específicas.

Esto permite redirigir al usuario directamente a los productos que puedan interesarle. También podrán mostrar un número definido de artículos por página ordenando las páginas según los filtros.

Además, los parámetros de URL pasivos son muy utilizados por los profesionales del marketing digital. Estas métricas les permiten rastrear de dónde procede el tráfico de su sitio web para determinar el alcance o el éxito de su última inversión en una estrategia de marketing digital.

Fuente: SemRush

Estos son algunos de los casos de uso más comunes de las métricas de URL:

- Filtrado de contenidos: Elegir qué páginas mostrar en función de los colores y precios de los productos en una tienda online, por ejemplo: ?type=widget, color=azul o ?price-range=20-50 ;

- Seguimiento del tráfico: ?utm_medium=social, ?sessionid=123 o ?affiliateid=abc ;

- Traducción: ?lang=es, ?language=de o ;

- Reorganización de los contenidos de una página web: ?sort=precio más bajo, ?order=más valorado o ?so=más nuevo;

- Identificación de un producto en una categoría: ?product=small-blue-widget, categoryid=124 o itemid=24AU ;

- Segmentar el contenido de una página: ?page=2, ?p=2 o viewItems=10-30 ;

- Realización de una búsqueda específica: ?query=consulta-usuario, ?q=consulta-usuario o ?search=opción-descenso.

Capítulo 2: Los diversos problemas de SEO causados por los parámetros de la URL

Por muy buenos y útiles que sean, es importante que cualquier SEO o experto en SEO modere o se mantenga alejado del uso de los parámetros de URL en la medida de lo posible. Esto se debe a que los parámetros de la URL tienden a crear muchos problemas que pueden afectar al SEO de un sitio web.

Entre ellos se encuentran los problemas relacionados con el consumo excesivo del crawl budget, que impiden a los rastreadores rastrear las páginas web e indexarlas. Un error en la estructuración de los parámetros de la URL pasiva, por ejemplo, puede conducir a la creación de contenido duplicado.

En este capítulo, encontrará los probables problemas que podrían ser un obstáculo para la SEO de su sitio web causados por los parámetros de la URL.

2.1. Creación de contenidos duplicados

Google y otros motores de búsqueda consideran cada URL como una página web completa. Como resultado, las múltiples versiones de la misma página creadas con parámetros de URL se considerarán páginas independientes y, por tanto, contenido duplicado.

Utilizar los parámetros de la URL activa para reorganizar una página web no supone un gran cambio en la página original. Algunos parámetros de URL utilizados para reorganizar una página web pueden incluso presentar exactamente la misma página que la original.

Del mismo modo, la URL de una página web con etiquetas de seguimiento o un identificador de tráfico es idéntica a la URL original.

Ejemplo

- URL estática: https://www.example.com / widgets

- Parámetro de seguimiento: https://www.example.com/widgets ?sessionID=32764

- Parámetro de reordenación: https://www.example.com /widgets?sort=newest

- Parámetro de identificación: https://www.example.com ?category=widgets

- Parámetro de búsqueda: https://www.example.com/products ?search=widget

Puede ver que hay varias URLs que tienen todas el mismo contenido. Si tiene una tienda online y hace esto para cada categoría, se irá sumando y tendrá un número considerable de URLs.

El problema es cuando los rastreadores de Google visitan su sitio. Una URL encontrada es considerada como una nueva página por los rastreadores. Por lo tanto, tratarán cada parámetro de la URL como una página independiente.

Por lo tanto, descubrirán contenidos duplicados que tratan el mismo tema semántico en sus diferentes URLs consideradas como páginas diferentes. No hace falta decir que el contenido duplicado es una de las infracciones castigadas por Google.

E incluso si la presencia de estos parámetros de URL que crean contenido duplicado no es motivo suficiente para que Google prohíba su sitio en las SERP, sí pueden provocar una canibalización de palabras clave.

2.2. desperdiciar el presupuesto de rastreo

Una estructura de URL bastante sencilla es una ventaja para la optimización de su sitio. Un buen mapa del sitio permite a los rastreadores rastrear fácilmente las diferentes páginas de su sitio sin consumir mucho ancho de banda.

Por otro lado, las URLs complejas que contienen muchos parámetros provocan la creación de muchas URLs que apuntan al mismo contenido. Esto hace que la estructura de su sitio web sea más compleja y hace perder el tiempo a los rastreadores.

El rastreo o el rastreo de un sitio con una estructura muy compleja puede agotar el presupuesto de rastreo y reducir la capacidad de los rastreadores de indexar sus páginas web para clasificarlas en las SERP.

2.3. Los parámetros de la URL conducen a la canibalización de las palabras clave

Dado que los diferentes parámetros añadidos a la URL original se dirigen al mismo contenido y, por tanto, a las mismas palabras clave, la indexación puede poner en competencia diferentes páginas dirigidas a las mismas palabras clave.

Este hecho puede llevar a los robots de indexación a devaluar estas palabras clave. Pueden considerar que todas las páginas que contienen estas palabras clave no aportan ningún valor añadido a los usuarios.

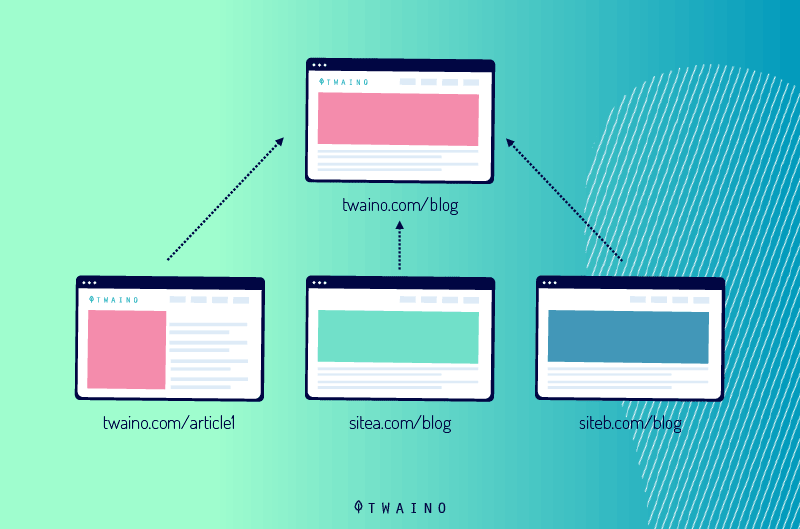

2.4. Los parámetros de la URL diluyen las señales de clasificación

Si tiene varios parámetros de URL que apunten al mismo contenido, las visitas procedentes de las redes sociales y los enlaces irán a cualquier versión de su página

Esto no sólo le hará perder tráfico, sino que sus páginas no se clasificarán bien.

En efecto, la diversificación de las visitas confundirá a los rastreadores y, por tanto, diluirá sus señales de clasificación. Los bots se volverán inseguros y tendrán dificultades para saber cuál de las páginas competidoras debe posicionarse en los resultados de búsqueda.

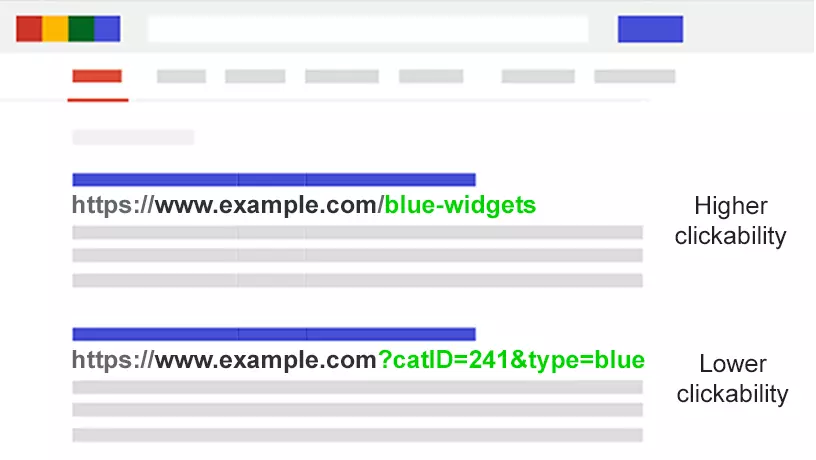

2.5. Los parámetros de las URL hacen que éstas sean menos atractivas

Para una mejor optimización de su sitio web, sus URL deben ser estéticamente agradables, legibles y fáciles de entender. Una URL con parámetros suele ser compleja e ilegible para los visitantes.

La presentación de una URL parametrizada no refleja confianza porque parecen ser spam. Por lo tanto, es poco probable que los usuarios hagan clic o compartan.

Por lo tanto, la configuración de la URL puede tener un impacto negativo en el rendimiento de sus páginas web. En primer lugar, el CTR puede ser parte de la razón de la clasificación.

Fuente: searchenginejournal

Pero sus páginas no se benefician de esta razón porque la complejidad de las URLs ralentizará la tasa de clics. En segundo lugar, el tráfico de las redes sociales, los correos electrónicos… también disminuirá porque los usuarios sospecharán de su URL parametrizada.

Hay que tener en cuenta que la implicación de compartir tuits, correos electrónicos… en el desarrollo de la notoriedad de una página web no es tan mínima

Básicamente, la mala legibilidad de las URL de su sitio web puede ser un obstáculo para el compromiso de su marca con los clientes o los usuarios de Internet en general.

Capítulo 3: ¿Cómo puede gestionar los parámetros de las URL para que no afecten al SEO de su sitio?

La mayoría de los problemas de SEO causados por los parámetros de URL que he mencionado en el capítulo anterior tienen una cosa en común: el rastreo y la indexación de las URL parametrizadas. Sin embargo, esto no impide la generación de nuevas URL parametrizadas en los sitios web.

Descubra cómo resolver los problemas de los parámetros de las URLs y crear nuevas URLs mediante parámetros sin causar problemas de SEO para sus páginas web.

3.1. Determine el alcance de los problemas de los parámetros de la URL

Antes de iniciar el proceso de resolución de problemas de parámetros de URL en un sitio web, es importante conocer primero todos los parámetros que se insertan en la URL del sitio

A menos que su desarrollador tenga una lista completa de todos los parámetros de la URL, será un verdadero dolor de cabeza identificar todos los parámetros insertados en la URL de su sitio.

Afortunadamente, no tiene que asustarse por esto

Le mostraré en cinco pasos cómo puede encontrar todos los parámetros de la URL, así como el comportamiento de los robots de indexación.

- Utilizando un rastreador: Al ejecutar un rastreador como Screaming Frog, puede encontrar una lista de todos los parámetros utilizados en la URL de su sitio. Sólo tiene que buscar el símbolo (?) en la URL y recibirá todos los parámetros.

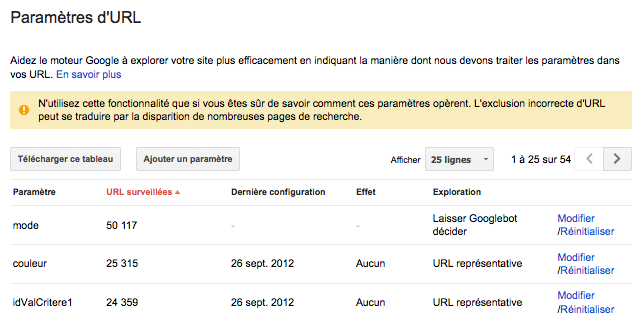

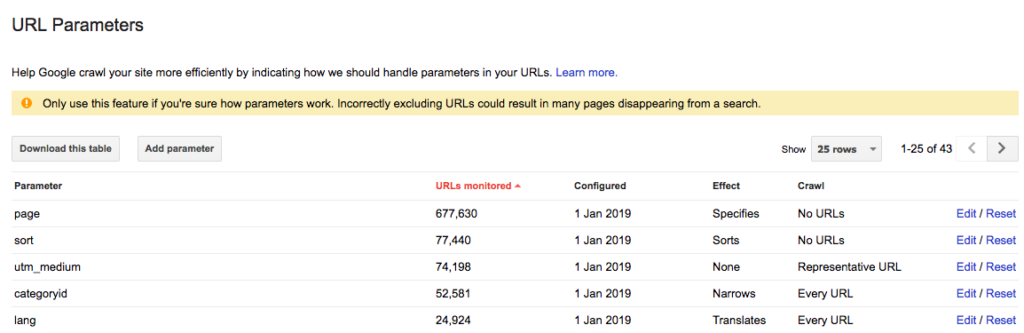

- Compruebe en Google Search Console, concretamente en la herramienta de configuración de URL. Google añade allí automáticamente las cadenas de consulta. Así que puede encontrar los parámetros de la URL en Search Console.

Fuente: WebRankInfo

- Analizar los archivos de registro: También puede ver en los archivos de registro si los rastreadores de Google han visitado URLs con parámetros.

- Haga una consulta combinada con: inurl. Al insertar la clave: inurl en una consulta combinada como: ejemplo.com inurl:clave, puede averiguar cómo los rastreadores de Google están indexando los parámetros de la URL que se encuentra en su sitio.

- Busque en el informe de Google Analytics todos los parámetros de la URL: Puede buscar el símbolo (?) en Google Analytics para ver cómo interactúan sus usuarios con los parámetros de la URL. Pero antes de hacerlo, es importante comprobar primero si los parámetros de la URL están presentes en el parámetro de visualización.

Con estos datos, ahora puede pensar en cómo gestionar cada uno de los parámetros de la URL.

3.2. Compruebe constantemente su presupuesto de rastreo y limite la configuración de las URL

El número total de páginas que los robots de Google u otros rastreadores de motores de búsqueda deben visitar en su sitio se denomina crawl budget. El presupuesto de rastreo es diferente de un sitio a otro porque no todos los sitios tienen el mismo número de páginas web.

Por lo tanto, es necesario asegurarse de que su presupuesto de rastreo no se desperdicie. Como se mencionó en el capítulo anterior, tener muchas URLs en su sitio agota rápidamente su presupuesto de rastreo.

Para gestionar este problema, puede hacer un rápido análisis sobre la utilidad de cada parámetro que haya generado para la SEO del sitio. Este análisis le permitirá ordenar los parámetros y eliminar los menos interesantes.

En cualquier caso, encontrará una razón para reducir el conjunto de URLs y así ahorrar el presupuesto de rastreo. Puede seguir el siguiente proceso para reducir el número de URLs establecidas en su sitio y minimizar su impacto en el SEO.

3.2.1. Ordenar y eliminar los parámetros innecesarios

Comience por solicitar a su desarrollador una lista completa de todas las configuraciones de URL generadas en el sitio o utilice uno de los métodos descritos en el subcapítulo 3.1. para obtener una lista de todas las configuraciones de URL de su sitio

En esta lista, es probable que encuentre parámetros que no cumplen una función beneficiosa

También puede definir los criterios de evaluación que le permitirán seleccionar qué configuraciones de URL son valiosas y cuáles no

Puede utilizar el parámetro sessionID, por ejemplo, para identificar un grupo de usuarios en su sitio en un momento determinado.

Este parámetro permanecerá en la cadena de URL aunque ya no lo utilice. En realidad, las cookies son mejores para identificar a los usuarios en general. Por lo tanto, el parámetro sessionID ya no es necesario en la cadena URL. Así que puede eliminarlo.

Del mismo modo, es posible que uno de los filtros del navegador no sea utilizado nunca por los visitantes. Todos estos parámetros de consulta de URL innecesarios deben ser eliminados.

3.2.2. Valores límite sin función específica

Los parámetros que debe añadir a su URL sólo serán útiles si tienen una función específica que realizar. Por lo tanto, debe evitar añadir un parámetro si su valor está vacío.

3.2.3 Inserción de claves únicas

Excepto en el caso de la selección múltiple, debe evitar insertar varios parámetros con el mismo nombre de variable (Clave) con valores diferentes. En el caso de las opciones de selección múltiple, es incluso aconsejable agrupar los valores después de una sola tecla.

3.2.4. Organizar los parámetros de la URL

Es cierto que el orden en el que están presentes los parámetros de la URL no importa mucho ni excluye el contenido duplicado. Incluso si reordena los parámetros, los rastreadores seguirán considerando las diferentes páginas como idénticas.

Sin embargo, cada combinación de los diferentes parámetros agota el presupuesto de rastreo y, por tanto, impide que Googlebot rastree todo su sitio para clasificar las páginas merecidas.

Puede contrarrestar este problema exigiendo a su desarrollador un orden coherente a la hora de escribir scripts de parámetros de URL. No hay un orden establecido que deba seguirse, pero lógicamente siempre debe comenzar con los parámetros de traducción, luego los deidentificación, después los de paginación, luego los de superposición de filtros y finalmente los de seguimiento.

Fuente: Affde

Este método ofrece varias ventajas, especialmente en el sentido de referenciar su sitio

Estos incluyen

- Garantizar un uso normal del presupuesto de rastreo;

- Minimizar los problemas de contenido duplicado;

- Las señales de clasificación están más consolidadas en otras páginas del sitio;

- Dar claridad y legibilidad a su URL, lo que puede animar a la gente a hacer clic y compartir su URL a través de las redes sociales, el correo electrónico, etc.

3.3. Bloqueo del acceso a determinadas páginas para los rastreadores

Las distintas configuraciones de URL que se crean para clasificar y filtrar las páginas web pueden generar constantemente URL con contenido duplicado

Cuando vea que su sitio web tiene muchas configuraciones de URL, puede decidir bloquear ciertos accesos a los rastreadores e indicar qué páginas no deben ser indexadas.

Deberá insertar la etiqueta de prohibición para evitar que Googlebot acceda a las sesiones de su sitio con contenido duplicado. En realidad, se trata de una técnica que le permite controlar las distintas acciones de los rastreadores en su sitio.

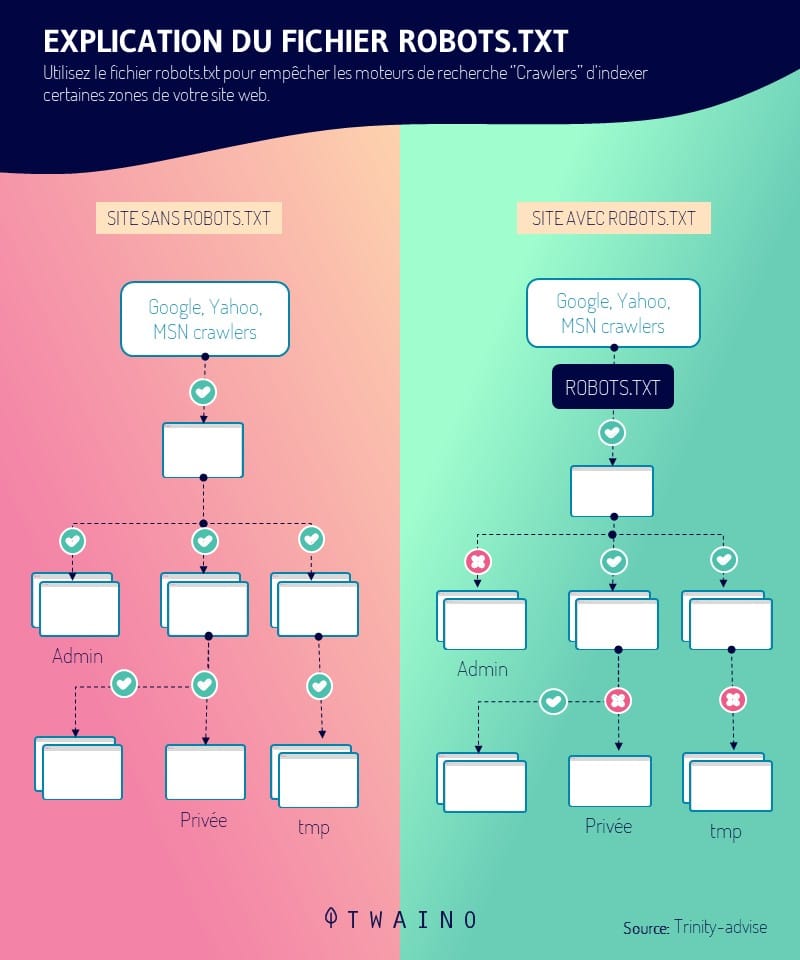

Para ello, basta con introducir el archivo robots.txt para mostrar a los motores de búsqueda qué páginas deben ser rastreadas y cuáles no. Pero primero, es importante crear un enlace constante que apunte a la página estática que no está configurada.

Dado que los rastreadores consultan primero el archivo robots.txt antes de empezar a rastrear un sitio web, esta técnica es una gran manera de optimizar sus URLs parametrizadas más relevantes. La presencia del archivo robots.txt(disallow: /??tag=*) o (Disallow: /*?*) , por ejemplo, impedirá el acceso a cualquier URL con un signo de interrogación (?).

Por lo tanto, debe asegurarse de que otras partes de su URL no contengan también parámetros, ya que esta etiqueta impedirá que todas las sesiones de la URL muestren este símbolo. Al utilizar el archivo robots.txt para gestionar la ruta del rastreador, se beneficia de ventajas como

- Uso eficiente y eficaz del presupuesto de rastreo;

- Facilitar una implementación técnica sencilla;

- Limitar los problemas de contenido duplicado;

- Aplicable a cualquier tipo de parámetros de URL.

3.4. insertar etiquetas canónicas en las URL parametrizadas

Después de ordenar los parámetros de la URL y decidir finalmente qué página estática debe optimizarse y posicionarse en las SERP, puede canonizar las URL parametrizadas que muestren contenido duplicado

Las etiquetas canónicas rel=»canonical» son atributos de enlace que indican a los rastreadores que una página web tiene un contenido duplicado o similar al de otra página del mismo sitio.

Estas señales permiten a los rastreadores ahorrar presupuesto de rastreo y consolidar los esfuerzos de indexación en las URLs relevantes como canónicas. En cuanto a las URLs relevantes que desea indexar, puede organizarlas y hacer un seguimiento de la SEO insertando la etiqueta rel=canonical.

Sin embargo, esta técnica sólo funciona correctamente cuando el contenido de la página de la URL establecida suele parecerse a la página canónica. Al canonizar sus URLs, obtendrá beneficios como

- Consolidación de las señales de clasificación a las URL de páginas estáticas o canónicas;

- Proteger su sitio de los problemas de contenido duplicado.

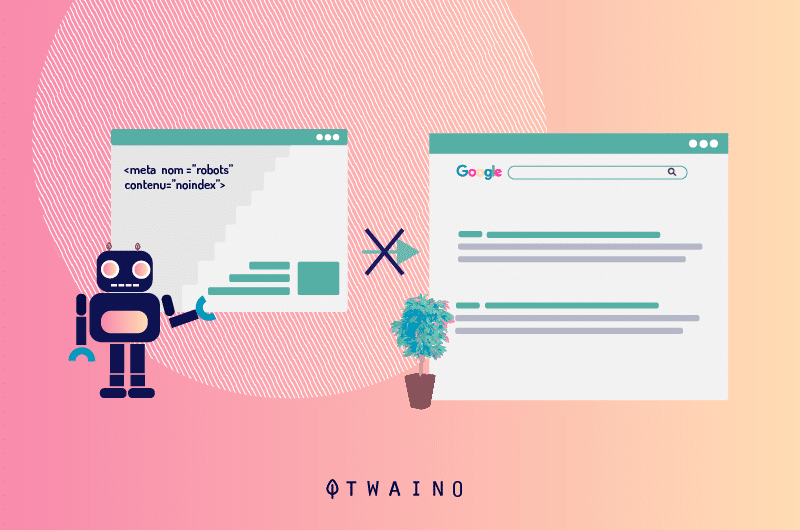

3.5. Uso de una etiqueta Meta Robots Noindex

Si especifica una directiva noindex para las páginas con URLs parametrizadas que contienen contenido duplicado o no aportan ningún valor SEO, los rastreadores de los motores de búsqueda ya no podrán indexar estas páginas.

Sin embargo, la presencia de una etiqueta «noindex» en una URL durante un largo periodo de tiempo también puede hacer que los motores de búsqueda dejen de seguir estos enlaces.

3.6. Gestión de la configuración de la URL en Google Search Console

Cuando la configuración de la URL tiende a perjudicar el SEO de su sitio, Google le enviará una advertencia en Search Console de que la configuración podría hacer que muchas de sus páginas bajen de categoría en los resultados de búsqueda

Lo más alarmante son las páginas con contenido duplicado que provocan los ajustes.

Por lo tanto, sería muy beneficioso aprender y dominar la configuración de los parámetros de la URL en Search Console. Esto le permitirá asegurar la integridad y la autoridad de su sitio en lugar de dejar que Googlebot «decida»

Lo más importante es saber cómo afectan los ajustes al contenido de sus páginas web.

- recomendación 1: Establezca parámetros de seguimiento o parámetros de URL pasivos como URLs representativas. Los parámetros pasivos o de seguimiento no cambian el contenido de las páginas web. Por lo tanto, es posible que los prefiera a los parámetros activos.

- recomendación 2: Insertar parámetros activos que organicen el contenido de las páginas web como «ordenaciones». Si el parámetro es utilizado por el visitante, establece Googlebot como«Sin URL«.

En caso de que la configuración de la URL activa se utilice por defecto, puede ajustarla a«Sólo URLs con valor» mientras inserta el valor por defecto.

- recomendación 3: Establezca el rastreo en«Sin URLs» para los filtros que son irrelevantes o no tienen ningún beneficio para el SEO. Pero si cree que sirven para algo, puede establecer el rastreo en«Cada URL«. Los ajustes de los filtros que se seleccionan como interesantes pueden, a su vez, establecerse como «estrechos».

- recomendación 4: Los ajustes que exponen los elementos del sitio o un grupo de contenidos como «específicos» deben establecerse en«Cada URL«. Normalmente, estos ajustes deben incorporar una URL estática.

- recomendación 5: Debería configurar los ajustes que exponen una versión traducida del contenido de su página web como«traducido«. Si la traducción no suele realizarse a través de subcarpetas, lo mejor sería establecer estos parámetros en«Cada URL«.

- recomendación 6: Configure los ajustes que muestran pequeñas secuencias de contenido como «Paginación». Puede establecer el rastreo en «Sin URL» para ahorrar el presupuesto de rastreo. Esto es beneficioso si tiene una estructura de sitio XML que promueve la indexación de sus páginas. De lo contrario, configure el rastreo en«Cada URL» para ayudar a los rastreadores a pasar.

En cualquier caso, habrá ajustes que Google añadirá por defecto bajo el valor:«Dejar que Googlebot decida«. Lamentablemente, estos ajustes no se pueden eliminar.

Fuente: Affde

Por lo tanto, es mejor que configure usted mismo los ajustes de la URL proactiva. Puede decidir en cualquier momento eliminar estos ajustes en Google Search Console, si ya no sirven para nada

NB: Los ajustes que haya establecido en «Sin URL» en Google también deben añadirse a la herramienta «Ignorar ajustes de URL» en Bing.

3.7. Convertir una URL dinámica en una URL estática

Al esbozar los diversos problemas que los ajustes de la URL pueden causar en un sitio web, la mayoría de la gente considera que prohibir todos los ajustes es una solución. Es cierto que es una alternativa, pero no olvide que las subcarpetas son una ayuda para Google.

Ayudan al motor de búsqueda a entender la estructura del sitio. Además, las URL estáticas con palabras clave relevantes son piezas de información valiosas que contribuyen al SEO del sitio web. Para aprovechar estas URL, utilizará técnicas de reescritura de URL en el lado del servidor para transformar los parámetros en URL de subcarpetas.

Ejemplo:

URL parametrizada: www.example.com/view-product?id=482794

URL después de la reescritura: www.exemple.com/widgets/bleu

Esta técnica funciona bien especialmente con parámetros de URL con palabras clave relevantes de las consultas de los motores de búsqueda. Pero, este método se convierte en un problema para los parámetros de búsqueda.

Esto se debe a que cada consulta realizada por el usuario generaría una nueva página estática que se convierte en una página competidora de la página canónica para la clasificación. O bien, cuando un usuario viene buscando algo que no está disponible en su sitio, la nueva página presentaría a los rastreadores un contenido de baja calidad que podría no ser relevante para la consulta.

Del mismo modo, convertir las configuraciones dinámicas de las URL en configuraciones estáticas en la ocurrencia de cosas como la paginación, los resultados de la búsqueda del sitio o la clasificación, no soluciona el problema del contenido duplicado ni ahorra el presupuesto de rastreo.

Resumen

Básicamente, los parámetros de la URL son una piedra angular para el funcionamiento de los sitios web

Aunque presentan muchos problemas de SEO como la creación de contenido duplicado, el derroche de crawl budget…, los profesionales de SEO experimentados que dominan su funcionamiento sacan más provecho.

En este artículo, he explicado en primer lugar lo que significa un parámetro de URL, al tiempo que he expuesto los posibles problemas que pueden causar en su sitio y que pueden afectar negativamente a su clasificación

Las diversas soluciones a los problemas asociados a estas cadenas de consulta que he detallado en el último puesto le ayudarán a integrar fácilmente los parámetros en la URL de su sitio.

Lo mejor de estos métodos es que puede tener los parámetros en su sitio sin temor a perder su clasificación en las SERP.

¿Le ha gustado este artículo? ¿Tiene alguna pregunta sobre el funcionamiento de los parámetros de consulta? ¡No dude en hacerme su pregunta en los comentarios!