Disallow es una directiva que los webmasters utilizan para gestionar los rastreadores de los motores de búsqueda. El objetivo principal de esta directiva es indicar a estos robots en un archivo Robots.txt que no rastreen la página o el archivo específico de un sitio web. Por el contrario, tenemos la directiva Allow, que indica a los rastreadores que pueden acceder a estos mismos elementos

La creación de contenidos de calidad y los vínculos de retroceso son técnicas populares para clasificar un sitio. Aunque estas técnicas dominan, hay muchas otras que contribuyen al SEO de un sitio web.

Lamentablemente, la mayoría de estas técnicas no son muy conocidas, aunque algunas de ellas han demostrado ser verdaderas ventajas para referenciar un sitio.

Este es el caso del archivo robots.txt, un archivo que comunica a los motores de búsqueda, a través de varias directivas, cómo explorar las páginas de un sitio web. Entre estas directivas, destaca la de Disallow. Es una poderosa herramienta capaz de influir en la referenciación de un sitio.

En este artículo, aprenderemos sobre la directiva Disallow y su utilidad para el SEO. Por último, exploraremos algunas de las mejores prácticas para evitar errores al utilizarlo.

Capítulo 1: ¿Qué es la directiva Disallow y cómo es útil en el SEO?

La directiva Disallow es una práctica legítima de SEO que muchos webmasters ya utilizan. Este capítulo está dedicado a la definición de esta directiva y a su importancia en el mundo del SEO.

1. ¿Qué es la directiva Disallow?

Al igual que otras etiquetas como Nofollow, la directiva Disallow influye en el comportamiento de rastreadores como Googlebot y Bingbot hacia determinadas secciones de un sitio web.

Estos rastreadores funcionan como archivistas de Internet, recogiendo contenidos de la web y catalogándolos. Para ello, rastrean todos los sitios web para descubrir nuevas páginas e indexarlas.

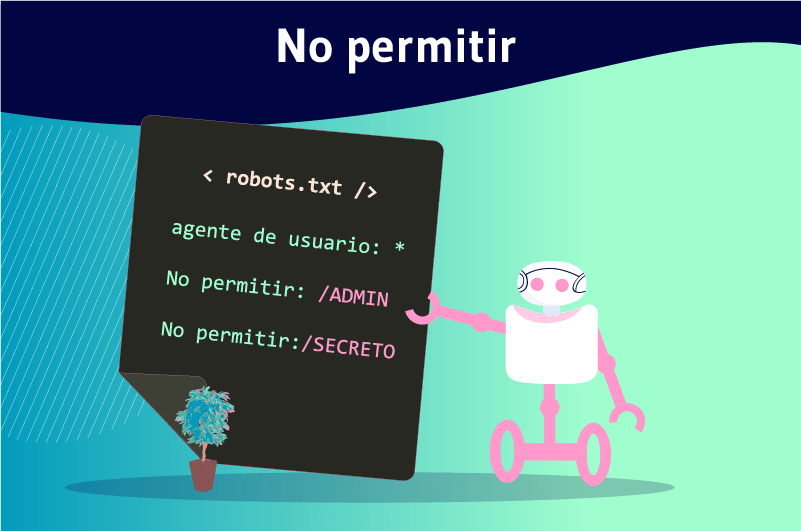

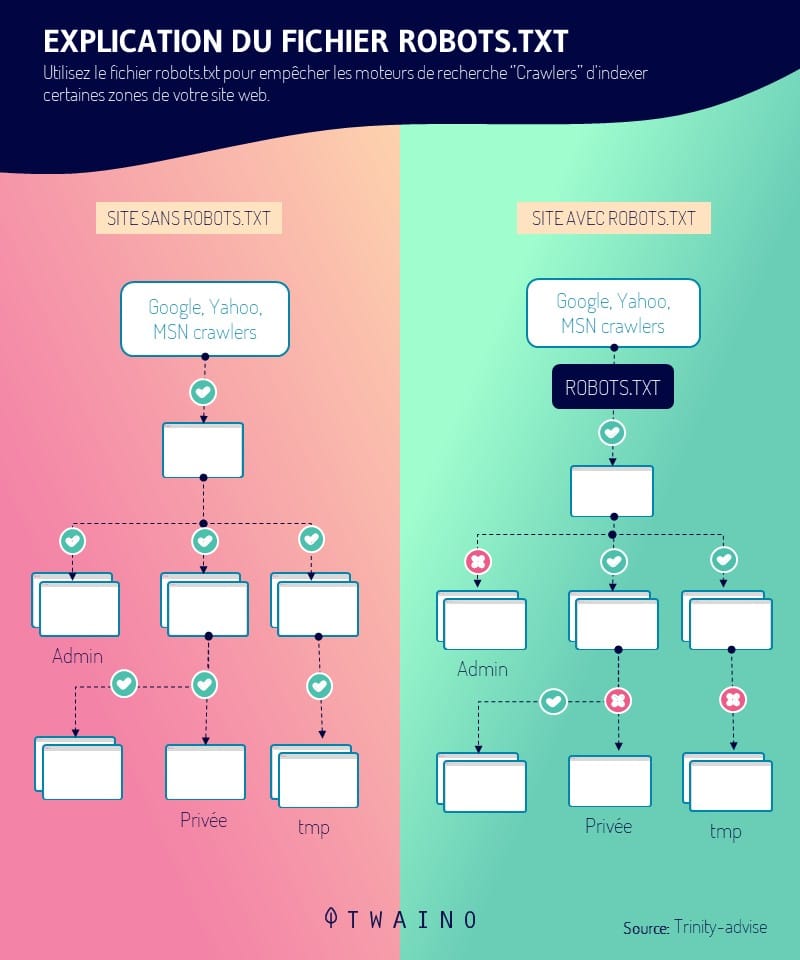

Los webmasters pueden dar varias instrucciones a los rastreadores que acceden a sus sitios a través de un archivo robots.txt. La directiva Disallow es una de estas instrucciones.

Permite a los administradores de sitios web bloquear el acceso a determinados recursos de un sitio web. Como resultado, los rastreadores web no podrán rastrear las URLs que estén bloqueadas mediante la directiva Disallow.

Esta directiva se utiliza a veces junto con la directiva permitir directiva. A diferencia de la directiva Disallow, da acceso a los navegadores y les indica qué recursos deben explorar.

Hay que recordar que sólo los robots de los motores de búsqueda entienden el lenguaje utilizado en el archivo robot.txt. Los bots que no utilizan este lenguaje, como los maliciosos, pueden por tanto acceder a los recursos bloqueados por la directiva Disallow.

1.2 ¿Dónde se encuentra la directiva Disallow?

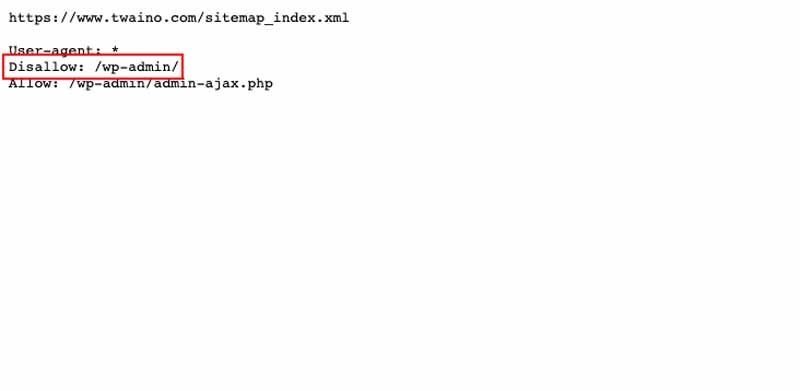

La directiva Disallow se incluye en un archivo robots.txt como se ha mencionado anteriormente. Este archivo se encuentra en la raíz de un sitio en el nivel superior (www.votresite.com/robots.txt).

Los robots sólo pueden encontrar el archivo robots.txt en la ubicación mencionada anteriormente. El nombre correcto es robots.txt y otras entradas como Robots.txt o robots.TXT son simplemente ignorados.

El archivo robots.txt tiene otras directivas que son :

- Disallow ;

- Denegar ;

- Orden ;

- Etc.

El archivo robots.txt sigue siendo de acceso público y puede ser consultado para cualquier sitio web. Aparece cuando se añade «/robots.txt» al final de un dominio. Esto le permite ver todas las directivas de un sitio cuando tiene este archivo.

El enlace para abrir en su navegador tiene el siguiente aspecto: www.votresite.com/robots.txt. Cuando el archivo robots.txt no se encuentra en esta dirección, los robots asumen que el sitio no tiene dicho archivo.

1.3. ¿Cuál es la importancia de la directiva Disallow?

La directiva Disallow puede utilizarse por muchas razones. Junto con las demás directivas del archivo robots.txt, ayuda a mejorar la clasificación de un sitio.

Estas directivas ayudan a dirigir a los rastreadores a los recursos y a rastrear sólo aquellos que son útiles.

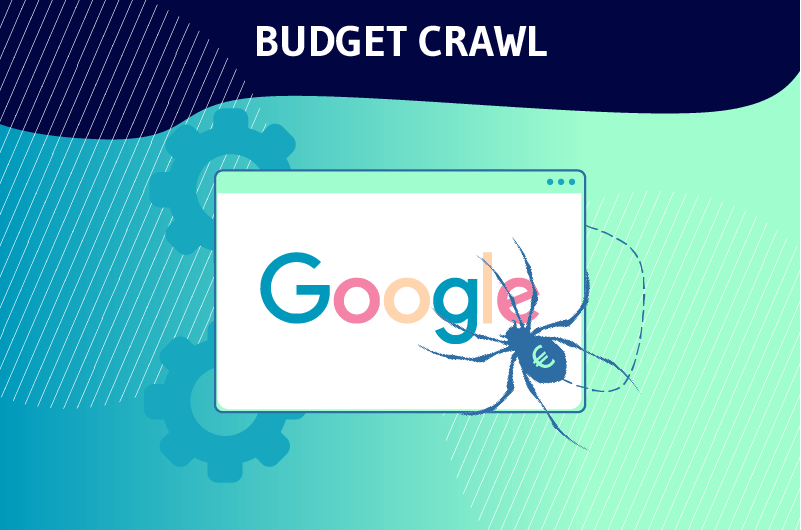

1.3.1. Optimización del presupuesto de rastreo

La directiva Disallow se utiliza a menudo para prohibir a los rastreadores el rastreo de páginas que no son de verdadero interés para el SEO de un sitio web. Esto es lo que Google intenta explicar en el siguiente pasaje:

«No querrá que su servidor se vea abrumado por el rastreador de Google o que desperdicie su presupuesto de rastreo en páginas sin importancia o similares de su sitio.«

En términos sencillos, Google asigna a sus bots un llamado crawl budget para cada sitio web. Este presupuesto es el número de URLs que los Googlebots pueden rastrear en el sitio.

Pero cuando los robots llegan a un sitio, comienzan a rastrear cada una de sus páginas. Cuantas más páginas tenga un sitio, más tiempo tardará en rastrearse.

Por eso debe ayudar a los bots a ignorar las páginas sin importancia con la directiva Disallow y dirigirlos con Allow a las páginas importantes que merecen ser clasificadas.

Dicho esto, al poner buenas instrucciones en el archivo robots.txt con Disallow, los webmasters ayudan a los bots a gastar el presupuesto de rastreo sabiamente. Esta es una de las razones por las que la directiva Disallow es particularmente útil para el SEO.

Además, la directiva Disallow mantiene las secciones de un sitio web en privado y ayuda a evitar la sobrecarga del servidor. También puede utilizarse para evitar que ciertos recursos, como las imágenes o los vídeos, aparezcan en los resultados de las búsquedas.

1.3.2. ¿Disallow impide que una página sea indexada?

La directiva Disallow no impide que una página sea indexada, sino que impide que sea rastreada.

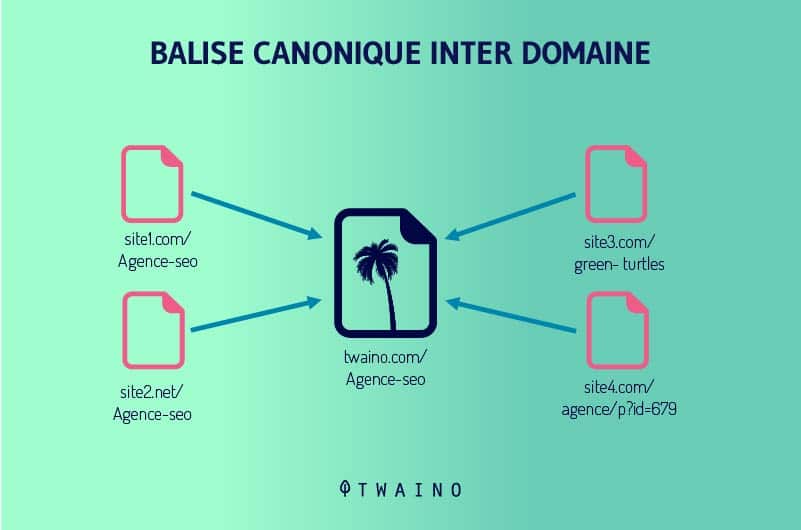

Por lo tanto, una URL bloqueada con Disallow puede aparecer en los resultados de búsqueda cuando Google encuentre contenido relevante para una consulta. También se puede clasificar cuando hay backlinks y etiquetas canónicas que apuntan a ello.

Sin embargo, Google sólo podrá mostrar información que no sea la URL de la página. Así, este último aparece en lugar del título. Para la meta descripción, el motor de búsqueda muestra un mensaje de que no está disponible debido a un archivo robots.txt.

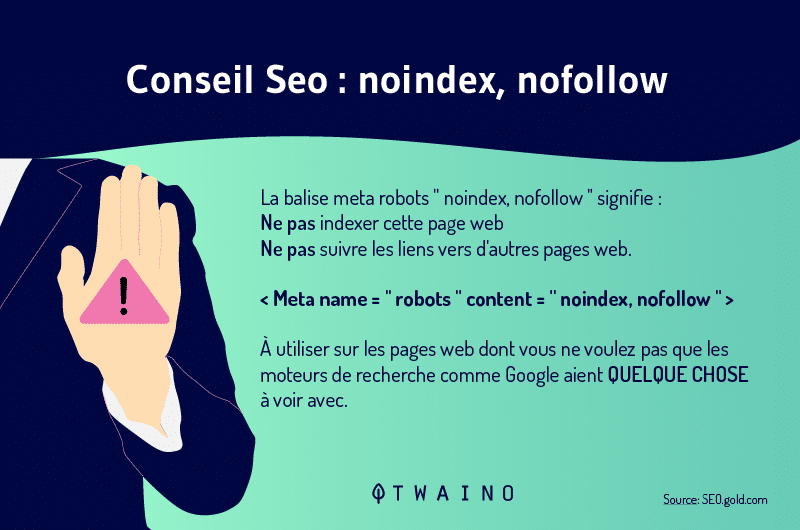

Para evitar que los motores de búsqueda de indexar una página webse utiliza la etiqueta Noindex. Les dice que no consideren el recurso en cuestión en las SERP.

También hay que recordar que las directivas Disallow y Noindex pueden combinarse. La etiqueta Noindex le permitirá poner algunas de sus páginas fuera del índice y evitar problemas como contenido duplicado.

Tenga en cuenta que esta etiqueta es diferente de Nofollow, una etiqueta que se utiliza cuando se quiere indicar a Google que indexe la página, pero que no siga los enlaces de esa página.

El Noindex y el Nofollow pueden combinarse cuando se desea que la página en cuestión no sea indexada y que sus enlaces no sean seguidos.

Capítulo 2: Formas de aplicación de Disallow y mejores prácticas para evitar errores

La aplicación de la directiva Disallow es especialmente sencilla, ya que sólo requiere un dominio de la sintaxis y de los caracteres generales. Este capítulo analiza las formas de aplicación de la directiva Disallow y las buenas prácticas para evitar errores.

2.1. Uso de agentes-usuarios para especificar los motores de búsqueda

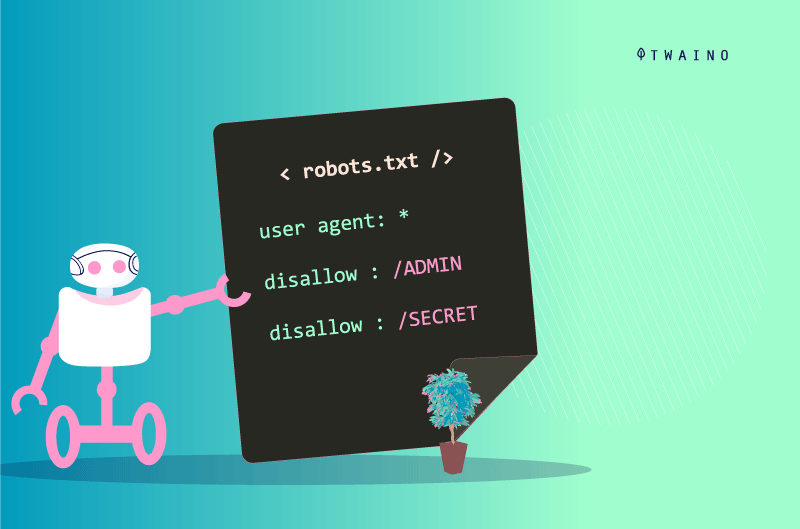

Para aplicar la directiva Disallow y las directivas robots.txt, primero debe establecer los usuarios-agentes a los que va dirigido el mensaje. Estos son los robots que considerarán las instrucciones de la directiva.

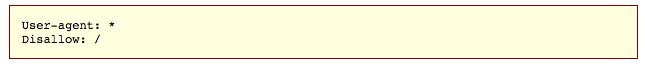

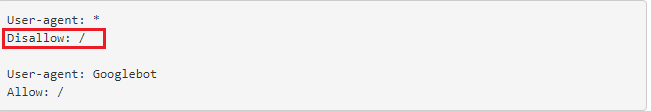

Para indicar que están destinados a todos los bots, se utiliza el símbolo (*), como se indica a continuación.

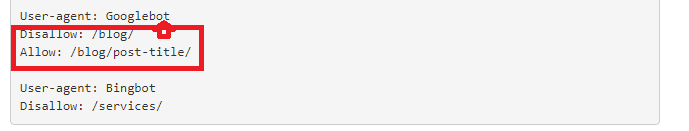

Pero cuando nos dirigimos exclusivamente a los Googlebots, procedemos de la siguiente manera:

- user-agent: Googlebots

Cuando nos dirigimos sólo a los Bingbots, escribimos :

- user-agent : Bingbots

El registro de un agente de usuario también marca el inicio de las instrucciones para un conjunto de directivas. Así, todas las directivas entre un primer agente de usuario y un segundo agente de usuario se tratan como las directivas del primer agente.

Además, el asterisco (*) representa el conjunto de caracteres posibles, mientras que el signo de dólar ($) representa la forma en que se terminan las URL. El signo de libra (#) se utiliza para iniciar un comentario.

Los comentarios son sólo para humanos y no son compatibles con los robots. Estos tres símbolos se denominan comodines, y un mal manejo de los mismos puede causar problemas a su sitio.

2.2. Las diferentes formas de aplicación de Disallow

La sintaxis de Disallow difiere según la forma de aplicación.

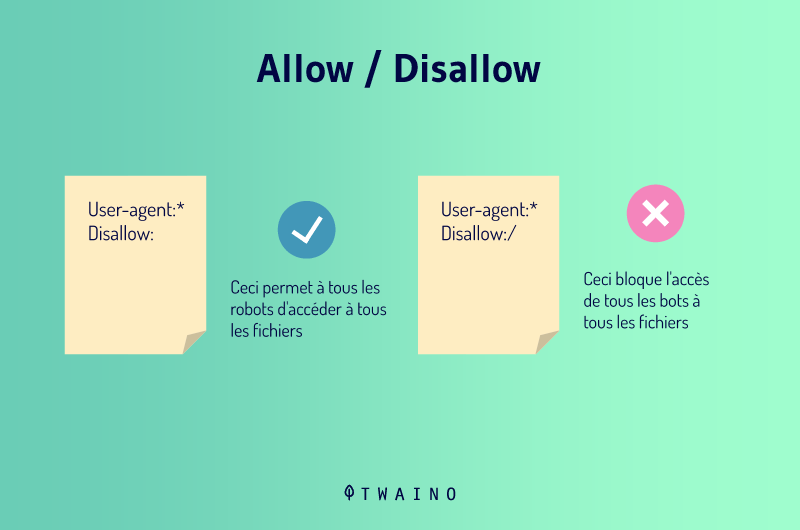

2.2.1. Desautorizar:

Cuando pone Disallow: sin añadir nada después, está diciendo a los rastreadores que no hay restricciones. Esto significa que todo en su página es bueno para aprender y los bots pueden explorar todo.

Usted entiende que esta sintaxis no es útil ya que los motores de búsqueda rastrearán su sitio de todos modos en su ausencia.

2.2.2. Disallow:/

Esta directiva se lee Disallow all y le permite desautorizar un sitio entero. Si utiliza esta sintaxis, los robots de los agentes de usuario definidos no podrán rastrear nada en su sitio. Esta sintaxis puede utilizarse cuando un sitio está todavía en mantenimiento, por ejemplo.

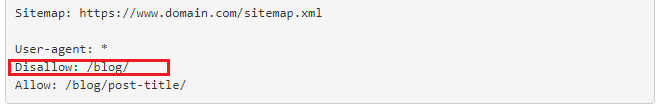

2.2.3. Disallow: blog

Este código le permite bloquear el acceso a todas las páginas cuya URL empiece por blog. Por lo tanto, todas las direcciones que empiecen por https://www.votresite.com/blog serán simplemente ignoradas durante la exploración.

2.2.4. Disallow:/*.pdf

Es posible no permitir el rastreo de un tipo de archivo concreto y este código hace precisamente eso con los archivos PDF. Esto permitirá a los rastreadores ignorar los archivos de este tipo cuando rastreen las siguientes URLs:

- https://www.votresite.com/contrat.pdf

- https://www.votresite.com/blog/documents.pdf

También es posible añadir el símbolo ($) a nuestra sintaxis para indicar a los bots que todas las páginas con URLs terminadas en (.pdf) deben ser ignoradas.

2.3. Desautorizar VS Permitir

Las directivas Disallow y Allow pueden utilizarse conjuntamente en un archivo robots.txt. Cuando se utilizan conjuntamente, el uso de comodines podría dar lugar a instrucciones conflictivas.

Además, los robots de Google suelen ejecutar la directiva menos restrictiva cuando las instrucciones no son claras. Pero cuando las directivas Disallow y Allow coinciden con la misma URL en un archivo robots.txt, gana la instrucción más larga.

La longitud de la declaración es el número de caracteres de la declaración fuera de la directiva. Esta es la ruta de la directiva que seguirán los bots. En los ejemplos siguientes, se ejecutará la segunda instrucción.

- Disallow /ejemplo* (9 caracteres)

- Permitir /ejemplo.htm $ (13 caracteres)

- Permitir /*pdf$(6 caracteres)

2.4. Mejores prácticas para evitar errores

Una configuración incorrecta del archivo robots.txt o una instrucción errónea de la directiva Disallow pueden ralentizar el rendimiento SEO de su sitio. Por eso es importante tener cuidado de no bloquear sus recursos por error.

Por otro lado, no debe bloquear los datos sensibles sólo con la directiva Disallow. Como se ha mencionado anteriormente, una página bloqueada puede seguir apareciendo en los resultados de búsqueda y hacerse pública.

Además, los bots maliciosos que no siguen las directrices de robots.txt pueden rastrear páginas que se supone que están protegidas con Disallow. Dado que el archivo robots.txt es público, cualquiera puede mirarlo y descubrir lo que está tratando de ocultar.

En cuanto a los usuarios-agentes, hay que saber utilizarlos para ser precisos en el registro de las instrucciones de las distintas directivas. Tenga en cuenta que un motor de búsqueda puede tener varios bots cuando defina los agentes.

Por ejemplo, Google utiliza Googlebot para la búsqueda orgánica, pero Googlebot-Image para la búsqueda de imágenes.

Capítulo 3: Otras preguntas sobre la directiva Disallow

En este capítulo se examinan las preguntas que se plantean regularmente en relación con la directiva Disallow.

3.1) ¿Qué es un robots.txt?

Un archivo robots.txt da instrucciones a los motores de búsqueda sobre sus preferencias de rastreo. Este archivo es sensible en el mundo de la SEO y un pequeño error puede comprometer todo un sitio.

Pero cuando se utiliza de forma inteligente, envía buenas señales a Google y ayuda a que su sitio se clasifique bien. Para editar un archivo robots.txt, sólo tiene que conectarse a su servidor a través de un cliente FTP y realizar los cambios.

Si no puede realizar la conexión, puede ponerse en contacto con su proveedor de Internet. Sin embargo, si necesita crear un nuevo archivo robots.txt, puede hacerlo desde un editor de texto plano.

En este caso, asegúrese de eliminar el antiguo si ya tiene uno en su sitio. Tenga cuidado de no utilizar un editor de texto como Word, ya que puede introducir otro código en su texto.

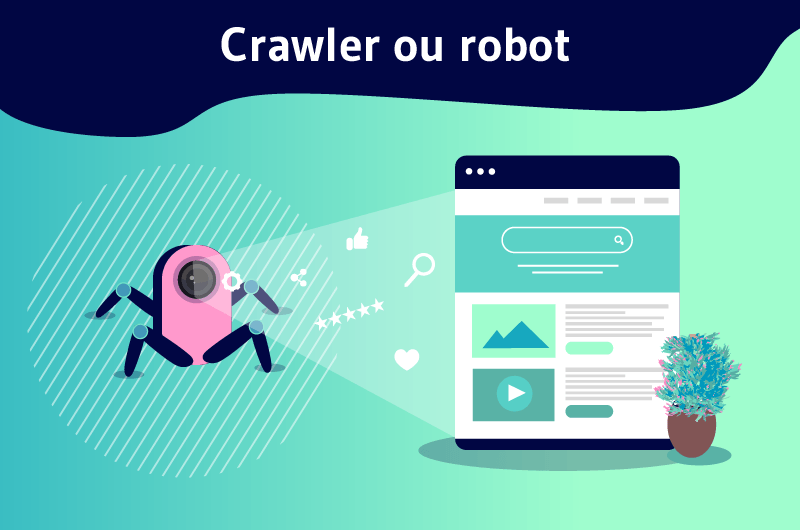

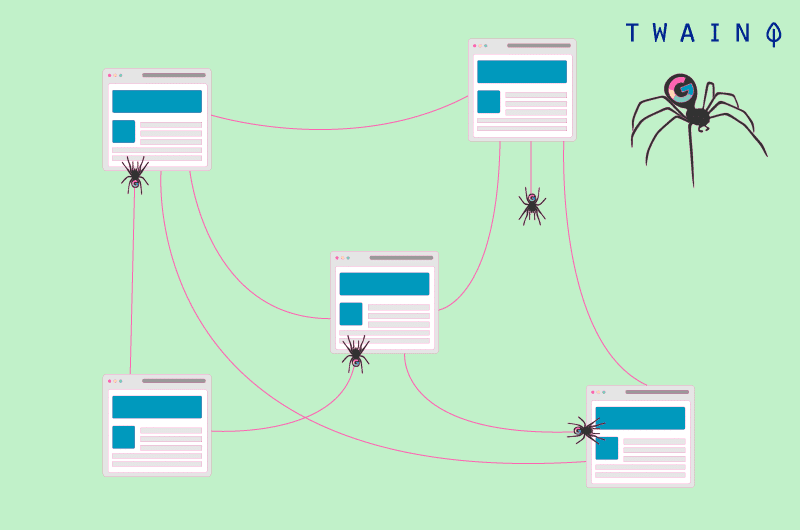

3.2) ¿Qué es el gateo?

También conocido como crawling, el rastreo de páginas web es un proceso por el que los motores de búsqueda envían robots (arañas) para examinar el contenido de cada URL.

Estas arañas se mueven de página en página para encontrar nuevas URLs o contenidos. Es este primer paso el que permite a los motores de búsqueda descubrir su contenido y programarlo para su indexación.

El archivo del robot entra en juego en esta etapa y guía a los robots según sus preferencias. El rastreo es distinto de la indexación, ya que esta última consiste en almacenar y organizar el contenido encontrado durante el rastreo.

3.3. ¿Qué páginas se pueden bloquear con la directiva Disallow?

Los motores de búsqueda no tienen una regla universal sobre qué páginas bloquear. El uso de la directiva Disallow es, por tanto, específico del sitio y depende del criterio del webmaster.

Sin embargo, esta directiva puede ayudar a indicar a las arañas que no rastreen las páginas bajo prueba. También puede utilizarse para impedir el acceso a determinadas páginas, como las de agradecimiento.

Cuando esté trabajando en un sitio multilingüe, por ejemplo, puede bloquear la versión en inglés si no está lista y evitar que las arañas la exploren.

En cuanto a la página de agradecimiento, generalmente está destinada a los nuevos prospectos. Estas páginas pueden seguir gastando presupuestos de rastreo y aparecer en los resultados de búsqueda.

Cuando aparece en los resultados de búsqueda, la página de agradecimiento está disponible para cualquiera y pueden acceder a ella sin pasar por el proceso de captación de clientes potenciales.

Pero al bloquear la página de agradecimiento, se asegura de que los clientes potenciales cualificados puedan acceder a ella. En este caso, la directiva Disallow por sí sola no será suficiente ya que no impide que la URL en cuestión sea indexada.

Dicho esto, la página en cuestión puede seguir apareciendo en las SERP. Por lo tanto, es aconsejable combinar la directiva Disallow con la directiva Noindex. Esto evitará que los rastreadores visiten e indexen la página.

Conclusión

En definitiva, son muchas las acciones que se pueden llevar a cabo para mejorar el ranking de un sitio. La directiva Disallow es una de estas acciones que le dan una verdadera ventaja en términos de referenciación.

Permite prohibir a las arañas de los motores de búsqueda que rastreen contenidos que no son útiles para optimizar el presupuesto de rastreo de un sitio web.

De este modo, permite a las arañas utilizar ese presupuesto de la mejor manera posible para aumentar la visibilidad de su contenido en los resultados de búsqueda.

Por lo tanto, el uso de la directiva Disallow puede tener un impacto significativo cuando las instrucciones se dan correctamente. Sin embargo, puede romper todo un sitio cuando las instrucciones son incorrectas.