Google a récemment annoncé aux webmasters et aux professionnels du référencement la suppression de l’outil de limitation du taux de crawl dans Google Search Console. Ce changement devrait entrer en vigueur le 8 janvier 2024.

Cet outil, qui fait depuis longtemps partie intégrante de la suite Search Console, est utilisé depuis plus d’une décennie pour contrôler la fréquence des demandes de données de Googlebot provenant de sites Web. Dans cet article, nous verrons les raisons de cette décision de Google, ces implications et ce qu’elle signifie pour l’avenir de l’indexation des sites Web et du SEO..

Le limiteur de vitesse d’exploration : c’est quoi ?

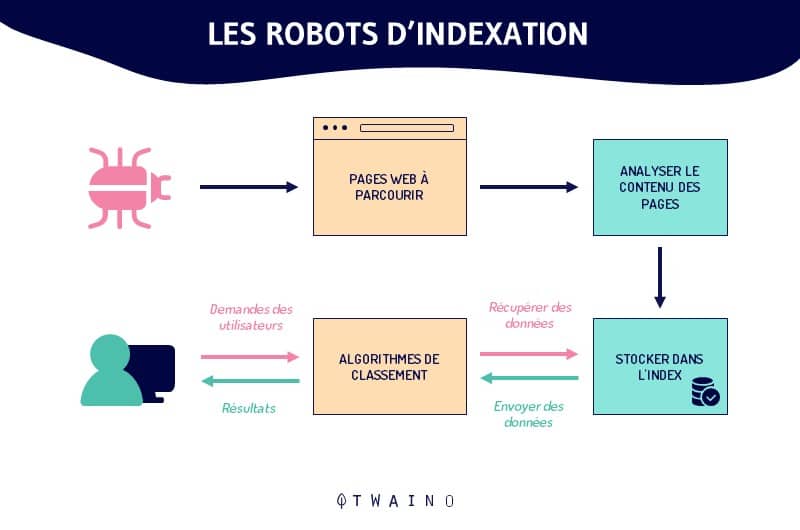

L’outil de taux d’exploration était une fonctionnalité clé de la Search Console. Il permettait aux propriétaires de sites web de contrôler à quel rythme Googlebot parcourait leur site. C’était précieux pour le SEO, car une exploration efficace signifie une meilleure indexation et donc une meilleure visibilité.

Cependant, Google a traditionnellement découragé de restreindre la vitesse d’exploration, sauf en cas de problèmes de charge du serveur directement attribuables à une activité intensive de Googlebot sur votre serveur.

Avant que l’outil ne soit supprimé, vous pouvez y accéder ici.

Voici ce à quoi il ressemble avant le déploiement de la mise à jour :

Il est maintenant tant de comprendre les diverses raisons qui ont poussé Google à supprimer cet outil.

Les causes de l’obsolescence du dispositif de régulation de la vitesse de crawl

Gary Illyes de Google a affirmé : « avec les améliorations que nous avons apportées à notre logique d’exploration et aux autres outils disponibles pour les éditeurs, l’outil de limitation de la vitesse d’exploration dans la Search Console est devenu moins utile ».

Gary Illyes complète : « Googlebot réagit à la façon dont le site – ou plus précisément le serveur qui gère le site – répond à ses requêtes HTTP. Par exemple, si le serveur renvoie de manière persistante 500 des codes d’état HTTP pour une plage d’URL, Googlebot ralentira automatiquement et presque immédiatement l’exploration. De même, Googlebot ralentira automatiquement si le temps de réponse aux requêtes s’allonge considérablement. Si vous rencontrez une exploration inhabituellement lourde que votre site ne peut pas gérer seul, reportez-vous à cet article d’aide ».

Illyes s’exprime en expliquant que l’outil de limitation de débit de Google Search Console « avait un effet beaucoup plus lent ». Il a dit que l’outil « aurait souvent pris plus d’une journée pour que les nouvelles limites soient appliquées à l’exploration ».

Il a ajouté que l’outil était « rarement » employé par les propriétaires de sites et que ceux qui l’utilisaient « dans de nombreux cas, réduisaient la vitesse d’exploration au strict minimum ».

Impact de la suppression de l’outil sur les pratiques SEO et les Webmasters

La suppression de l’outil de limitation du taux d’exploration de Google Search Console représente une grande révolution dans la manière dont les webmasters interagissent avec le processus d’indexation de Google. Cette modification soulève des questions importantes et ouvre de nouvelles opportunités pour les professionnels du SEO.

Sans l’outil de limitation, Google adoptera une approche plus automatisée pour déterminer le taux d’exploration des sites. Cela implique que l’algorithme de Google évaluera de façon autonome la fréquence idéale de visite des pages en fonction de divers facteurs comme la réponse du serveur et la fréquence de mise à jour du contenu.

Pour cela, les webmasters devront s’assurer que leurs serveurs sont optimisés pour gérer efficacement les visites de Googlebot, sans la possibilité de contrôler manuellement cette fréquence.

La principale préoccupation pour les webmasters sera de gérer la charge serveur. Sans contrôle manuel, des pics de trafic du robot d’indexation pourraient ralentir un site, surtout si le serveur n’est pas suffisamment robuste.

Il est donc nécessaire d’optimiser les performances du serveur pour garantir une exploration et une indexation fluides sans impacter négativement l’expérience utilisateur.

D’un autre côté, cette évolution peut conduire à une indexation plus efficace des sites. Avec des technologies de crawling améliorées, Google peut mieux comprendre quand et comment explorer les sites, ce qui peut mener à une meilleure visibilité dans les résultats de recherche.

Les professionnels du SEO devront s’adapter à ces changements. Ils devront se concentrer davantage sur des aspects techniques tels que :

- l’optimisation de la vitesse de site ;

- la structuration du contenu ;

- et l’adoption de bonnes pratiques pour une exploration efficace.

Il sera également important de surveiller étroitement les rapports de Google Search Console pour identifier et résoudre les problèmes d’indexation qui pourraient survenir.

En résumé

Pour conclure, la suppression de l’outil de contrôle du rythme de Googlebot a fait plus de bien que de mal. Cela montre que le référencement change tout le temps, et il faut s’adapter.

Les responsables de sites doivent rester attentifs aux changements, essayer de nouvelles idées et garder leurs sites bien optimisés pour être bien placés dans les résultats de recherche de Google.