Il Budget crawl è definito come il limite di pagine che Google si è prefissato di strisciare su un sito web per la sua referenziazione. Durante il crawling, il motore di ricerca cerca di controllare i suoi tentativi per non sovraccaricare il server del sito, ma allo stesso tempo fa attenzione a non ignorare le pagine importanti. Per trovare il giusto equilibrio, Google assegnerà quindi un diverso Budget crawl a ciascun sito web in base ad alcuni criteri, come ad esempio: La reattività del server, le dimensioni del sito, la qualità dei contenuti e la frequenza degli aggiornamenti

Il Web si sta espandendo, il SEO si sta anche espandendo. Solo nel 2019, più di 4,4 milioni di post sul blog sono stati pubblicati in rete ogni giorno.

Mentre gli utenti di Internet si godono questi contenuti, i motori di ricerca si trovano di fronte a una sfida importante: come organizzare le risorse per scansionare solo le pagine pertinenti e ignorare i link di spam o di scarsa qualità

Da qui la nozione di budget strisciante

- Che cos’è in termini concreti?

- Quanto è importante per un sito web?

- Quali sono i fattori che la influenzano?

- Come può essere ottimizzato per un sito web?

- E come può essere monitorato?

Sono tutte domande alle quali daremo risposte chiare e concise nel corso di questa mini-guida

Cominciamo!

Capitolo 1: Budget crawl – Definizioni e importanza SEO

Per sviluppare questo capitolo, esamineremo la definizione di budget crawl da due angolazioni

- Una definizione vista dalla parte degli esperti SEO

- E cosa intende Google con questo termine

1.1 Qual è il budget per le strisciate?

Il crawl budget (o exploration o indexation budget) non è un termine ufficiale fornito da Google

Piuttosto, proviene dal settore SEO, dove viene utilizzato dagli esperti SEO come termine generico per le risorse allocate da Google per effettuare il crawling di un sito e indicizzare le sue pagine

In termini semplici, il crawl budget di un sito web si riferisce al numero di pagine che Google prevede di scansionare sul sito in un determinato lasso di tempo

Si tratta di un numero predeterminato di URL che il motore di ricerca ordina ai suoi robot di indicizzazionegoogleBot, da considerare quando visita il sito

Non appena il limite del crawl budget viene raggiunto, GoogleBot smette di effettuare il crawling del sito, il resto delle pagine non indicizzate viene automaticamente ignorato e il robot lascia il sito

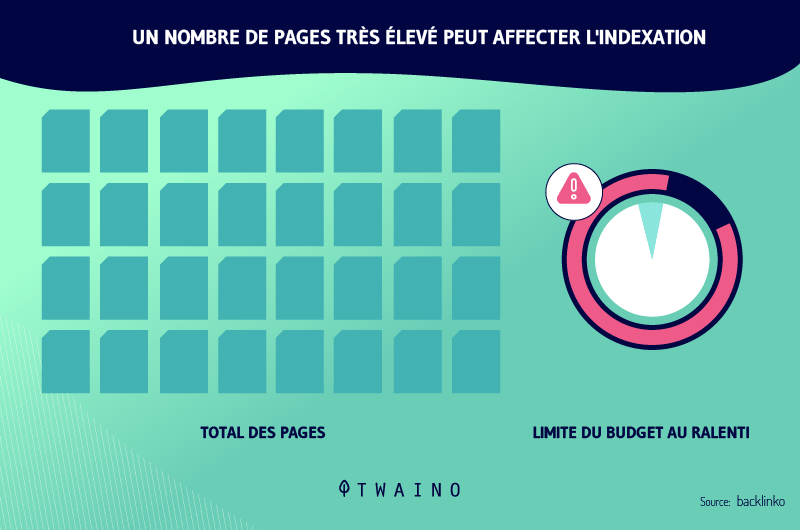

Questo numero di pagine da indicizzare può variare da un sito all’altro, perché non tutti i siti hanno le stesse prestazioni o la stessa autorità. Un budget di crawl fisso per tutti i siti web potrebbe essere troppo alto per un sito e troppo basso per un altro

Il motore di ricerca ha quindi deciso di utilizzare un certo numero di criteri prima di fissare il tempo che il suo robot di indicizzazione su ogni sito e il numero di pagine da crawlare

Per quanto riguarda questi criteri, non c’è un elenco esaustivo, come per molte altre cose legate al mondo del lavoroalgoritmo algoritmo

Tuttavia, ecco alcuni di questi criteri noti a tutti

- Prestazioni del sito un sito web ben ottimizzato con una velocità di caricamento rapida otterrà probabilmente un budget di crawl più elevato rispetto a uno che è lento da caricare

- Dimensione del sito più contenuti contiene un sito, più alto è il budget

- Frequenza degli aggiornamenti un sito che pubblica un numero sufficiente di contenuti di qualità e aggiorna regolarmente le sue pagine otterrà un budget di crawl considerevole.

- Collegamenti sul sito più link ha un sito, più alto sarà il suo crawl budget e migliori saranno le sue pagine indicizzato.

Idealmente, il budget di crawl dovrebbe coprire tutte le pagine di un sito, ma purtroppo non è sempre così. Ecco perché è importante ottimizzare i criteri di cui sopra per massimizzare le possibilità di ottenere un budget per le strisciate di grandi dimensioni

Va detto che finora la definizione di questo termine è stata affrontata dal punto di vista del proprietario di un sito o di un esperto di web SEO che si occupa della SEO di un sito web

Ma quando la domanda “che cos’è il budget crawl” è stata rivolta a Gary Illyes, analista di Google, la sua risposta è stata molto più sfumata

1.2 Che cosa intende Google per budget crawl?

Nel 2017, Gary Illyes ha affrontato la questione spiegando come Google intende il crawl del budget Nella sua rispostanella sua risposta, possiamo distinguere 3 parti principali e importanti

- Il concetto di frequenza di strisciamento

- La domanda di strisciamento

- E altri fattori

1.2.1. Il tasso di strisciamento

Quando effettua il crawling, Google ha paura di sovraccaricare ogni sito strisciato e far esplodere il suo server. Questo non sorprende, poiché sappiamo che il motore di ricerca è sempre stato protettivo e sostiene una buona esperienza utente sui siti web

Le parole di Gary Illyes lo conferma ancora una volta

“Googlebot è stato progettato per essere un buon cittadino del web. Il crawling è la sua priorità principale, pur assicurando che non degradi l’esperienza degli utenti che visitano il sito. Noi lo chiamiamo ‘crawl rate limit’, che limita la velocità massima di recupero per un determinato sito

Quindi, se GoogleBot vede dei segnali su un sito che il suo frequente crawling potrebbe influire sulle prestazioni del sito, allora il robot di indicizzazione rallenta il suo tempo di strisciamento e la sua frequenza di visita

Di conseguenza, in alcuni casi, alcune pagine di un sito web potrebbero finire per non essere indicizzate da GoogleBot

Al contrario, se il robot di indicizzazione riceve segnali incoraggianti, come risposte rapide dal server, questo facilita il suo lavoro e GoogleBot può decidere di aumentare la durata e la frequenza delle sue visite

1.2.2. La richiesta di crawl

Per quanto riguarda la domanda di crawling, Gary Illyes spiega

“Anche se il limite di velocità di crawl non viene raggiunto, se non c’è richiesta di indicizzazione, l’attività di Googlebot sarà bassa”

Fonte: Tech Viaggio

Chiaramente, GoogleBot si basa sulla richiesta di crawl di un sito per decidere se vale la pena rivisitare il sito

Questa domanda è influenzata da due fattori

- Popolarità dell’URL quanto più popolare è una pagina, tanto più è probabile che venga scansionata dai crawler.

- URL obsoleti google cerca anche di non avere URL obsoleti nel suo indice. Quindi, più URL vecchi ha un sito, meno è probabile che le sue pagine vengano indicizzate da GoogleBot

L’intenzione di Google è quella di indicizzare i contenuti recenti o regolarmente aggiornati di siti popolari e di escludere i contenuti obsoleti. Questo è il suo modo di mantenere l’indice sempre aggiornato con contenuti recenti per i suoi utenti

Gli altri fattori includono tutto ciò che può migliorare la qualità del contenuto di un sito e la sua struttura. Questo è un aspetto importante su cui Gary Illyes ha voluto concentrarsi

In effetti, raccomanda ai webmaster di evitare alcune pratiche come

- Creare contenuti di scarsa qualità;

- L’implementazione di alcuni stili di navigazione sfaccettati;

- Il contenuti duplicati ;

- E così via

Torneremo su questi fattori in modo più dettagliato in un capitolo successivo. Gary Illyes afferma che utilizzando tali pratiche sul suo sito, in un certo senso sta sprecando il suo budget per il crawling

Nelle sue parole

“Lo spreco di risorse del server su pagine come queste, drena l’attività di crawling dalle pagine che sono effettivamente di valore, il che può ritardare in modo significativo la scoperta di contenuti di qualità su un sito”

Per capire meglio cosa intende Gary, supponiamo ad esempio che lei abbia un famoso negozio di e-commerce specializzato nella vendita di console e accessori per videogiochi

Lei decide di creare uno spazio sul sito in cui i suoi utenti possano condividere le loro esperienze con i suoi prodotti, una sorta di forum ampio e attivo. Cosa pensa che accadrà?

Ebbene, grazie a questo forum, milioni di URL di basso valore verranno aggiunti al suo profilo di link. Conseguenza: questi url consumeranno inutilmente una buona parte del budget di crawl che Google le ha assegnato. Di conseguenza, le pagine che sono davvero preziose per lei potrebbero non essere indicizzate.

Ora ha un’idea abbastanza chiara di quale sia il budget per il crawling, ma quanto è importante per un sito web?

Capitolo 2: L’importanza del budget di crawl per la SEO

Un budget di crawl ottimale è molto importante per i siti web, in quanto consente di indicizzare rapidamente le pagine importanti

Come ha sottolineato Gary Illyes, uno spreco del budget per il crawling impedirà a Google di analizzare il suo sito in modo efficace. Il crawler potrebbe dedicare più tempo a pagine poco importanti, a scapito di quelle per le quali vuole davvero posizionarsi

Questo ridurrà il suo potenziale di ranking, poiché ogni non indicizzato non sarà presente nei risultati di ricerca di Google. Quella pagina perderà quindi ogni probabilità di essere visualizzata dagli utenti da una SERP

Immagini di produrre contenuti interessanti con immagini fantastiche e altamente illustrative. Poi fa un ulteriore passo avanti, ottimizzando i tag Title, Alt, Hn e molti altri fattori, proprio come farebbe un SEO esperto

Ma se alla fine ignora l’ottimizzazione del crawl budget, temo che i bot di indicizzazione di Google non raggiungeranno questi contenuti di qualità e nemmeno gli utenti. Il che sarebbe un peccato, visti tutti gli sforzi SEO che sono stati fatti

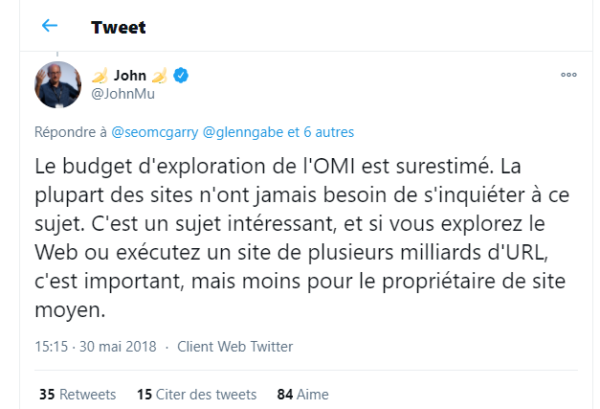

Tuttavia, va notato che l’ottimizzazione del crawl budget è particolarmente importante solo per i siti web di grandi dimensioni

John Mueller, un altro analista di Google in un tweet nei seguenti termini

“La maggior parte dei siti non deve mai preoccuparsi di questo. È un argomento interessante, e se sta effettuando il crawling del web o sta gestendo un sito multimiliardario di URL, è importante, ma meno per il proprietario medio di un sito”

Come può vedere, il budget di crawl è destinato a siti web di grandi dimensioni con miliardi di URL, come ad esempio le famose piattaforme di shopping online

Questi siti possono davvero subire un calo del traffico se il loro budget di crawl non è ben ottimizzato. Per quanto riguarda gli altri siti, Google è meno allarmista e rassicura che non dovrebbero preoccuparsi troppo dei problemi di crawl rate

Se lei è un piccolo sito locale o ha appena creato il suo sito web, questa è una notizia che la fa sentire sollevata

Tuttavia, non sta perdendo nulla se vuole ottimizzare il suo budget per il crawling, soprattutto se ha intenzione di espandere il suo sito in futuro

Al contrario, molti degli stessi metodi utilizzati per ottimizzare i tassi di crawling sono utilizzati anche per ottimizzare il posizionamento di un sito sulle pagine di Google

In sostanza, quando un’azienda cerca di migliorare il crawl budget del suo sito, migliora anche la sua posizione su Google

Ecco un elenco di alcuni dei vantaggi SEO che un sito web ottiene ottimizzando il suo budget di crawl, anche se non ha problemi in quest’area

- Fare in modo che GoogleBot effettui il crawling solo delle pagine importanti del sito

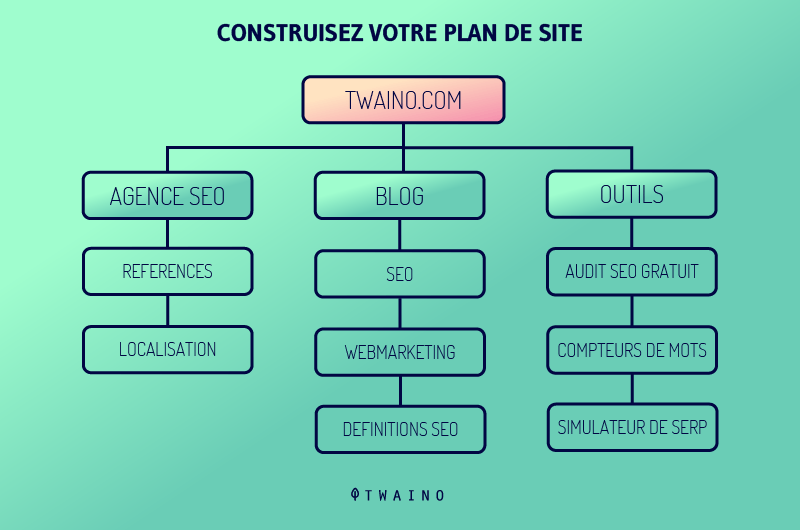

- Avere una sitemap ben strutturata

- Riduce gli errori e le lunghe catene di reindirizzamento

- Migliorare le prestazioni del sito

- Aggiornare il contenuto del sito

- E così via

Con tutti questi vantaggi, non c’è dubbio che il budget di crawl sia di grande importanza per un sito web

Ma per avere successo nella sua ottimizzazione, vorrei presentarle alcuni fattori negativi a cui dovrebbe prestare attenzione prima di iniziare

Capitolo 3: Fattori che influenzano il budget delle strisciate

Ecco alcuni fattori che possono influenzare negativamente il crawl budget di un sito

3.1. Navigazione sfaccettata

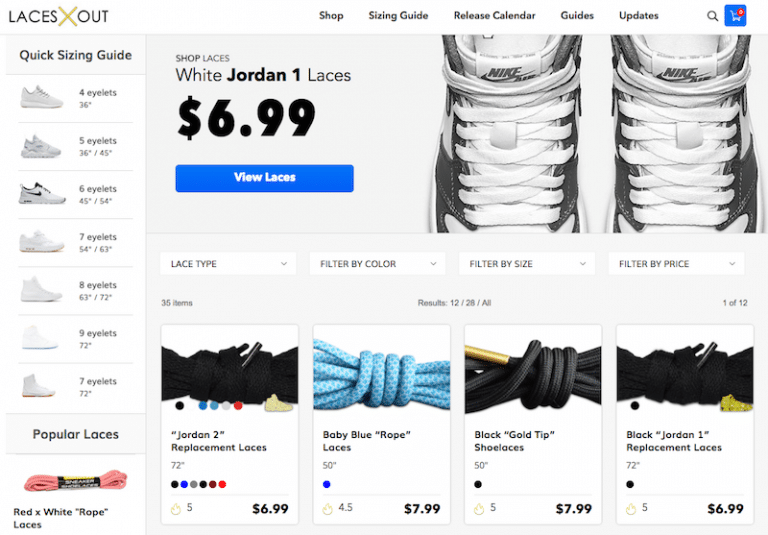

Si tratta di una forma di navigazione che si trova spesso nei negozi online. La navigazione sfaccettata consente all’utente di scegliere un prodotto e poi di avere altri filtri nella pagina per lo stesso prodotto

Potrebbe trattarsi di un prodotto disponibile in diversi colori o dimensioni. Il punto è che questo modo di organizzare i risultati richiede l’aggiunta di URL alla pagina

E ogni nuovo URL aggiunto visualizza solo uno snippet della pagina originale, non nuovi contenuti. Questo è uno spreco del budget per il crawl del sito

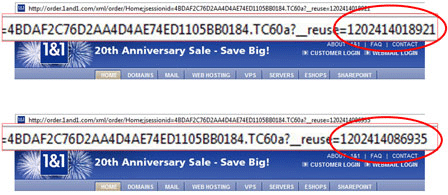

3.2. URL con identificatori di sessione

La tecnica di creare identificatori di sessione negli URL non dovrebbe più essere utilizzata, in quanto ogni volta che viene effettuata una nuova connessione, il sistema genera automaticamente un nuovo indirizzo URL. In questo modo si crea un’enorme quantità di URL in una pagina

Fonte Pole Position Marketing

3.3. Contenuti duplicati

Se in un sito ci sono molti contenuti identici, Googlebot può scansionare tutte le pagine interessate senza imbattersi in alcun nuovo contenuto

Le risorse utilizzate dal motore di ricerca per analizzare tutte queste pagine identiche potrebbero essere impiegate per effettuare il crawling di URL con contenuti rilevanti e diversi.

3.4. Pagine di errore del software

A differenza degli errori 404, questi errori puntano a una pagina funzionante, ma non a quella desiderata. Dato che il server non può accedere al contenuto effettivo della pagina, restituisce un codice di stato 200

3.5. Pagine dirottate

Google si assicura sempre di fornire i migliori risultati ai suoi utenti, il che ovviamente esclude le pagine hackerate. Pertanto, se il motore di ricerca individua tali pagine in un sito, l’indicizzazione viene interrotta per evitare che queste pagine finiscano nei risultati della ricerca.

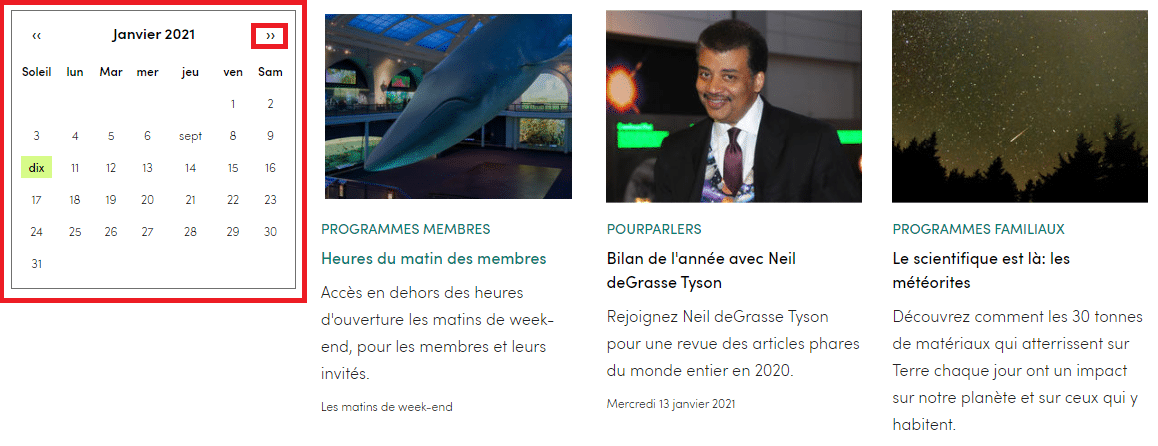

3.6. Spazi infiniti

Gli spazi che si possono trovare in un sito sono infiniti. Prendiamo il caso di un calendario in cui il pulsante “mese successivo” è programmato per saltare effettivamente al mese successivo

Durante il crawling, Googlebot potrebbe cadere in una sorta di loop infinito e prosciugare il budget di crawl del sito, cercando costantemente “il mese prossimo”

Ogni volta che un utente clicca sulla freccia a destra, viene creato un nuovo URL sul sito, con un numero astronomico di link su una pagina

3.7. Contenuti spam o di scarsa qualità

Google cerca di avere nel suo indice solo contenuti di qualità che forniscano un reale valore aggiunto agli utenti di Internet

Quindi, se il motore di ricerca rileva un contenuto di scarsa qualità su un sito, gli attribuisce un valore molto basso

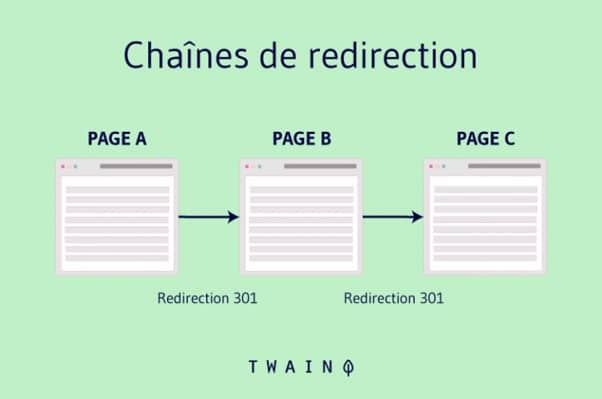

3.8. Catene di reindirizzamento

Quando, per un motivo o per l’altro, si creano catene di catene di reindirizzamentogooglebot deve passare attraverso tutti gli URL intermedi prima di raggiungere il contenuto effettivo.

Il robot non è ancora in grado di capire la differenza, quindi tratta ogni reindirizzamento come una pagina separata, il che prosciuga inutilmente il budget di crawl assegnato al sito.

3.9. Il cache buster

A volte i file come il file CSS possono essere rinominati in questo modo: style.css?8577484 Il problema di questo schema di denominazione è che il segno “?” viene generato automaticamente ogni volta che il file viene richiesto.

L’idea è di impedire ai browser degli utenti di memorizzare il file nella cache. Questa tecnica genera anche un’enorme quantità di URL che Google elaborerà individualmente. Questo influisce sul bilancio delle strisciate.

3.10. Reindirizzamenti mancanti

Per non perdere parte del suo pubblico, un sito può decidere di reindirizzare la sua versione non-www a una versione www esattamente come twaino.com a www.twaino.com o viceversa

Potrebbe anche voler migrare da protocollo HTTP a HTTPS. Tuttavia, se questi due tipi di reindirizzamenti generali non sono configurati correttamente, si noti che Google potrebbe effettuare il crawling di 2 o 4 URL per lo stesso sito:

http://www.monsite.com

https://www.monsite.com

http://monsite.com

https://monsite.com

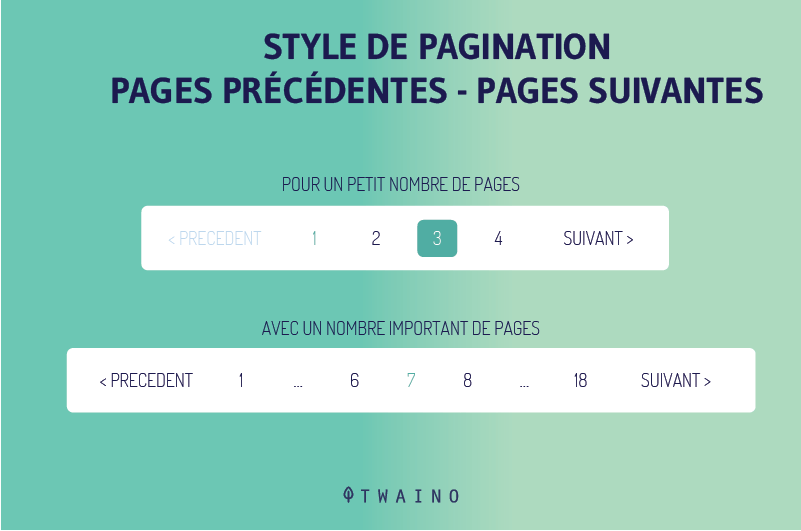

3.11. Paginazione sbagliata

Quando il paginazione sono solo pulsanti che consentono la navigazione in entrambe le direzioni, senza alcuna numerazione, Google ha bisogno di scansionare diverse pagine in quella direzione prima di capire che si tratta di una pagina di paginazione

Lo stile di paginazione consigliato e che non spreca il budget per il crawling è quello che menziona esplicitamente il numero di ogni pagina.

Con questo stile di paginazione, Googlebot può facilmente navigare dalla prima all’ultima pagina per avere un’idea di quali pagine sono importanti da indicizzare.

Se rileva uno o più dei fattori menzionati finora, è importante ottimizzare il budget di crawl per aiutare Googlebot a indicizzare le pagine più importanti per lei.

Ma come si ottimizza?

Capitolo 4: Come ottimizzare il budget di crawl?

Ora che le basi sono state stabilite, possiamo iniziare a ottimizzare il budget di crawl stesso

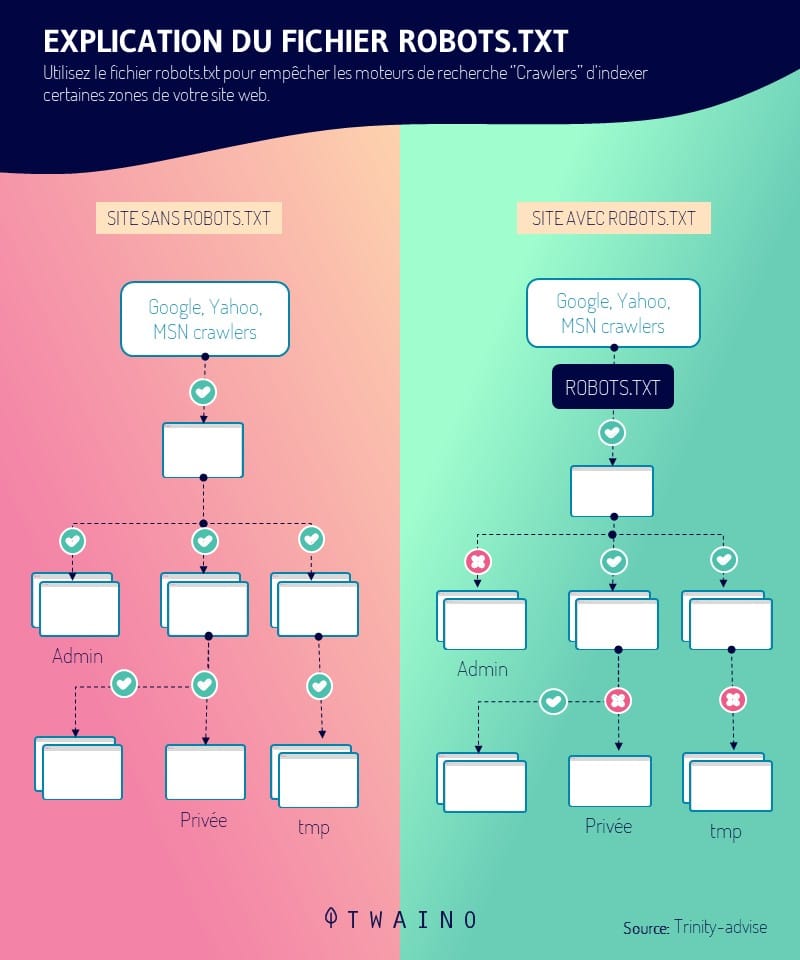

4.1. Consenta il crawling delle sue pagine importanti nel file Robots.Txt

Questa prima fase dell’ottimizzazione del crawl budget è probabilmente la più importante di tutte

Ci sono due modi per utilizzare il suo robots.txtdirettamente a mano o con l’aiuto di uno strumento di audit SEO

Se non è un appassionato di programmazione, l’opzione dello strumento è probabilmente la più semplice ed efficace

Prenda uno strumento di sua scelta, quindi aggiunga il file robots.txt. In pochi secondi, può decidere di consentire o meno il crawling di qualsiasi pagina del suo sito

Scopra come farlo in questo tutto su robots.txt

4.2. Eviti il più possibile le catene di reindirizzamento

Non può evitare di utilizzare i reindirizzamenti a catena per sempre, perché in alcune circostanze può essere un approccio utile. Tuttavia, idealmente dovrebbe avere un solo reindirizzamento su un sito web

Ma, bisogna ammetterlo, questo è quasi impossibile per i siti di grandi dimensioni. A un certo punto, sono costretti a usare 301 e 302 reindirizzamenti

Tuttavia, l’impostazione di reindirizzamenti in ogni punto del sito nuoce gravemente al budget di crawl e impedisce persino a Googlebot di effettuare il crawling delle pagine per le quali desidera essere inserito nell’elenco.

Si attenga a pochi reindirizzamenti, uno o due e preferibilmente a catene corte

4.3. Utilizzi il codice HTML il più possibile

Il crawler di Google è diventato molto più bravo a capire i contenuti in Javascriptma anche Flash e XML

Ma altri motori di ricerca non possono dire lo stesso. Quindi, per consentire a tutti i motori di ricerca di esplorare completamente le sue pagine, sarebbe più saggio utilizzare l’HTML, che è un linguaggio di base, accessibile a tutti i motori di ricerca

In questo modo, aumenterà le possibilità che le sue pagine vengano crawlate da tutti i motori di ricerca

4.4. corregga gli errori HTTP con il rischio di sprecare il suo budget per il crawling

Se non lo sapevi, il 404 errori e 410 gli errori si mangiano letteralmente il suo budget per le strisciate. Ancora peggio, degradano l’esperienza dell’utente

Immagina la delusione di un utente che si precipita a controllare un prodotto che vendi o un contenuto che hai scritto e finisce su una pagina vuota, senza alternative

Ecco perché è importante correggere gli errori HTTP per la salute del suo sito, ma anche per la soddisfazione dei suoi visitatori

Come per gli errori di reindirizzamento, sarebbe più pratico utilizzare uno strumento dedicato per individuare questi errori e risolverli, se non è molto appassionato di programmazione

Può utilizzare strumenti come Classifica SE, Ahrefs, Rana urlante. per eseguire un audit SEO audit del suo sito

4.5. Configuri correttamente i suoi URL

Se imposta URL diversi per accedere alla stessa pagina, Google non la capirà in questo modo. Per il motore di ricerca, ogni pagina è identificabile da uno e un solo URL

Pertanto, Googlebot indicizzerà ogni URL separatamente, indipendentemente dal fatto che ve ne siano diversi che reindirizzano allo stesso contenuto. Questo è uno spreco del budget di Crawl

Se si verifica una situazione del genere sul suo sito, deve informare Google

Si tratta di un’attività che presenta un doppio vantaggio: da un lato si risparmia il budget per il crawling e dall’altro non si deve più temere una penalizzazione da parte di Google per i contenuti duplicati

Scopra come gestire i suoi contenuti duplicati consultando questo articolo che mostra in dettaglio la procedura da seguire

4.6. Mantenga la sua sitemap aggiornata

È importante mantenere aggiornata la sua sitemap XML. Questo permette ai crawler di capire la struttura del suo sito, facilitando il crawling

Si raccomanda di utilizzare solo URL canonici per la sua sitemap

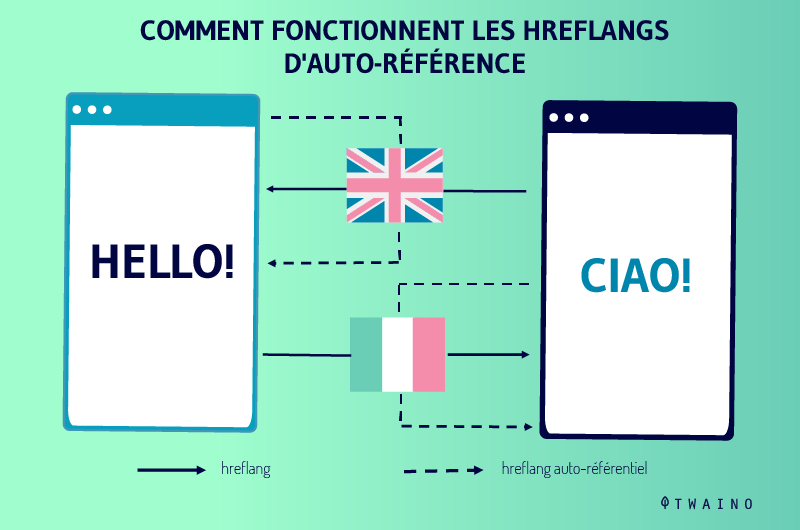

4.7. I tag Hreflang sono essenziali

Quando effettuano il crawling di una pagina locale, i crawler si basano sui tag hreflang. Ecco perché è importanteinformare Google delle diverse versioni che avete

Trova tutte le informazioni sul tag Hreflang in questa mini-guida.

Questi erano 7 consigli per ottimizzare il budget di crawl del suo sito, ma non finisce qui. È utile anche monitorare il modo in cui Googlebot effettua il crawling del suo sito e accede ai suoi contenuti

Capitolo 5: Come monitorare il suo budget per le strisciate

Per monitorare il budget di crawl del suo sito, ha a disposizione due strumenti Google Search Console e il file di registro del server

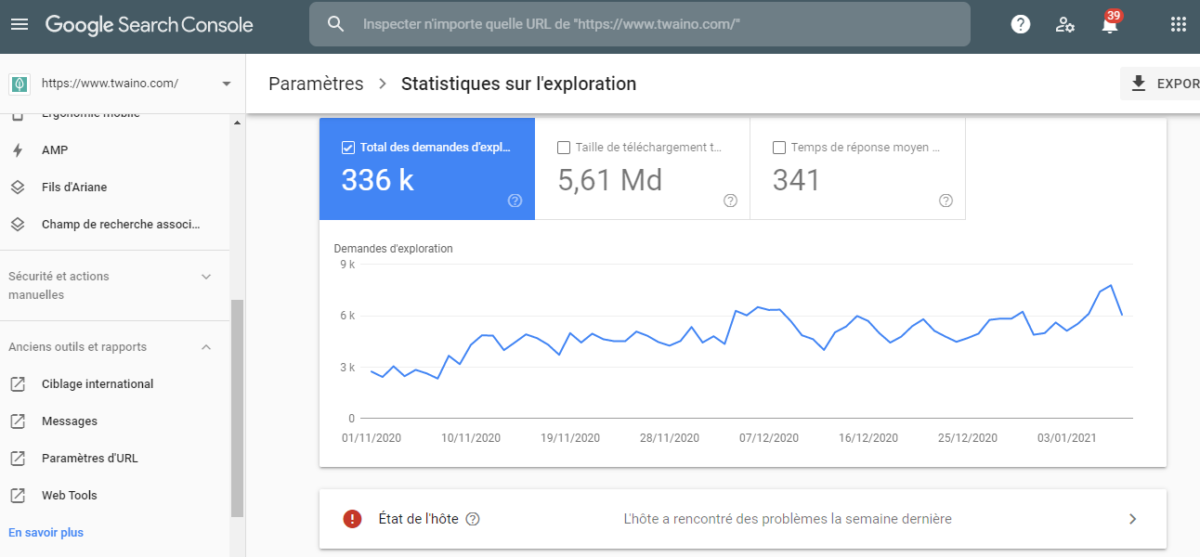

5.1. Google Search Console

GSC è uno strumento offerto da Google che offre diverse funzioni che le permettono di analizzare la sua posizione nell’indice e nelle SERP del motore di ricerca. Lo strumento offre anche una panoramica del suo budget per le strisciate

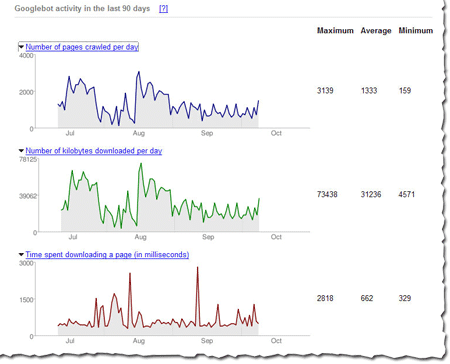

Per avviare l’audit, può accedere al rapporto ” Statistiche di crawl “. Questo è un rapporto che traccia l’attività di googlebot sul suo sito negli ultimi 30 giorni

In questo rapporto, possiamo vedere che Googlebot effettua il crawling di una media di 48 pagine al giorno sul suo sito. La formula per calcolare il budget medio di crawl per questo sito sarebbe

BC = Numero medio di pagine strisciate al giorno x 30 giorni

BC = 48 x 30

BC = 1440

Quindi, per questo sito, il budget medio di crawl è di 1440 pagine al mese

Tuttavia, è importante notare che questi dati di Google Search Console sono un po’ esagerati

Ma alla fine si tratta di una stima e non di un valore assoluto del budget per le strisciate. Queste cifre le danno solo un’idea della quantità di crawling che il sito sta ricevendo

Per completezza, può prendere nota di questa stima prima di iniziare a ottimizzare il suo budget per le strisciate. Una volta completato il processo, potrà rivedere il valore di questo crawl budget

Confrontando i due valori, può valutare meglio il successo delle sue strategie di ottimizzazione

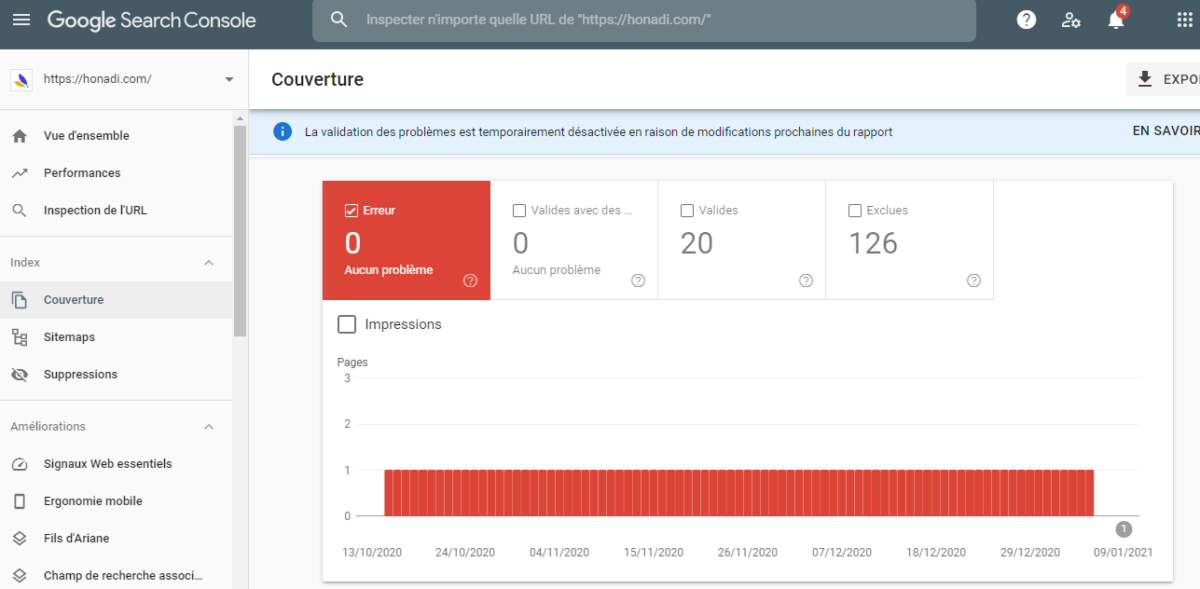

Google Search offre anche un altro report, un “report di copertura” per vedere quante pagine sono state indicizzato sul sito, oltre a quelle che sono state deindicizzato.

Può confrontare il numero di pagine indicizzate con il numero totale di pagine del suo sito per vedere quante pagine Googlebot sta effettivamente ignorando.

5.2. Il file di log del server

Il file di log del server è senza dubbio una delle fonti più affidabili per verificare il budget di crawling di un sito web

Semplicemente perché questo fascicolo traccia fedelmente la storia delle attività della robot di indicizzazione che effettuano il crawling di un sito. In questo file di log, ha anche accesso alle pagine che vengono regolarmente crawlate e alle loro dimensioni esatte

Ecco una panoramica dei contenuti di un file di registro

11.222.333.44 – – [11 / Marzo / 2020: 11: 01: 28 -0600] “GET https://www.seoclarity.net/blog/keyword-research HTTP / 1.1” 200 182 “-” “Mozilla / 5.0 Chrome / 60.0.3112.113 “

Per interpretare questo pezzo di codice, diremmo che l’11 marzo 2020, un utente ha cercato di accedere alla pagina https://www.seoclarity.net/blog/keyword-research dal browser Google Chrome

Il codice “200” è impostato per indicare che il server ha avuto accesso al file e che il file ha una dimensione di 182 byte

Capitolo 6: Altre domande sul Budget Crawl

6.1. Qual è il budget per le strisciate?

Il budget di crawl è il numero di URL di un sito web che un motore di ricerca può crawlare in un determinato periodo di tempo, in base alla velocità di crawl e alla domanda di crawl.

6.2. Cosa sono la velocità di strisciamento e il limite di velocità di strisciamento?

Il velocità di strisciamento è definito come il numero di URL al secondo che un motore di ricerca può scansionare su un sito. Il limite di velocità può essere definito come il numero massimo di URL che possono essere carrellati senza disturbare l’esperienza dei visitatori di un sito.

6.3. Che cos’è la domanda di gattonaggio?

Oltre ai limiti di velocità di crawl e di crawl specificati dal webmaster, la velocità di crawl varia da una pagina all’altra, a seconda della richiesta di una pagina specifica.

È probabile che le pagine più popolari vengano crawlate più spesso rispetto alle pagine visitate di rado, a quelle non aggiornate o a quelle di scarso valore

6.4. Perché il budget per le strisciate è limitato?

Il budget di crawl è limitato per garantire che il server di un sito web non sia sovraccaricato da un numero eccessivo di connessioni simultanee o da un’elevata richiesta di risorse del server, che potrebbero avere un impatto negativo sull’esperienza dei visitatori del sito.

6.5. Con quale frequenza Google effettua il crawling di un sito?

La popolarità, la crawlabilità e la struttura di un sito web determinano il tempo necessario a Google per effettuare la scansione di un sito. In generale, Googlebot può impiegare più di due settimane per effettuare il crawling di un sito. Tuttavia, si tratta di una proiezione e alcuni utenti hanno affermato di essere stati indicizzati in meno di un giorno.

6.6. Come posso impostare un budget per le strisciate?

- Consenta il crawling delle sue pagine importanti per i robot;

- Attenzione alle stringhe di reindirizzamento;

- Utilizzi l’HTML quando possibile;

- Non lasci che gli errori HTTP consumino il suo budget per il crawling;

- Si occupi dei parametri dell’URL;

- Aggiornare la sua mappa del sito;

- I tag Hreflang sono fondamentali;

- Ecc.

6.7. Qual è la differenza tra crawling e indicizzazione?

Il crawling e l’indicizzazione sono due cose separate e questo viene spesso frainteso nel settore SEO. Crawling significa che Googlebot esamina tutti i contenuti o il codice della pagina e li analizza

L’indicizzazione, invece, significa che Google ha creato una copia del contenuto nel suo indice e la pagina può apparire nelle SERP di Google.

6.8. Noindex salva il budget di crawling?

Il meta tag Noindex non risparmia il budget di crawl di Google. Si tratta di una domanda SEO abbastanza ovvia per la maggior parte di voi, ma John Mueller di Google ha confermato che l’utilizzo del meta tag noindex sul suo sito non la aiuterà a salvare il suo budget di crawl. Questo meta tag impedisce solo l’indicizzazione della pagina, non il crawling.

Conclusione

In breve, il crawl budget è la risorsa che Google riserva a ciascun sito per il crawling e l’indicizzazione delle sue pagine

Anche se il crawl budget non è di per sé un fattore di referenziazione, la sua ottimizzazione può contribuire alla referenziazione delle pagine del sito, in particolare di quelle più importanti

A tal fine, abbiamo presentato una serie di pratiche da tenere in considerazione in questa guida

Spero che questo articolo l’abbia aiutata a comprendere meglio il concetto di budget crawl e soprattutto come ottimizzarlo

Se ha altre domande, me lo faccia sapere nei commenti.

Grazie e a presto!