Si vous êtes promoteur d’un site ou d’une page web, sachez tout simplement qu’il est indispensable pour vous de disposer du fichier robots.txt.

Beaucoup peuvent se demander déjà de quoi je veux parler notamment lorsqu’ils n’ont pas de notions en SEO ou en développement web.

Retenez qu’il s’agit d’un fichier texte très important. Il intervient dans la gestion des demandes d’explorations de votre site par les robots d’explorations Google.

Le présent mini guide vous permettra d’avoir une connaissance plus approfondie de ce qu’on entend par robots.txt.

Vous y trouverez également le processus de création et de mise en place, mais aussi les bonnes pratiques de sa prise en main.

Chapitre 1 : C’est quoi un fichier robots.txt et quelle est son utilité ?

Dans ce premier chapitre, vous saurez la réelle signification des robots.txt de même que leur utilité.

1.1. C’est quoi un robot.txt et comment se présente-t-il ?

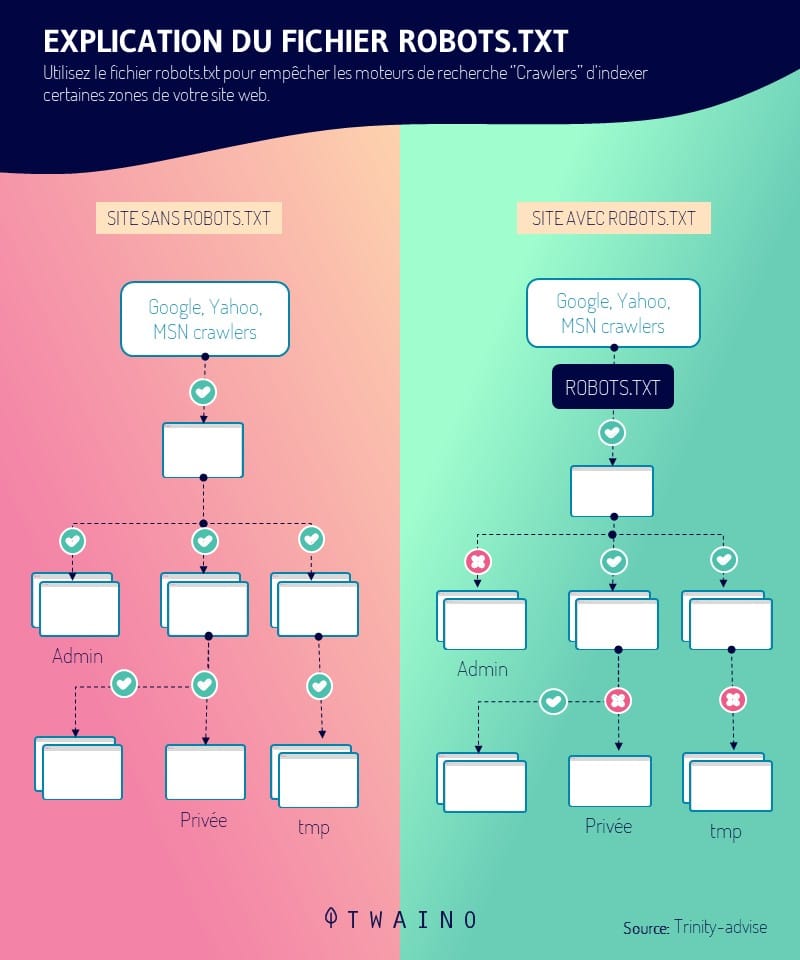

Le robot.txt représente une donnée informatique. Plus précisément, il s’agit d’un fichier texte qui est utilisé au niveau des sites web pour indiquer aux robots d’explorations (principalement ceux des moteurs de recherche) la manière dont ils doivent explorer les pages des sites internet.

De façon plus technique, ils font partie d’un protocole d’exclusion et représentent les normes qui régissent la manière dont les robots d’explorations parcourent le web, accèdent et indexent des contenus.

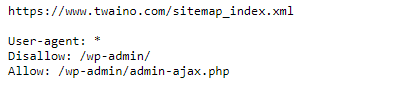

Il est inclus à la racine de votre site internet de telle sorte que si l’adresse de votre site est : www.monsite.com, l’URL conduisant au robots.txt est : www.monsite.com/robots.txt.

- Si le robots.txt est présent sur votre site, lorsque vous entrez l’URL www.monsite.com/robots.txt, vous verrez afficher une fenêtre du type :

Par contre, s’il n’est pas présent vous aurez droit à un message d’erreur de type 404.

1.2. Quelle est l’importance du fichier robots.txt pour un site Internet ?

Vous l’aurez deviné, les robots.txt jouent un rôle important au niveau de votre site internet en contrôlant la façon dont il est parcouru par les robots d’explorations.

Il peut ainsi :

- Empêcher les robots Google de parcourir un contenu dupliqué ;

- Refuser l’affichage d’une partie privée du site au niveau des SERPs ;

- Refuser l’affichage des pages de résultats de recherche internes du site dans les Résultats de recherche Google ;

- Refuser l’indexation par les moteurs de recherche de certains éléments de votre site ;

- Indiquer un temps d’exploration pour éviter la surcharge au niveau de votre site ;

- Optimiser l’utilisation des ressources de votre serveur en empêchant les robots qui gaspillent les ressources de votre site.

Maintenant que vous savez ce que c’est qu’un robot.txt et les raisons qui justifient son importance, voyons comment le créer et le mettre en place sur un site internet.

Chapitre 2 : Comment créer le fichier robots.txt pour son site Internet ?

Après avoir expliqué le processus de création du fichier robots.txt pour un site web, j’expliquerai comment il faut procéder pour savoir si son fichier marche ou pas.

2.1. Créer le fichier robot.txt pour son site internet

Le robots.txt peut être créé de façon manuelle ou générer automatiquement sur la plupart des CMS comme WordPress.

Nous allons parcourir ces deux processus de création. Cependant, avant de chercher à installer le fichier robots.txt, assurez-vous que votre site n’en dispose pas encore.

2.1.1. Créer soi-même son fichier robot.txt

Pour créer vous-même votre robot.txt, vous avez besoin d’un éditeur de texte (il s’agit d’un logiciel destiné à la création et à l’édition de fichiers texte). Notepad et sublime texte en sont des exemples.

Une fois votre éditeur choisi et téléchargé, pour créer votre fichier robot.txt, vous aurez besoin de respecter certaines règles. Ces règles concernent :

L’emplacement et le format du fichier robots.txt

- Votre fichier doit être nommé robots.txt ;

- Vous n’avez droit qu’à un seul fichier robots.txt sur votre site ;

- Votre fichier robots.txt doit être situé à la racine de votre site.

La syntaxe de votre fichier robots.txt

- Le fichier robots.txt doit respecter l’encodage UTF-8 ;

- Le fichier est composé d’un ou de plusieurs groupes comportant des instructions ;

- La règle, une instruction par ligne et par de ligne vide doit être respecté.

Les commandes (instructions ou directives) à utiliser pour construire votre fichier robots.txt :

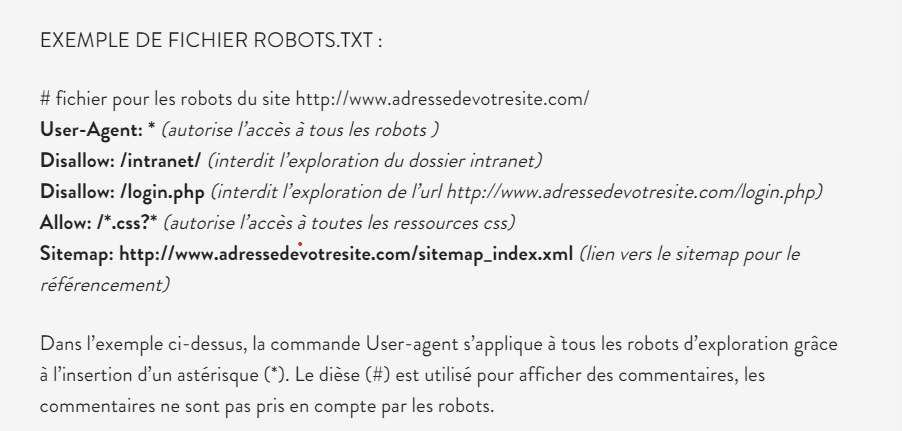

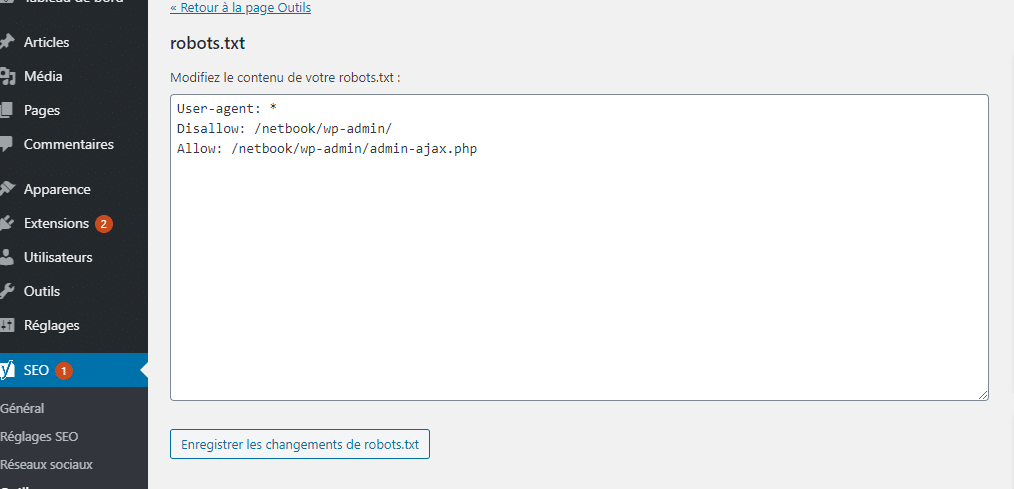

- User-agent : c’est la première ligne et il comporte le nom du robot de moteur de recherche. Vous pouvez consulter la base de données des robots pour trouver le nom du robot auquel vous voulez appliquer l’interdiction ;

- Disallow : Au niveau de cette commande, il s’agira pour vous de mettre l’URL de la page ou du dossier dont vous voulez interdire l’accès aux robots ;

- Allow : Vous permet par contre d’autoriser l’exploration d’une URL ou d’un dossier par les robots ;

- Sitemap : Cette instruction facultative vous permet d’indiquer aux robots Google, les parties qu’ils doivent obligatoirement explorer sur votre site.

Pour plus d’informations sur ces différentes règles, faites un tour sur le site du support Google.

Voici un exemple de fichier robots.txt.

source : anthedesign

Une fois que votre fichier texte est prêt, l’étape suivante serait de l’installer sur votre site web.

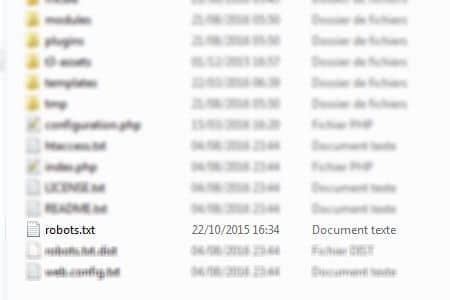

Pour cela, il suffit d’accéder à la racine de votre site à partir de votre logiciel client FTP et de déposer le fichier robots.txt dans le répertoire www.

Source : Web-eau

Voilà, votre fichier robots.txt est créé et installé sur votre site.

2.1.2. Créer le fichier robots.txt avec WordPress

Au niveau de WordPress, un fichier robots.txt est créé automatiquement pour votre site.

Si vous utilisez un site WordPress, il suffit alors de taper dans la barre de recherche l’URL de votre site suivi de : /robots.txt pour vérifier la présence du fichier robots.txt.

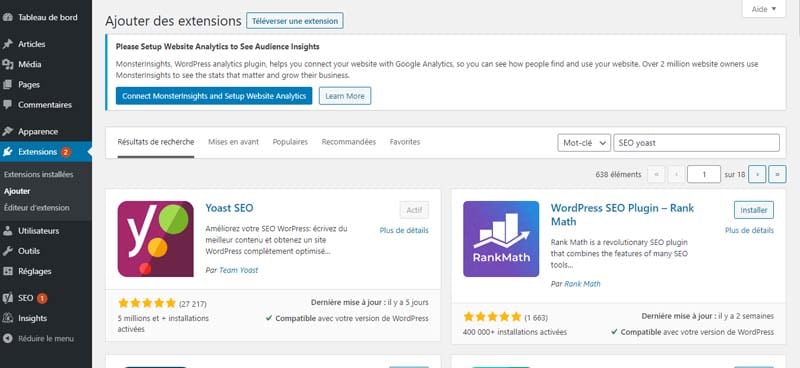

Quoi qu’il en soit, vous pouvez créer votre propre fichier robots.txt en utilisant les plugins comme SEO YOAST ou ALL IN SEO.

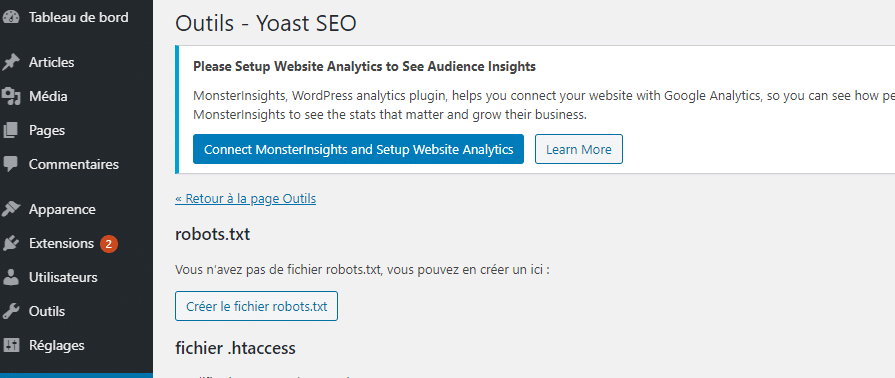

Pour créer votre fichier robots.txt avec SEO YOAST, il vous suffit de rechercher, télécharger et installer l’extension SEO YOAST dans WordPress.

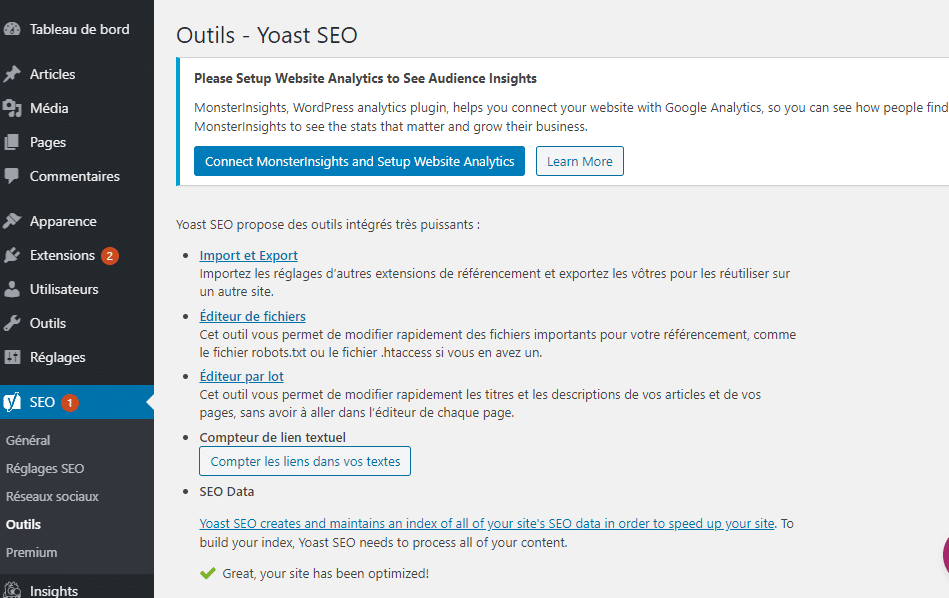

Ensuite, de l’activer et de vous rendre dans les paramètres de l’extension.

Une fois dans les paramètres sélectionnez “éditeur de fichier” et attendre le chargement de la nouvelle fenêtre qui s’affiche.

Choisissez “créer le fichier robots.txt.

Modifier enfin le contenu du robots.txt virtuel créer par WordPress et enregistrez les modifications.

Vous pouvez également créer le fichier robots.txt à partir de l’extension ALL In SEO. Pour cela, il vous faut d’abord télécharger, installer et activer l’extension.

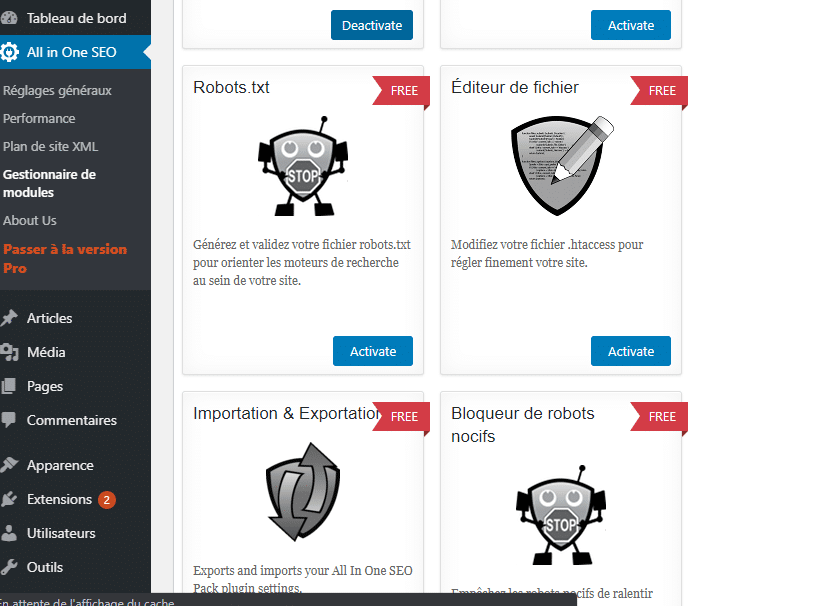

Ensuite, une fois que vous êtes dans les options de l’extension, sélectionnez gestion de modules et attendez le chargement de la nouvelle fenêtre comportant les différents modules.

Chercher le module robots.txt et appuyer sur activer pour paramétrer votre fichier robots.txt.

Voilà vous venez de créer votre fichier robots.txt de façon manuelle ou par l’usage d’un plugin sur WordPress.

L’étape suivante serait alors de vérifier si le fichier robots.txt créer marche.

Pour cela, il vous faudra faire un test.

2.3. Tester votre fichier robots txt.

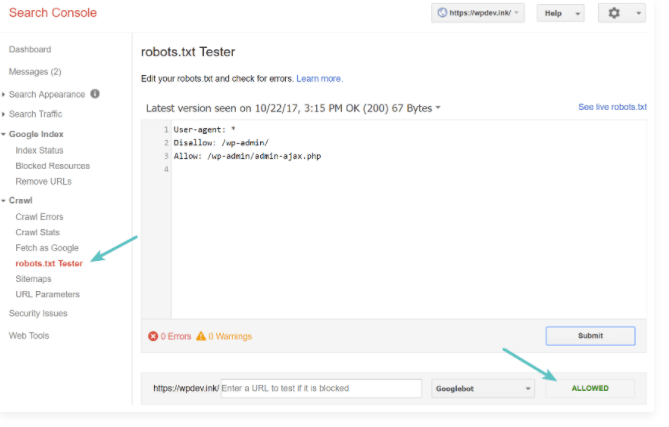

Pour tester votre fichier robots.txt, il vous suffit de suivre les instructions de Google à ce sujet.

Concrètement il s’agit de vous rendre dans votre search console et de cliquer sur l’onglet crawl puis sur robots.txt tester.

Vous avez alors accès à une fenêtre qui vous permet de soumettre à Google votre fichier robots.txt.

source : kinsa

N’oubliez pas d’intégrer les modifications à votre fichier avant de le télécharger sur le serveur de votre site.

Chapitre 3 : Les différentes utilisations du fichier robots.txt.

Ici, nous verrons quelques utilisations du fichier robots.txt. Mais avant, nous parlerons de l’objectif final d’un fichier robots.txt.

3.1. L’objectif du fichier robots.txt

Lorsque vous réussissez à créer et à installer le fichier, il est donc important de savoir comment l’utiliser.

L’utilisation des fichiers robots.txt consiste principalement à refuser et à autoriser l’accès de votre site aux robots des moteurs de recherche.

En effet, les instructions n’ont pas un même mode de fonctionnement. Le service rendu diffère d’une directive à une autre. Toutefois, le fonctionnement des instructions se résume à deux expressions : autorisation et refus.

3.1.1. Autorisation

Celle-ci consiste à autoriser tous les robots web à explorer tous les compartiments ainsi que toutes les pages web de votre site. Si tel est votre souhait, la présence du fichier robots.txt est donc inutile, puisque les instructions sont sans missions.

Par conséquent, ces dernières ne peuvent plus reconnaître ni contrôler les robots web. Il est donc recommandé en cette circonstance de s’abstenir d’installer le fichier.

Par contre, au cas où vous l’avez déjà, il est simplement conseillé de le supprimer. Toutefois, si vous souhaitez le garder, vous devez donc le laisser complètement vide sans aucune modification.

3.1.2. Refus

Il peut vous plaire d’interdire l’exploration de votre site à tous les robots web. Pour y arriver, l’installation du fichier robots.txt est importante. Il s’agit ici d’intégrer une seule instruction : bloquer l’accès de votre site à tous les robots web.

À présent qu’on connaît les deux objectifs finaux d’un robots.txt voyons maintenant comment l’utiliser pour autoriser et refuser l’accès aux robots.

3.2. Comment utiliser le fichier robots txt pour bloquer l’accès à un site entier ?

Pour empêcher les robots d’explorer votre site pour une raison ou pour une autre, il suffit d’ajouter à votre fichier robots.txt le code :

User agent : *

Disallow : /

Au niveau de ce code, l’astérisque signifie : Tous les robots et le slash au niveau de disallow sous entend que vous aimeriez interdire l’accès à toutes les pages du domaine de votre site.

3.3. Comment utiliser le fichier robots.txt pour empêcher un seul robot d’explorer votre site ?

Si vous voulez exclure l’exploration de votre site par le robot d’explorateur d’un moteur de recherche spécifique, il vous suffit d’utiliser le code :

User-agent : nom du robot

Disallow :/

L’utilisation de ce code vous permettra d’appliquer seulement la règle d’exclusion à un robot spécifique.

3.3. Comment empêcher les robots d’explorer un dossier ou un fichier de votre site ?

Pour empêcher les robots d’explorer un fichier de votre site ou un dossier, il suffit d’utiliser le code :

User agent : *

Disallow : nom du dossier

3.4. Comment utiliser le robots. Txt pour autoriser un fichier qui est contenu dans un dossier non autorisé.

Pour demander aux robots d’explorations d’indexer un contenu qui se trouve dans un dossier que vous n’aimeriez pas que les robots explorent entièrement il suffit d’utiliser le code :

User agent : *

Disallow : chemin d’accès du dossier non autorisé

Allow : chemin d’accès du fichier à explorer

Au delà de ces utilisations, notons que le fichier robots.txt peut être modifié de même vous pouvez choisir d’exclure certaines pages du fichier robots.txt

3.5. Comment modifier un fichier robots.txt ?

Il faut reconnaître qu’il est très rare de retoucher un fichier robots.txt déjà installé. Cependant, il est bien possible de le modifier. Sauf que vous devez vous attendre à une reconfiguration de votre site.

Si vous avez créé et installé votre fichier manuellement, il vous faut alors ouvrir votre fichier robots.txt à la racine de votre site et procéder aux différentes modifications que vous aimeriez apporter. Une fois terminé, vous devez enregistrer les modifications et sauvegarder votre fichier.

Par contre, si vous utilisez un CMS comme WordPress, vous pouvez modifier votre fichier en utilisant les plugins SEO YOAST et All In SEO en suivant les instructions de la partie 2.2.

3.6. Comment exclure certaines pages de votre fichier robots.txt ?

Comme il est possible de modifier ce fichier, sachez qu’il est également possible d’exclure certaines pages de votre base de robots.txt. Il s’agit ici de soustraire certaines adresses URL autorisées à accéder au moteur de recherche de votre site.

Pour le faire, vous devez remonter à la racine de votre site. Vous devez réussir à accéder au contenu du fichier. Rendez-vous ensuite dans le dossier de l’instruction Disallow. C’est cette directive qui constitue donc la mémoire de toutes les adresses URL autorisées.

Il vous revient par la suite de recenser les adresses indésirables que vous souhaitez extraire de votre base. Il suffit de les décocher et elles sont considérées désormais comme des URL non autorisées.

À présent que vous savez tout sur l’utilisation des robots txt, je vous présente dans le chapitre quelques bonnes pratiques à adopter.

Chapitre 4 : Quelques Bonnes pratiques à avoir pour votre fichier txt

Pour bien utiliser vos fichiers robots.txt :

- Dans la configuration de votre fichier robots.txt, faites en sorte que seules les pages qui n’ont pas de valeur soient bloquées ;

- Veillez à ne pas bloquer les fichiers JavaScript et CSS de votre site ;

- Faites toujours un test après la configuration de votre fichier robots.txt pour être certain que vous n’avez rien bloqué par accident ;

- Placez toujours le fichier robots.txt dans le répertoire racine de votre site ;

- Veillez à bien nommer votre fichier “robots.txt” ;

- Ajoutez l’emplacement de votre plan de site à votre fichier robots.txt.

Et voilà, nous en avons fini avec les éléments à garder en tête lorsqu’il s’agit de manier votre fichier robots.txt.

En résumé

Les robots.txt sont des fichiers texte installés à la racine des sites internet pour contrôler l’exploration et l’indexation de leurs contenus par les différents robots des moteurs de recherche.

Dans cet article, vous trouverez non seulement en quoi ils peuvent être utiles pour votre site, mais aussi comment les utiliser pour en tirer le meilleur parti.