El cambio de algoritmo es una actualización del algoritmo de Google que se caracteriza por la adición de una nueva señal de clasificación. Estas actualizaciones ayudan a perfeccionar los resultados de las búsquedas y a ofrecer respuestas relevantes a las consultas de los usuarios. Aunque Google actualiza regularmente su algoritmo, el cambio corresponde a modificaciones importantes que afectan a los resultados de las búsquedas.

Los primeros resultados de la búsqueda son los que reciben más clics orgánicos. Y según un estudio, los 5 primeros resultados representan el 67, 60% de todos los clics.

Por esta razón, la mayoría de los propietarios de sitios web quieren situar su sitio en los primeros resultados. Sin embargo, esto es difícil porque el algoritmo de búsqueda de Google utiliza más de 200 factores para clasificar los sitios web.

Además, el mundo del SEO está en constante cambio y Google actualiza con frecuencia su algoritmo para mejorar la experiencia del usuario y adaptarse a las nuevas tendencias.

Las actualizaciones más importantes, todavía llamadas cambio de algoritmo, consisten en la adición de una nueva señal de clasificación. Estos cambios son bien conocidos y Google los comunica a menudo.

He recopilado estas mayores actualizaciones del algoritmo de Google que le presentaré en este artículo.

También descubrimos cómo prepararse para las próximas actualizaciones de los motores de búsqueda para que no afecten a su sitio.

Así que ¡siga con nosotros!

Capítulo 1: ¿Qué está cambiando el algoritmo?

Google se esfuerza cada día por mejorar la forma en que procesa las consultas para ofrecer mejores resultados a sus usuarios. Estos esfuerzos se manifiestan en las grandes actualizaciones que el motor de búsqueda realiza en su algoritmo.

Este capítulo está dedicado a la definición de cambio de algoritmo y a las razones por las que debe interesarse por las diferentes actualizaciones.

1.1. Definición de cambio de algoritmo

Según Hubspot, el número de consultas que Google procesa cada segundo se estima en 63.000. Con un volumen tan elevado de consultas, el motor de búsqueda puede tener dificultades para dar una respuesta precisa a cada una de ellas.

Para hacer frente a estas dificultades, la empresa estadounidense ha creado un algoritmo que determina qué sitios web son relevantes y pueden mostrarse para una palabra clave o frase concreta.

Google realiza actualizaciones periódicas de su sistema para corregir los fallos de su algoritmo y frustrar los sitios que intentan manipularlo. La mayoría de estas actualizaciones son pequeños cambios que suelen pasar desapercibidos.

Sin embargo, el motor de búsqueda a veces realiza actualizaciones importantes que tienen un efecto significativo en los resultados de Google

Estos cambios sutiles que Google realiza en su algoritmo se denominan Cambio de Algoritmo. La mayoría de las veces se caracterizan por la adición de una nueva señal al algoritmo principal.

1.2. ¿Por qué debería preocuparse por el cambio de algoritmo?

Las principales actualizaciones del algoritmo de Google pueden ayudar a las empresas que generan ingresos a partir del tráfico orgánico y la conversión a aumentar sus ingresos.

Al mismo tiempo, pueden perjudicar a las empresas que dependen del marketing digital. Esto se debe a que las actualizaciones son beneficiosas cuando mejoran el rendimiento de un sitio.

Pero cuando los nuevos cambios penalicen algunas de las prácticas que solía utilizar en su sitio, obviamente perderá tráfico orgánico y conversiones.

Estar atento a las principales actualizaciones le permite revisar su estrategia de SEO para mantener su lugar en las SERPs.

Es igualmente importante conocer las principales actualizaciones anteriores, ya que esto le ayudará a comprender las prácticas que han quedado obsoletas y de las que puede no ser consciente.

En los siguientes capítulos, conoceremos los principales cambios en el algoritmo de Google.

Capítulo 2: La actualización de Google Panda en 2011

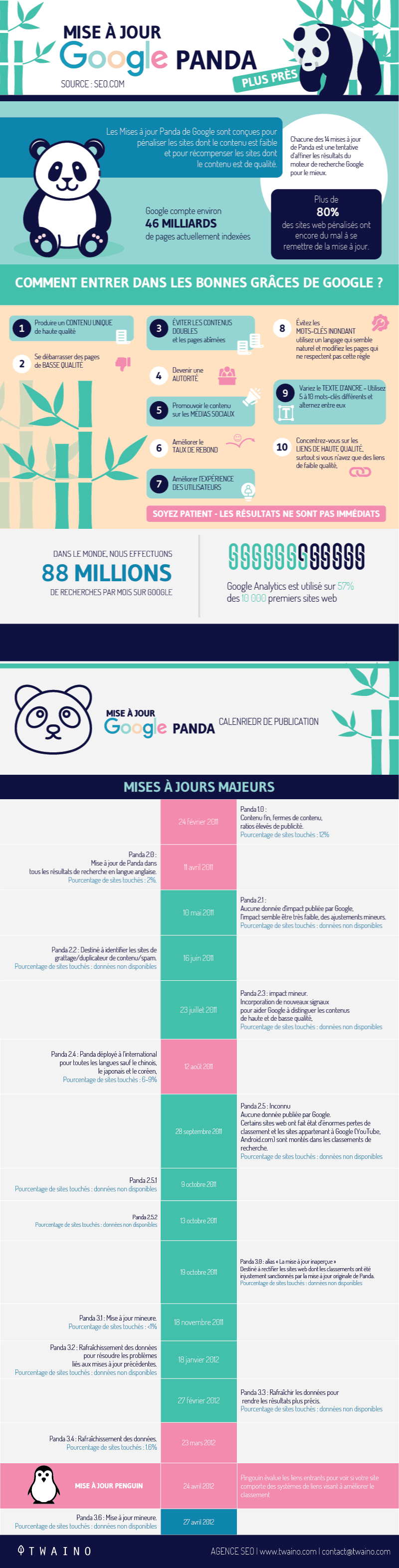

Google Panda es uno de los cambios más importantes y famosos del algoritmo de Google. En este capítulo descubriremos en qué consiste esta actualización y cómo adaptarnos a ella.

2.1. ¿Qué es Google Panda?

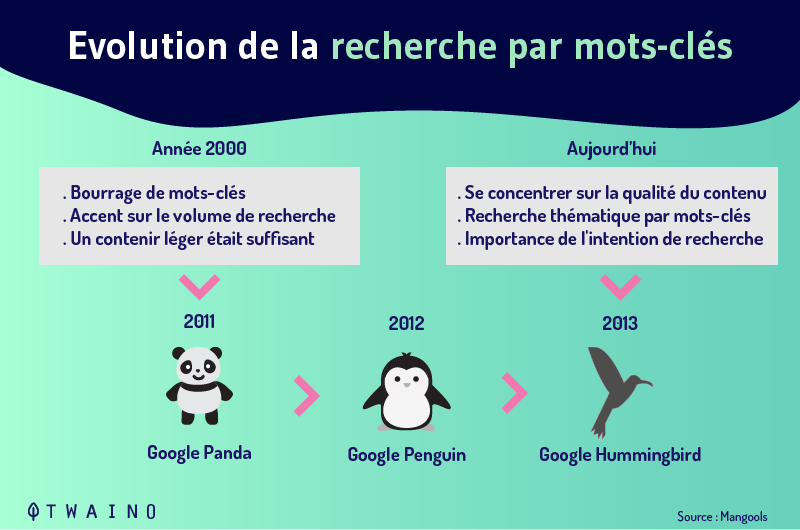

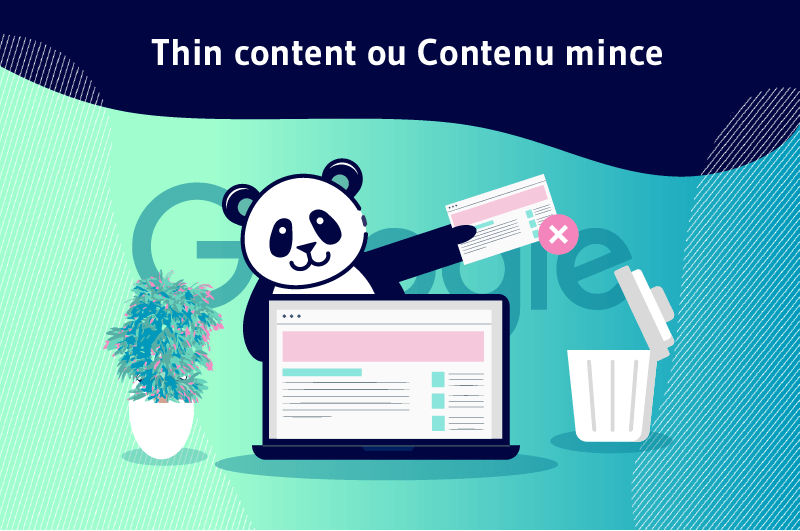

Antes de Panda, los webmasters y los SEOs utilizaban todo tipo de formas para clasificar un sitio en las SERPs.

Como resultado, los mejores sitios no siempre ganaron en las clasificaciones de búsqueda y el contenido de baja calidad comenzó a aparecer en los resultados de búsqueda.

Para corregir esto y ofrecer contenido de calidad a sus usuarios, Google realizó este importante cambio en su algoritmo.

Esta actualización comenzó en Estados Unidos en febrero de 2011 y luego en otros países a partir del 12 de agosto del mismo año. Desde su introducción, Panda ha sido objeto de frecuentes cambios.

A través de Panda, Google pretende mejorar la experiencia de sus usuarios eliminando las páginas de spam de los resultados de búsqueda.

El objetivo es castigar a los sitios que ofrecen contenidos de baja calidad y premiar a los que ofrecen contenidos frescos y de excelente calidad.

En otras palabras, Google Panda actúa como un filtro que retiene los sitios de alta calidad y empuja los sitios de baja calidad a la parte posterior de las SERP.

2.¿Cómo ha afectado Google Panda a los sitios y qué factores hacen que un sitio sea vulnerable a esta actualización?

El despliegue de Google Panda ha afectado a muchos sitios de forma significativa y se estima que ha afectado a más del 12% de los sitios sólo en el mercado estadounidense.

En general, los cambios de SEO provocados por la actualización de Panda han afectado a más del 80% de los sitios.

Con Google Panda, los webmasters tienen claro que sólo los contenidos que aportan valor a los usuarios pueden tener visibilidad en los resultados de búsqueda. Los factores que hacen que un sitio sea vulnerable incluyen:

- No hay suficiente contenido único;

- Pocos o ningún backlink de alta calidad;

- Poco tiempo de retención de los visitantes (tiempo en la página y tiempo en el sitio);

- Un alto porcentaje de contenido duplicado;

- Alta tasa de rebote;

- Un alto porcentaje de páginas sin apenas contenido único u original

- Un elevado número de anuncios irrelevantes;

- El contenido de la página (y la etiqueta del título de la página) no coincide con las consultas de búsqueda para las que se realiza la página;

- Un número inusualmente alto de repeticiones de la misma palabra en una página

Cuando Google Panda identifica uno de estos factores en su sitio, puede afectar no sólo a la página en cuestión, sino al sitio en su conjunto.

2.¿Cómo puedo saber si Google Panda está afectando a mi sitio y cómo puedo salir de él?

Para saber si su sitio está afectado, compruebe el rendimiento de su sitio con frecuencia. Si sus páginas caen repentinamente en las SERPs de un día para otro, es probable que Panda esté penalizando su sitio.

La solución práctica a esto es simplemente corregir o eliminar el contenido de baja calidad. Para ello, realice una evaluación del contenido de su sitio para encontrar las páginas afectadas por Panda.

A continuación, cree un contenido que cumpla las directrices de Google para evitar una caída en la clasificación en futuras actualizaciones.

Capítulo 3: La actualización de Google Penguin en 2012

En este capítulo hablaremos de la actualización de Google Penguin contra los malos backlinks.

3.¿Qué es Google Penguin?

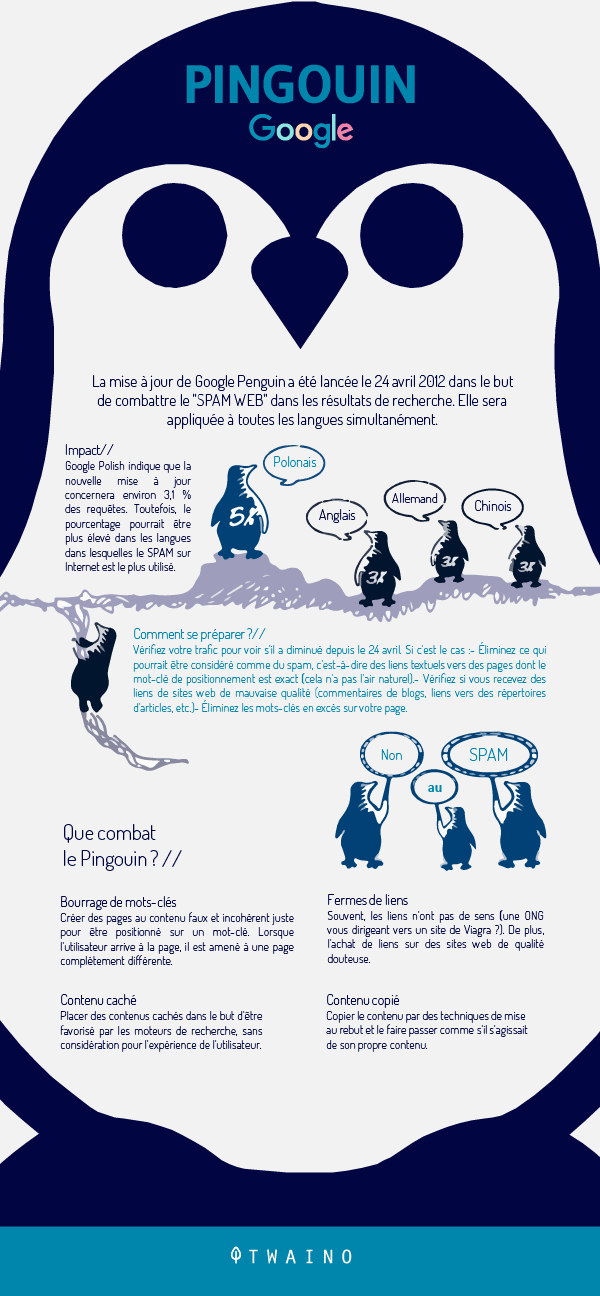

Google Penguin es una importante actualización de Google lanzada en 2012 para reforzar a Panda. Tras la puesta en marcha de Panda para hacer frente a los sitios de baja calidad, Google se dio cuenta de que seguía habiendo mucho spam en las SERP.

Así que el motor de búsqueda volvió con Penguin para lidiar con los sitios de spam restantes. El objetivo de Penguin es reducir el spam en la web y castigar a los sitios que manipulan las clasificaciones mediante técnicas de construcción de enlaces de «sombrero negro».

Esta actualización se centra en los enlaces entrantes de un sitio. Tras varios pequeños cambios, Penguin pasó a formar parte del algoritmo principal de Google en 2016.

Eso sí, se ejecuta junto al algoritmo principal para evaluar los sitios web y los enlaces en tiempo real

3.2. ¿Cuál es el impacto de Google Penguin?

Cuando Google Penguin advierta que su sitio está siendo objeto de spam o de manipulación, las páginas afectadas perderán su posición en las SERP. Esto es especialmente cierto para los sitios que obtienen enlaces de forma no natural, como

- El uso de esquemas de enlaces que implican enlaces no naturales e intercambios de enlaces excesivos;

- Anuncios de texto fraudulentos;

- Backlinks de baja calidad

- Uso excesivo de enlaces con texto ancla optimizado.

En la mayoría de los casos, el descenso de categoría no afecta a todo un dominio. Sólo afecta a las palabras clave para las que el sitio ha estado haciendo spam o sobreoptimizando sus páginas.

El impacto de las sanciones también puede pasar de un dominio a otro y no tiene sentido redirigir el antiguo dominio a uno nuevo para escapar de las sanciones.

3.3. ¿Qué hacer cuando Google Penguin sanciona un sitio?

Los sitios que aumentan artificialmente su clasificación mediante la compra de enlaces de granjas de enlaces u otros sitios de spam deben deshacerse de estos backlinks adquiridos ilegalmente.

Para ello, deben desautorizar estos enlaces mediante la herramienta de desautorización. La desautorización de enlaces consiste en enviar a Google, en un archivo, las URL que debe ignorar para que no tengan efecto en su sitio.

Sin embargo, si comete el error de desautorizar los enlaces de autoridad, Google también los ignorará y dejarán de contribuir a su clasificación.

Por eso es aconsejable vigilar su perfil de backlinks y analizar cada uno de los enlaces que llegan a su sitio. El análisis de estos enlaces le permitirá determinar cuáles son de mala calidad o son spam.

Capítulo 4: Cambios de algoritmo – Google Hummingbird, Mobilegeddon, Fred y los Intersticiales Intrusivos

En este capítulo conoceremos cuatro actualizaciones importantes de Google, entre ellas:

- Colibrí ;

- Mobilegeddon ;

- Fred;

- Intersticiales intrusivos

4.1. La actualización de Google Hummingbird

El despliegue de la actualización Hummingbird en 2013 cambió significativamente los viejos hábitos de búsqueda. En el pasado, escribíamos palabras clave en el motor de búsqueda y éste nos proporcionaba enlaces que contenían esas palabras específicas.

Google Hummingbird hizo que el algoritmo de búsqueda fuera lo suficientemente inteligente como para tener en cuenta ahora el contexto en el que las personas realizan las consultas.

En términos sencillos, esta actualización tiene que ver con la intención de búsqueda. Ahora Google es capaz de entender el significado de una frase y devolver resultados más precisos para consultas de búsqueda complejas.

Desde un punto de vista técnico, el motor de búsqueda ha integrado la búsqueda semántica en su algoritmo. Este último tiene en cuenta una serie de elementos, a saber

- Búsqueda contextual

- La ubicación de la búsqueda

- La intención de la consulta

- El uso de sinónimos

- Sintaxis

- Consultas comunes e inusuales

- Consultas conceptuales.

Google también utiliza una base de conocimientos llamada gráfico de conocimientos. Se trata de una colección de conocimientos estructurados obtenidos de expertos del sector que el motor de búsqueda asocia con objetos específicos.

Para aprovechar esta actualización, los sitios web deben crear regularmente contenidos que sean relevantes para un público específico. La idea es crear un gran número de artículos originales sobre temas de su especialidad.

También es aconsejable optar por el uso de palabras clave de cola larga para enriquecer el campo semántico de su contenido. También puede navegar por los sitios de noticias de su sector y crear contenidos creativos basados en los temas de tendencia.

4.2. La actualización del Mobilegeddon

Históricamente, la mayoría de las búsquedas en línea se realizaban en ordenadores de sobremesa.

Por lo tanto, muchos sitios optimizaban sus páginas para ordenadores de sobremesa y no tenían una versión móvil, por lo que no había necesidad de optimizar sus sitios para móviles.

Pero el auge de los teléfonos inteligentes ha desplazado la búsqueda en línea a los dispositivos móviles. Según un estudio, el 80% de los usuarios de Internet utilizaron un dispositivo móvil para buscar en la web en 2019.

Para satisfacer la creciente necesidad de búsqueda móvil y mantener su posición de liderazgo, Google realizó una importante actualización en 2015 conocida como Mobilegeddon.

Esta actualización da prioridad a los dispositivos móviles y la facilidad de uso de los mismos se convirtió en un factor de clasificación.

Así, cuando los usuarios buscan en sus smartphones, son las páginas adaptadas a los móviles las que aparecen en las SERP. En otras palabras, el Mobilegeddon sólo afecta a los rankings de búsqueda móvil.

Para ayudar a los webmasters a comprobar la facilidad de uso de su sitio, Google ha puesto a su disposición herramientas como el Google Mobile-Friendly Test. Esta herramienta permite comprobar la adaptabilidad de un sitio a los móviles.

También es posible comprobar directamente en Google Search Console/Mobile Usability el grado de optimización de su sitio para móviles.

La herramienta PageSpeed también le permitirá comprobar la velocidad de carga de los recursos de su sitio. Cuanto más lenta sea la carga de sus páginas, más se degrada la UX.

4.3. Actualización de Fred en 2017

Para sorpresa de todos los SEOs y webmasters, algunos sitios web experimentaron una caída masiva del tráfico orgánico en marzo de 2017. Fue una actualización del algoritmo de Google que provocó una caída del tráfico de hasta el 90%.

Inicialmente, Google no había anunciado el despliegue de una actualización, lo que causó pánico en la comunidad de webmasters y SEO. El nombre atribuido a esta actualización no es singular.

Según un experto en análisis web de Google, el nombre «Fred» se refiere a todos los cambios para los que Google no nos da un nombre.

En el resto de este artículo, cualquier referencia a Fred se hace en el contexto de la gran actualización del 7 de marzo que tuvo un gran impacto en los sitios web.

Aunque el propósito de esta gran actualización fue vago durante mucho tiempo, muchos SEOs creen que el principal factor detrás de Fred fue la calidad.

Se trata de eliminar lo que Google consideraba resultados de baja calidad, es decir, sitios con poco contenido que mostraban anuncios agresivos.

La actualización de Fred afecta principalmente a los sitios que priorizan la monetización sobre la experiencia del usuario.

Los sitios más afectados por esta actualización son los que crean contenidos únicamente para mejorar su clasificación y no para satisfacer la intención de búsqueda.

Esto va en contra de la política de Google de ofrecer contenidos de calidad basados en las necesidades de los usuarios. Hoy en día, la mayoría de los sitios están adoptando esta dinámica y creando contenidos que realmente aportan un valor único al lector.

Utilizan herramientas de SEO para analizar los tipos de contenido que pueden interesar a los usuarios y generar tráfico

4.4. Actualización de Intersticiales intrusivos

A medida que la búsqueda móvil se impone, Google busca mejorar la experiencia del usuario en los dispositivos móviles. Con esto en mente, el motor de búsqueda ha puesto en marcha la actualización de «intersticiales intrusivos».

Consiste en penalizar las páginas cuyos recursos no son directamente accesibles a los usuarios desde las páginas de búsqueda. Son anuncios, ventanas emergentes o banners que se superponen al contenido de una página.

Hay que admitir que estos anuncios arruinan la experiencia del usuario en los dispositivos móviles, ya que los usuarios siguen sin poder ver el botón de cierre para volver al contenido.

Por ello, Google ha lanzado una guerra contra los intersticiales intrusivos. Está degradando los sitios que son culpables de esta práctica en los SERPs. Google ya no considera que estos sitios sean aptos para móviles.

Sin embargo, no son todos los intersticiales los que Google está penalizando. Más bien, son los intersticiales los que tienden a oscurecer completamente el contenido de una página y dan lugar a una experiencia frustrante.

Pero la penalización de Google no se aplica a los intersticiales de verificación de edad ni a las cookies. También hay que recordar que la penalización de los intersticiales sólo afecta a la transición de los resultados de búsqueda a la página en cuestión.

Por lo tanto, los intersticiales de salida no se ven afectados, como tampoco los intersticiales de página a página.

Capítulo 5: Cambios en el algoritmo – La actualización de RankBain

RankBain es una actualización que ha supuesto un gran cambio en la forma en que Google maneja los resultados de búsqueda. Este capítulo trata de cómo funciona RankBain y cómo optimizar su sitio para ello.

5.1. ¿Qué es RankBain?

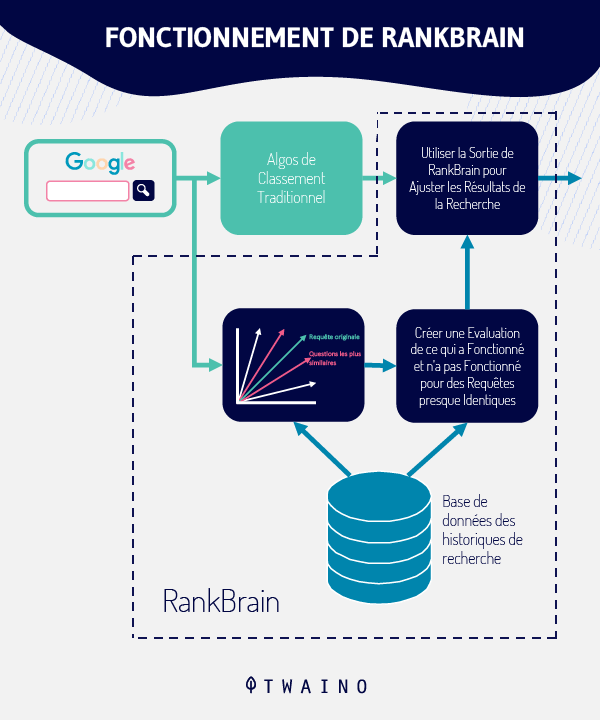

RankBain se utiliza desde 2015 y ahora es una parte constitutiva del algoritmo principal de Google. Esta importante actualización se basa en Hummingbird para comprender la intención de las consultas de búsqueda.

RankBain, por su parte, utiliza el aprendizaje automático y la inteligencia artificial (IA) para aprender sobre los usuarios y cómo reaccionan a los resultados de las búsquedas

La IA permite que las máquinas entiendan y actúen como los humanos al tomar una decisión sobre una tarea.

En términos de aprendizaje automático, es la capacidad de las máquinas de aprender por sí mismas a partir de los datos que reciben.

En pocas palabras, RankBain permite que el algoritmo principal de Google procese los resultados de la búsqueda como un humano y aprenda sobre los usuarios para entender sus preocupaciones.

Inicialmente, sólo procesa el 15% de las consultas realizadas cada día, incluyendo aquellas que Google nunca había registrado antes. Más tarde, se amplió para incluir otras búsquedas, y hoy en día interviene en la mayoría de las consultas introducidas en el motor de búsqueda.

RankBain no sólo entiende los nuevos términos de búsqueda, sino que es capaz de cambiar el algoritmo por sí mismo para adaptarse a ellos.

Por ejemplo, Google pidió a un grupo de ingenieros y a RankBain que determinaran la mejor página para una consulta específica. Contra todo pronóstico, el programa superó a los ingenieros de la empresa estadounidense en un 10%

5.2. ¿Qué hace que RankBain sea tan preciso y cómo funciona?

Utiliza señales de experiencia de usuario para mostrar al visitante los resultados que probablemente le gusten. Cuanta más gente le guste una página en los resultados de la búsqueda, más alto se clasificará esa página.

Pero cuando a la gente no le gusta una página, ésta será sustituida en los resultados de búsqueda y perderá su lugar.

RankBain es capaz de determinar si a la gente le gusta una página mirando cosas como

- Tasa de clics orgánicos: personas que hacen clic desde los resultados de la búsqueda;

- Tiempo de permanencia: la cantidad de tiempo que un visitante pasa en un sitio

- Tasa de rebote: el porcentaje de personas que abandonan el sitio rápidamente.

5.3. ¿Cómo optimizar un sitio para RankBain?

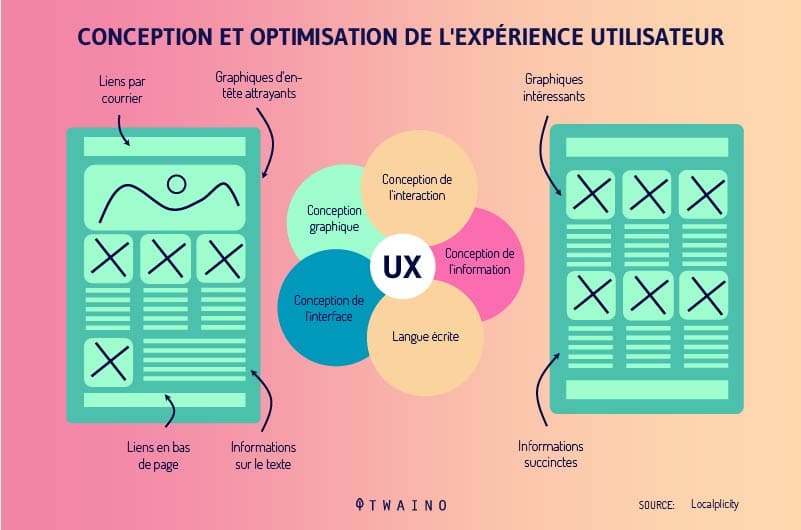

Como RankBain utiliza señales de UX en la clasificación de las páginas, es importante mejorar la experiencia del usuario en todo su sitio.

Esto significa crear un gran contenido que sea accesible y que realmente beneficie a los usuarios. Además, las páginas deben cargarse muy rápidamente y su interfaz debe ser bonita y fácilmente navegable.

Cuanto más útil sea su contenido y más fácil sea la navegación por su sitio, más tiempo pasarán los visitantes en su sitio. Esto reduce la tasa de rebote, lo que es bueno para su sitio.

De esta manera, usted señala a RankBain que la gente quiere su sitio en su zona y aumenta sus posibilidades de subir en las SERP.

Capítulo 6: Cambio de algoritmo – Actualizaciones de Google BERT y Core Web Vitals

En este capítulo hablaremos de las actualizaciones de BERT y Core Web Vitals.

6.1. La actualización del BERT de Google

6.1.1. ¿Qué es Google BERT?

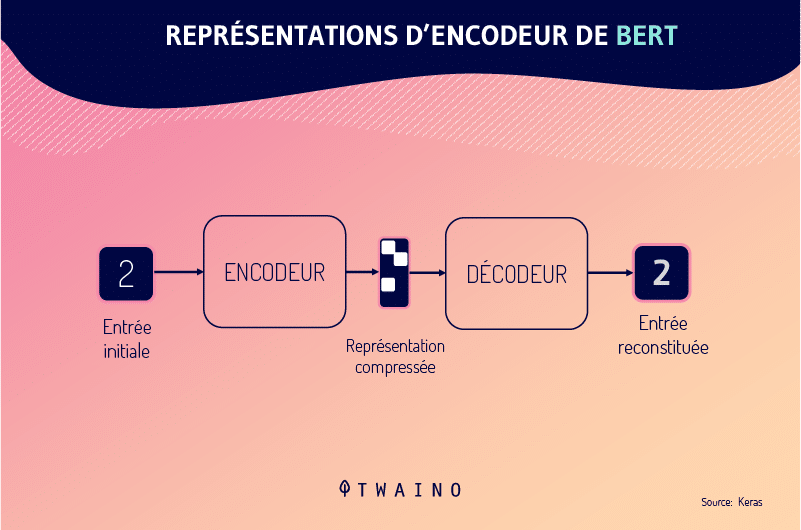

Esta actualización es un modelo de procesamiento del lenguaje natural (PLN) preentrenado y de código abierto desarrollado por Google. Es capaz de interpretar la intención y el contexto de una consulta de búsqueda basándose en la relación entre el conjunto de términos de búsqueda.

El modelo BERT intenta comprender el contexto de una palabra en relación con todas las demás palabras que la rodean, lo que hace que los resultados de las búsquedas sean más precisos.

Al igual que RankBain, BERT es un algoritmo de aprendizaje automático que aprende a medida que encuentra nueva información.

Las capacidades de comprensión del lenguaje de BERT ofrecerán a los usuarios mejores resultados que satisfagan su intención real.

De hecho, la intención de búsqueda se basa más en los intereses de los usuarios. Los usuarios suelen expresar sus intenciones en forma de consultas en los motores de búsqueda.

Pero siempre es difícil para los motores de búsqueda como Google interpretar la intención deseada. Por ejemplo, Google cree que los usuarios utilizan varios términos (o incluso frases) por una razón específica.

Temen que los motores de búsqueda no entiendan las consultas compuestas por uno o muy pocos términos. Para llenar este vacío, Google ha puesto en marcha la actualización Google BERT

6.1.2. Impacto de la búsqueda por voz: ¿Cuál es el impacto de Google BERT?

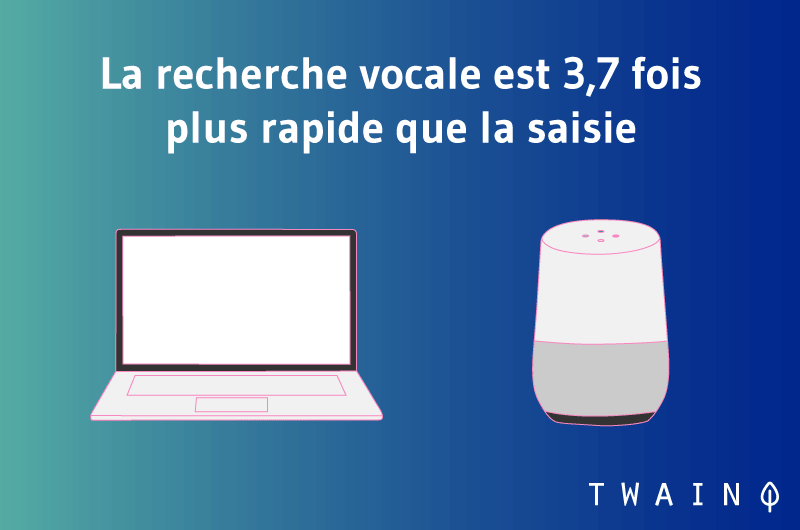

El modelo BERT también se aplica a la búsqueda por voz. Incluye una función de procesamiento lingüístico que tiene en cuenta los diferentes acentos del idioma.

La búsqueda por voz está en auge y es, sin duda, la próxima gran novedad en el mundo del SEO. Según un estudio, el 20% de las consultas móviles provienen actualmente de la búsqueda por voz.

Además, el 72% de las personas que utilizan dispositivos de búsqueda por voz afirman que se ha convertido en parte de su rutina diaria. Esto sugiere que la gente está utilizando la búsqueda por voz con regularidad.

Esto se debe a que dan resultados mucho más rápidos y son mucho más fáciles.

De hecho, la actualización del BERT hace que los resultados de la búsqueda sean muy precisos. Desde su puesta en marcha, el reconocimiento de voz tiene una precisión del 95% respecto a 2013, según Google.

Dado que la búsqueda por voz es una parte tan importante de la búsqueda, es esencial que las grandes empresas y los pequeños negocios locales optimicen sus sitios web y aplicaciones para ello.

Se calcula que el 58% de las personas utilizan la búsqueda por voz para informarse sobre un negocio local.

Además, la optimización para la búsqueda por voz debe tener en cuenta por qué la gente busca por voz.

Una encuesta publicada por un grupo de expertos de Google sugiere que, a través de la búsqueda por voz, la gente suele buscar información sobre:

- Cómo utilizarlo;

- Ofertas; y

- Ventas; y

- Próximos eventos;

- Asistencia al cliente;

- Números de teléfono;

- Etc.

6.2. Actualización de Core Web Vitals (agosto de 2021)

Después de tres meses de despliegue gradual, Google ha confirmado ahora la finalización de esta actualización que añadirá Core Web Vitals como factor de clasificación.

El motor de búsqueda prioriza la experiencia del usuario con Core Web Vitals midiendo el rendimiento de un sitio en función de la experiencia del visitante cuando llega a una página.

El algoritmo actualizado de Core Web Vitals está diseñado para ofrecer a los visitantes de cualquier página web una experiencia mejor y más segura que nunca.

La experiencia de página no es más que el conjunto de señales que miden cómo perciben los usuarios la experiencia de interactuar con una página web más allá de su valor puramente informativo.

Las señales de experiencia de página de Google incluyen

- HTTPS

- Ausencia de intersticios intrusivos

- Facilidad para los móviles.

Estas señales combinadas desempeñarán ahora un papel clave en la clasificación de los sitios web.

6.3. ¿Cómo prepararse para los próximos cambios del algoritmo de Google?

Para prepararse mejor para las próximas actualizaciones y no perder las clasificaciones de la noche a la mañana, es necesario aprender de los cambios anteriores que Google realizó en el algoritmo de Google

Estas actualizaciones previas le ayudarán a dominar los fundamentos del algoritmo. El objetivo principal del motor de búsqueda es proporcionar a sus usuarios respuestas relevantes a sus consultas con mayor rapidez.

Está claro que Google seguirá trabajando en este sentido para que la experiencia del usuario sea aún mejor.

Por lo tanto, para mantenerse al día con las próximas actualizaciones, debe seguir creando contenidos de alta calidad que realmente gusten a los visitantes.

También es importante reducir el tiempo de carga de sus páginas web, hacer que su sitio sea fácil de usar y evitar la publicidad agresiva. De lo contrario, los usuarios se sentirán decepcionados y las señales de UX de su sitio serán pobres.

Así lo demuestra un estudio de Google que estima que cuando los tiempos de carga de las páginas aumentan en 10 segundos, es probable que los visitantes reboten.

Además, debe supervisar regularmente el rendimiento de su sitio para identificar un cambio repentino en las métricas del mismo. Esto probablemente indica que una actualización está afectando a su sitio.

A continuación, empiece a buscar las razones por las que está perdiendo posiciones para poder realizar cambios de acuerdo con el algoritmo de Google.

Capítulo 7: Cambio de algoritmo – Preguntas frecuentes sobre las actualizaciones de Google

Este capítulo está dedicado a las preguntas más frecuentes sobre las actualizaciones del algoritmo de Google.

7.1. ¿Cuántas actualizaciones realiza Google en su algoritmo al año?

El gigante estadounidense realiza regularmente cambios en su algoritmo básico. Aunque no hay un número exacto, Google actualiza su algoritmo entre 500 y algunos miles de veces cada año, según Neil Patel.

Tenga en cuenta que la mayoría de estos cambios son menores y no afectan inmediatamente a las clasificaciones. Sin embargo, estas actualizaciones aparentemente inocuas pueden tener un impacto en el rendimiento de su sitio a largo plazo.

Por otro lado, las actualizaciones a gran escala como las que hemos presentado en este artículo afectan a los sitios y a los resultados de las búsquedas con mayor rapidez.

7.2. ¿Por qué es importante el algoritmo de Google?

El algoritmo de Google es el responsable de procesar los resultados y los diferentes cambios pueden afectar directamente a su sitio. Cuando su sitio no sigue las directrices de Google, éste puede penalizarlo y perderá su lugar en las SERP.

Pero cuando su sitio está en la cima, el algoritmo de Google le premia en las SERP y puede obtener clientes potenciales cualificados de la búsqueda orgánica.

7.3. ¿Cuáles son los cambios importantes en el algoritmo de Google?

7.3.1. La actualización de Panda en 2011

La actualización Panda se lanzó por primera vez en 2011, pero pasó por varias actualizaciones hasta 2016, cuando se añadió al algoritmo de clasificación.

Panda apunta al spam y a los contenidos débiles que no ayudan a los usuarios. También penaliza el contenido fino, el contenido duplicado y el contenido con demasiados anuncios.

7.3.2. La actualización de los pingüinos – 2012

Aproximadamente un año después de la actualización de Panda, se lanzó la actualización de Penguin, que volvió a dar prioridad al contenido de calidad. Esta actualización se dirige al spam mediante el examen de los backlinks.

Premia a los que tienen backlinks orgánicos de calidad y penaliza a los que tienen perfiles de backlinks no naturales.

7.3.3. La actualización del colibrí – 2013

La actualización Hummingbird fue un cambio en el algoritmo de Google para hacerlo más inteligente en la interpretación de la búsqueda semántica.

Fue diseñado para ayudar a Google a entender la intención y el contexto. Esto ha obligado a los profesionales del SEO a orientarse hacia las palabras clave de cola larga.

También ha animado a los profesionales del marketing a crear contenidos basados en la intención y las necesidades del usuario, en lugar de en una sola palabra clave.

7.3.4. La actualización de los móviles – 2015

La actualización móvil ha obligado a todos los sitios a adaptarse a los móviles o a arriesgarse a ser penalizados en las SERP para la búsqueda móvil. Afecta a todos los sectores y cada sitio debe tener una versión móvil de su web.

7.3.5. La actualización de RankBrain – 2015

Cuando RankBrain se puso en marcha, introdujo la inteligencia artificial y el aprendizaje automático en el algoritmo de Google.

Esta parte del algoritmo tiene la capacidad de supervisar el comportamiento de los usuarios y las respuestas a las consultas para «aprender» más sobre la intención y el valor de ciertas páginas. Ahora es la tercera señal de clasificación más importante para Google.

7.3.6. Intersticiales para móviles – 2017

Esta actualización es una penalización de SEO que se aplica a los sitios que tienen anuncios intersticiales que oscurecen el contenido de la página.

No se trata de una sanción general para todos los intersticios. Se centra únicamente en las intersticiales intrusivas en el móvil y en las intersticiales que requieren que el visitante las rechace manualmente.

7.3.7. La actualización «Fred» de Google – 2017

Una actualización del algoritmo no confirmada, Fred tuvo un impacto significativo en los resultados de las consultas. Algunos sitios experimentaron caídas de tráfico de hasta el 90%.

Los parámetros exactos de Fred nunca han sido confirmados por Google. Pero parece que se dirige a los sitios que se centran en mostrar anuncios y/o widgets de monetización del tráfico a expensas del contenido.

7.3.8. BERT – 2019

El BERT es un esquema de procesamiento del lenguaje natural basado en una red neuronal. Proporciona una mejor comprensión del contexto completo de una consulta al examinar todas las palabras de la búsqueda.

Al igual que Hummingbird, busca mejorar la experiencia del usuario y ofrecer resultados relevantes más rápidamente.

7.3.9. Núcleo de la Web Vitals

Los elementos vitales de la web son un conjunto de elementos que Google considera inherentes a la UX de una página web. También conocidos como actualización de la experiencia de la página, consisten en

- Facilidad para los móviles;

- Ausencia de ventanas emergentes intersticiales;

- Navegación segura (ausencia de malware en su página).

En resumen

Al final de este artículo, conviene recordar que el cambio de algoritmo es el conjunto de cambios importantes que Google ha realizado en su algoritmo principal.

El motor de búsqueda está comprometido con la mejora continua y los diversos cambios que realiza en su algoritmo de búsqueda le permiten afinar los resultados de la búsqueda.

Estas grandes actualizaciones se centran en la mejora de la experiencia del usuario, en las penalizaciones por páginas de baja calidad y por spam, y en la compatibilidad con los dispositivos móviles.

Por lo tanto, las empresas que sueñan con que sus sitios web aparezcan en las SERP deben tratar de cumplir los requisitos de Google en cuanto a la experiencia del usuario, la creación de contenidos de calidad y la compatibilidad con los dispositivos móviles.

Aplicando las diferentes estrategias comentadas en este artículo, podrá mantener su lugar en las SERPs y anticiparse a futuras actualizaciones.

No dude en compartir su experiencia en los comentarios si su sitio ya se ha visto afectado alguna vez por las distintas actualizaciones de Google.