L’index désigne simplement la liste de toutes les pages web qui existent sur internet dont les moteurs de recherche ont connaissance et dans laquelle ils peuvent faire une section pour répondre aux requêtes des internautes.

Le but de n’importe quel propriétaire de site web est de voir apparaître ses pages sur les SERP lorsqu’une personne lance une requête liée au secteur du site.

Malheureusement, ce n’est pas toujours le cas en raison de l’absence de certaines pages dans l’index des moteurs de recherche.

Autrement dit, si Google n’a pas connaissance de votre page, elle ne pourra aucunement apparaître sur les SERP.

Et pour éviter cela, je vous invite à lire d’avantage cet article pour mieux saisir le concept de l’index des moteurs de recherche.

Chapitre 1 : Qu’est-ce que l’Index ?

Dans ce premier chapitre, nous allons aborder tous les éléments pouvant nous aider à comprendre le fond du terme Index.

1.1. Qu’est-ce que l’Index ?

Bien que nous venons de définir le terme en haut, ce que Google même nous offre comme explication en vaut la peine d’être cité :

‘’L’index Google est similaire à un index dans une bibliothèque, qui répertorie les informations sur tous les livres disponibles dans la bibliothèque. Cependant, au lieu de livres, l’index Google répertorie toutes les pages Web que Google connaît. Lorsque Google visite votre site, il détecte les pages nouvelles et mises à jour et met à jour l’index Google”.

En un mot, l’index Google est une liste de pages Web que le moteur de recherche a découvertes et stockées. Ainsi, lorsqu’une personne utilise Google pour rechercher quelque chose, les pages indexées peuvent être trouvées plus facilement.

Pour ce faire, Google examine divers facteurs, comme la fréquence de mise à jour de la page et les autres sites Web qui y renvoient.

En suite il commence l’indexation par trois différentes étapes :

- Découverte : Google découvre les URL en explorant le Web et en extrayant les liens des pages Web nouvellement découvertes. Ces pages peuvent être découvertes de plusieurs façons, par exemple en suivant les liens sur d’autres pages Web ou sitemaps, ou en regardant d’où viennent les liens entrants.;

- Crawling : Google dispose d’algorithmes de pointe qui lui permettent de déterminer les URL auxquelles il faut accorder plus d’importance. Ensuite, Googlebot visite les pages qui respectent les normes définies ;

- Indexation : Enfin, Google examine le contenu de la page en vérifiant s’il s’agit d’un contenu de qualité et unique. C’est là que Google retourne également les pages pour voir tous leurs différents éléments tels que la mise en page et le design, si tout semble bon, la page est indexée.

Même s’il s’agit d’une simplification, chacune de ces étapes comporte en fait des sous-étapes, ce sont les éléments les plus importants.

Une fois que votre page web a franchi ces étapes et qu’elle est indexée, elle peut être classée pour des requêtes pertinentes et être montrée aux utilisateurs, ce qui se traduira par un trafic organique important vers votre site web.

Même si la page est introuvable sur Google, elle peut toujours être indexée par un lien sur une autre page.

Une exception à cette règle serait le cas où vous empêcheriez intentionnellement Google de visiter votre page à l’aide de votre fichier robots.txt, ce qui l’empêcherait d’être explorée.

Comme Google ne sait pas de quoi traite votre page ou si les utilisateurs la trouveront pertinente, il ne pourra pas l’afficher et en conséquence, vous n’obtiendrez probablement pas beaucoup de trafic sur cette page.

1.2. Google indexe-t-il toutes les pages ?

En réalité, Google n’a pas pour objectif d’indexer toutes les pages web présentes sur Internet.Pour rester claire à ce sujet, John Mueller se prononce en ces mots :

‘’En ce qui concerne l’indexation, nous ne garantissons pas que nous indexerons toutes les pages du site Web. Et surtout pour les sites Web plus importants, il est vraiment normal que nous n’indexions pas tout. Cela peut être le cas où nous n’indexons peut-être que 1/10 d’un site Web parce que c’est un site Web très volumineux. On ne sait pas vraiment si ça vaut le coup d’indexer le reste’’.

Cela signifie que plus de pages indexées sur votre site Web équivaut à de meilleures performances de référencement, tout simplement.

1.3. Quels sont les indices de l’index ?

Ce sont les données sources de l’index de Google qui déterminent en fin de compte la valeur des différents termes de recherche et mots-clés.

Les moteurs de recherche appliquent leurs algorithmes aux données disponibles et mesurent la fréquence de différents facteurs dans différentes conditions.

L’index comprend non seulement les URL, mais aussi tout le contenu, y compris les textes, les images, les vidéos et tout ce qui se trouve dans le code HTML de l’URL.

Les informations recueillies à partir de cette analyse sont réintroduites dans l’algorithme de Google pour fournir une nouvelle évaluation des données de l’index, qui tente de comprendre le contenu qui correspond le mieux à l’intention de l’utilisateur.

Les résultats de recherche Google, ou classements, sont ensuite calculés sur la base de cette évaluation du contenu.

Dans ce processus voici quelques indicateurs importants :

1.3.1. Index des pays

Les plus grands moteurs de recherche comme couvre presque toutes les régions du monde entier, ainsi, ils dédie un index spécifique à chaque marché. Par exemple, l’index proposé par Google pour les États Unis (google.com) est complètement différent de l’index qu’il propose pour le Japon (google.co.jp), etc.

Grâce aux index par pays, le moteur de recherche peut fournir des résultats plus pertinents aux utilisateurs en fonction de leur localisation et de leur langue. Cela permet de créer une source d’information fiable qui correspond étroitement à ce que les utilisateurs du pays recherchent.

Une approche insuffisante consisterait à afficher les résultats sur la base d’un indice mondial intégrant les données de tous les marchés, mais il serait alors impossible de répondre aux besoins spécifiques des utilisateurs de chaque pays.

Les données de recherche pour chaque mot clé sont uniques à l’index national dont il provient. Sans ces données, les décisions relatives au référencement et au marketing de contenu ne peuvent pas être fondées sur le comportement réel des utilisateurs.

Bien que plusieurs entreprises mondiales aient des sites Web de premier plan dans plusieurs pays, comme le révèle notre classement SEO mondial, il peut être utile de connaître les différents facteurs de classement qui s’appliquent dans chaque pays.

1.3.2. Index locaux

Tout comme un index par pays, un index de moteur de recherche local regroupe les informations par région ou par ville.

Les utilisateurs qui recherchent des services ou des lieux locaux sont principalement intéressés par les résultats qui se rapportent à leur proximité.

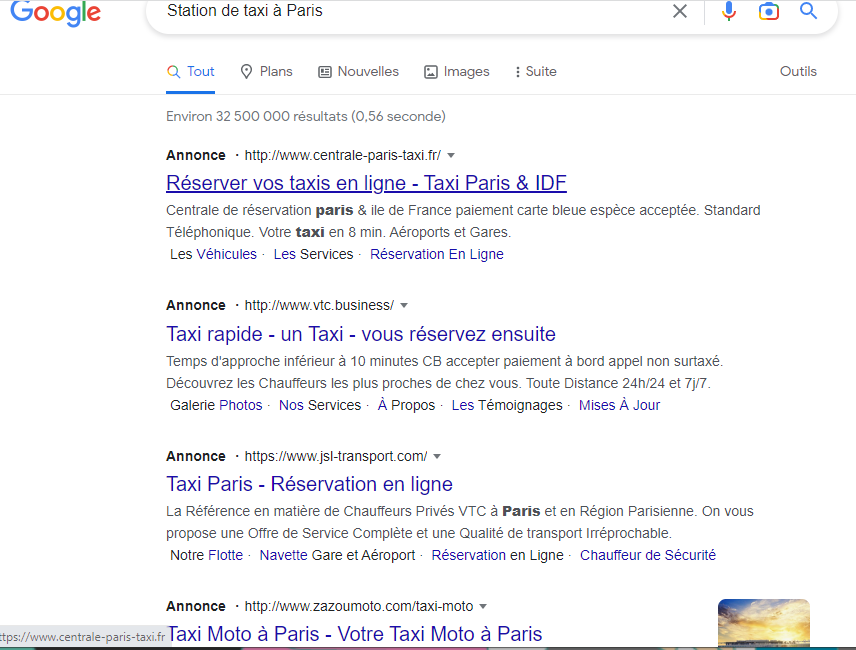

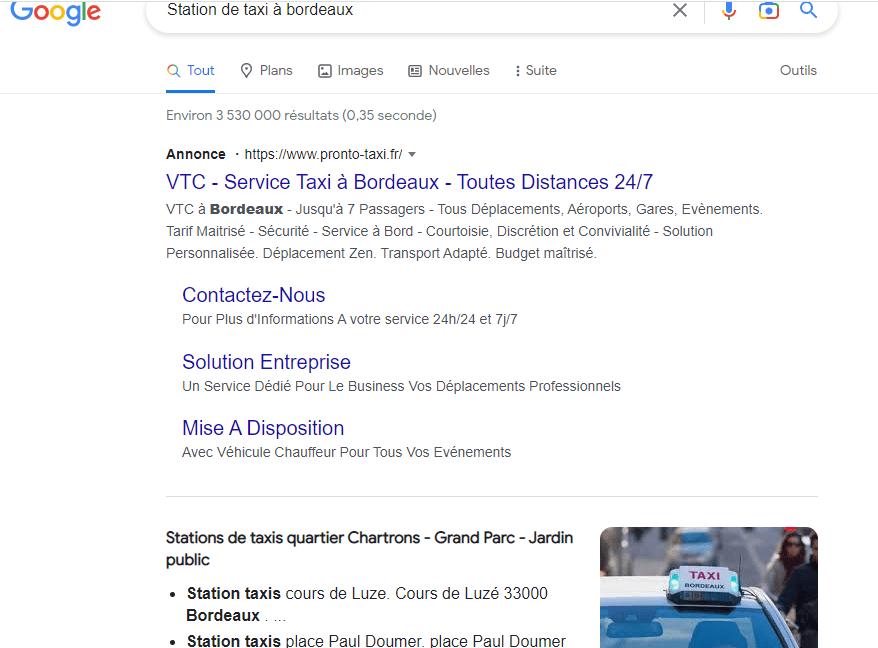

Un exemple de cela serait une requête de recherche comprenant « près de chez moi » ou quelque chose de similaire, comme « la station de taxi la plus proche », il est tout à fait évident qu’un habitant de Paris s’attendra à des résultats totalement différents de ceux d’un autre habitant de Bordeaux.

Même si on ne se situe pas dans les deux villes en même temps, lorsqu’on inclut le nom de chaque ville dans une requête, on peut voir que les résultats proposés par Google sont complètement différents les uns des autres.

1.3.3. Index mobile

Bien que les crawlers de bureau soient toujours utilisés par les moteurs de recherche, ils ne sont pas le seul moyen de collecter des informations.

La décision de savoir si les résultats mobiles seront affichés séparément des résultats de bureau, ou si ces derniers seront modifiés pour les appareils mobiles, est restée en débat. Toutefois, le webmaster de Google a annoncé en 2016 qu’il était prévu de passer à l’affichage de contenus principalement mobiles.

Dans ce cas, les informations essentielles que Google trouve proviendront des versions mobiles des sites Web exploités. Ainsi, l’index des ordinateurs de bureau est considéré comme un ajustement ou une adaptation.

Les récents développements de Google en matière d’indexation suggèrent que tout webmaster à la recherche d’un succès durable doit être conscient de la façon dont son site Web apparaît à la fois sur les ordinateurs de bureau et sur les appareils mobiles.

Bien que l’on ne sache pas exactement ce que cette nouvelle méthode d’indexation signifiera pour les sites Web dont les pages de bureau contiennent du contenu long et les pages mobiles du contenu court, Google va certainement dans cette direction.

Chapitre 2 : Quels sont les défis de l’index ?

L’indexation des moteurs de recherche présentent plusieurs défis aujourd’hui à savoir :

2.1. Le volume des pages des sites web

Le premier défi de l’indexation est que le web se développe à une vitesse exponentielle et il est de plus en plus difficile de se démarquer.

En mars 2021, WorldWideWebSize a révélé après des analyses qu’il y avait plus de 5 milliards de pages sur Internet.

La majorité de ces pages n’ont aucune valeur pour les utilisateurs de Google car elles sont remplies de spam, de contenu dupliqué et de pages nuisibles contenant des logiciels malveillants et du contenu de phishing.

Heureusement, Google a appris, avec le temps, à éviter d’indexer ces pages en les explorant moins que possible.

Par ailleurs, les sites web se concentrent de plus en plus sur les images et les vidéos de haute qualité, ce qui est souvent difficile à indexer.

Même si cela offre de nouvelles expériences aux utilisateurs de Google, il est un peu difficile pour le moteur de recherche d’utiliser beaucoup de ressources pour comprendre le contenu de ces pages qui sont chargées en code et en médias.

Avec tout ce qui se passe dans sur Internet, Google ne peut que devenir plus strict avec ses directives en matière de contenu.

2.2. La sélection d’index

Internet devient de plus en plus vaste que Google ne peut pas tout indexer. Par conséquent, il doit être sélectif quant aux pages qu’il explore et ajoute à sa base de données.

Google souhaite se concentrer sur les pages de qualité, c’est pourquoi ses ingénieurs ont mis au point des moyens d’empêcher l’exploration des pages de mauvaise qualité. Par conséquent, Google peut décider de ne pas explorer certaines de vos pages s’il juge qu’elles sont de mauvaise qualité en se basant sur les autres contenus que vous avez publiés.

Dans ce scénario, vos pages abandonnent le pipeline d’indexation dès le début.

‘’Nous essayons de reconnaître le contenu dupliqué à différentes étapes de notre pipeline. D’une part, nous essayons de le faire lorsque nous examinons le contenu. C’est un peu comme après l’indexation, nous voyons que certaines pages sont identiques, nous pouvons donc les plier ensemble. Mais nous le faisons aussi, essentiellement, avant d’explorer, où nous regardons les URL que nous voyons, et sur la base des informations que nous avons du passé, nous pensons, probablement ces URL pourraient finir par être les mêmes, et puis nous les plions ensemble’’.

Même les données que nous abstenons de Google Search Console confirment que cela se produit très souvent. Appelé ‘’Découvert, actuellement non indexé’’, ce problème est l’un des plus courants que nous observons et il est généralement causé par :

- Une qualité de page médiocre : Google a détecté un modèle commun et a décidé de ne pas gaspiller de ressources en explorant du contenu de mauvaise qualité ou en double ;

- L’insuffisance du budget d’exploration : Google a trop d’URL pour les explorer et les traiter toutes. Face à cela, son budget est limité.

2.3. Le marché de la recherche en constante évolution

Comme tout autre marché économique, le marché de la recherche est en constante évolution. Cela signifie que si les moteurs de recherche veulent donner aux utilisateurs les informations les plus précises pour leurs recherches, ils doivent continuer à indexer et réindexer les données pour être sûr de ce qu’ils proposent.

Pour s’assurer que les utilisateurs puissent trouver les informations les plus récentes, les moteurs de recherche mettent régulièrement à jour leurs index de sites web et de contenus.

Bien qu’une nouvelle page Web puisse suivre tous les conseils en matière de référencement et de marketing de contenu, cela ne garantit pas que Google la classera. Le plus souvent, le problème réside dans le système d’indexation du moteur de recherche.

Le moteur n’affiche que les pages qui sont incluses dans sa base de données en réponse aux requêtes.

2.4. Spécifications techniques pour l’inclusion dans l’index

Si un site web n’est pas dans l’index, il devient sans valeur et ne sera jamais affiché dans les résultats de recherche.

Si vous souhaitez que vos pages soient explorées par Google et d’autres moteurs de recherche, il est essentiel de comprendre le fonctionnement de ces robots. Cela signifie que les pages de votre site Web doivent être faciles d’accès pour le robot d’exploration et que tout le contenu de ces pages doit pouvoir être affiché sans difficulté.

En outre, toutes les URL de votre domaine doivent pouvoir être incluses dans l’index correspondant.

Chapitre 3 : Comment pouvez-vous assurer que Google indexe toutes vos pages ?

Voici, dans ce chapitre, quelques tactiques pour aider les moteurs de recherche à accéder facilement à vos pages web :

3.1. Vérifiez les paramètres pour la visibilité de votre site pour les moteurs de recherche

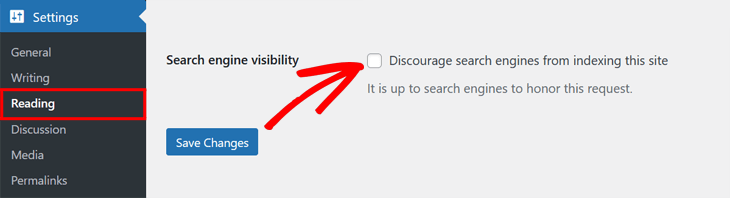

Avant tout, vous êtes appelés à vérifier si votre site web entier est visible pour les moteurs de recherche.

Si vous utilisez WordPresse comme système de gestion de contenu, vous pouvez vérifier l’accessibilité de votre site web pour les moteurs de recherche en accédant au ‘’Paramettres’’ sur le tableau de l’administration de votre site WordPress.

Une fois dans le paramètre, vous devez faire défiler la page jusqu’à l’option ‘’Visibilité des moteurs de recherche’’.

Pour que les moteurs de recherche puissent indexer et explorer votre site web, vous devez avoir la case de ce paramètre coché.

En revanche, si vous utilisez un système de gestion de contenu qui ne propose pas cette option de paramétrage, il existe plusieurs autres moyen pour vérifier l’indexabilité de votre site web :

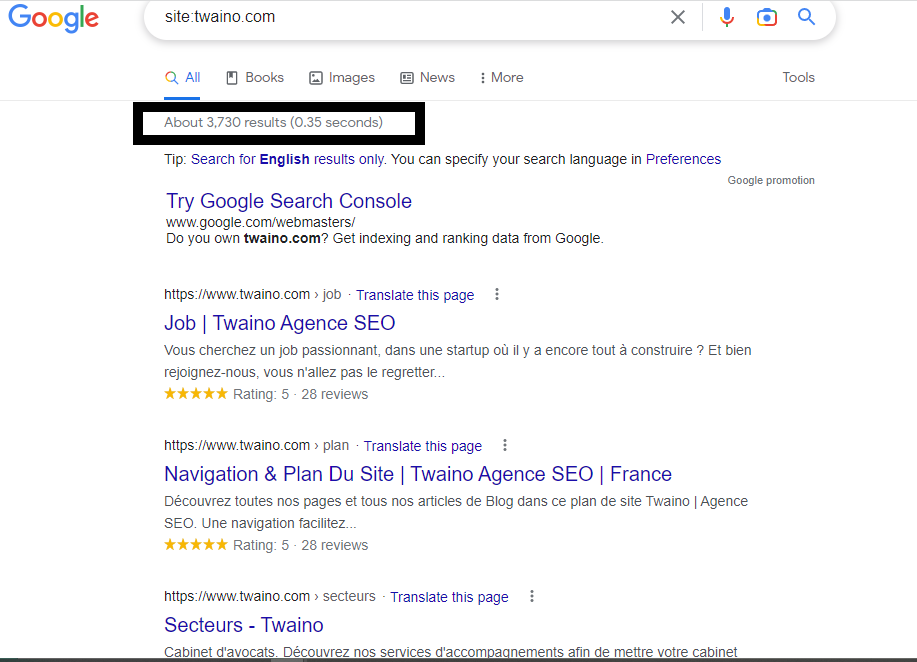

3.1.1. L’utilisation de la commande ‘’site’’

Un moyen rapide de vérifier le nombre de pages de votre site web qui sont indexées par Google est d’utiliser l’opérateur de recherche ‘’site:exemple.com’’ dans Google, en remplaçant ‘’exemple’’ par votre nom de domaine.

Bien que le statut d’indexation d’un site Web puisse être vérifié à l’aide de cette méthode, les données peuvent être inexactes, car il ne s’agit que d’une estimation. Cette méthode est particulièrement insuffisante lorsque le contenu de votre site change régulièrement.

Souvent, les résultats indiqueront un nombre différent de pages indexées à chaque fois que vous utiliserez cette méthode.

Si vous ne trouvez pas la commande ‘’site:domain’’ assez satisfaisante, vous pouvez essayer d’utiliser la commande ‘’site:URL’’ à la place. De cette façon, vous serez en mesure de savoir si une URL spécifique a été indexée ou non.

3.1.2. Outils dans la console de recherche Google

La Google Search Console fournit une suite complète d’outils qui peuvent s’avérer très utiles pour votre stratégie de couverture d’index.

Autrement dit, plusieurs fonctionnalités de Google Search Consol vous permettent de vérifier facilement l’état de votre site web dans les moteurs de recherche.

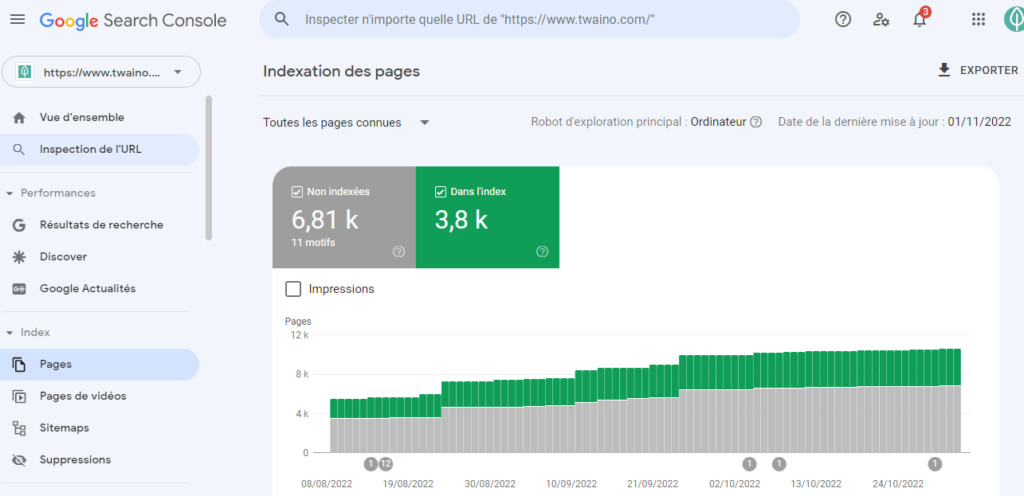

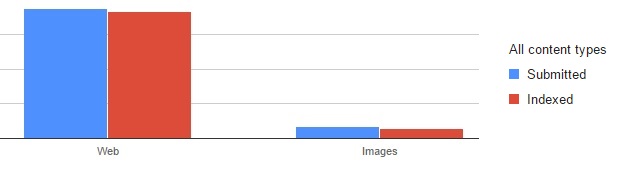

3.1.2.1. Le rapport de couverture de l’index (indexation des pages)

Il s’agit d’un rapport dans Google Search Console qui vous donne une idée des pages qui peuvent être facilement indexées, ainsi que des statuts de la progression de vos URL.

S’il y a des problèmes qui empêchent l’indexation des URL, ils apparaîtront également ici.

Comme on peut le voir, le rapport Index Coverage nous montre deux catégories de d’url sur le site web.

- Non indexé : Cette catégorie regroupe les pages que le moteur de recherche n’arrive pas à indexer pour plusieurs raisons. Ces pages peuvent afficher des erreurs, comme un code d’état HTTP de 5xx, une directive d’interdiction qui n’est pas répertoriée correctement dans le fichier robots.txt ou l’utilisation de la balise noindex sans instructions appropriées. Google peut décider de ne pas indexer une page pour un certain nombre de raisons, même si la page était disponible pour être explorée ;

- Indexé : Les pages de cette catégorie sont généralement celles que les moteurs de recherche indexent sans aucun problème. Certaines d’entre elles peuvent présenter des problèmes mineurs que vous devriez vérifier, mais rien de majeur n’empêche leur indexation.

Dans le coin supérieur gauche, vous pouvez sélectionner les données que vous souhaitez afficher :

- Toutes les pages connues : Il s’agit ici des URLs que le moteur de recherche a trouvé par n’importe quel manière ;

- Toutes les pages soumises : Ici, on trouve des pages que que le moteur de recherche a trouvé dans votre sitemap ;

- Pages non soumises uniquement : Il s’agit ici des pages qui ne sont pas incluses dans le sitemap, mais que le moteur de recherche a découvert lors de l’exploration.

Si certaines pages apparaissent dans ‘’Pages non soumises uniquement’’ et que vous souhaitez que Google les indexe, ajoutez-les à votre sitemap. Si vous ne souhaitez pas que Google indexe ces mêmes pages, Google peut les trouver ailleurs sur Internet, très probablement par le biais de liens.

Le rapport comporte un maximum de 1 000 pages par affichage de problèmes spécifiques. Toutefois, il existe des moyens de contourner ce problème, par exemple en créant des propriétés de domaine distinctes pour les différentes sections du site Web.

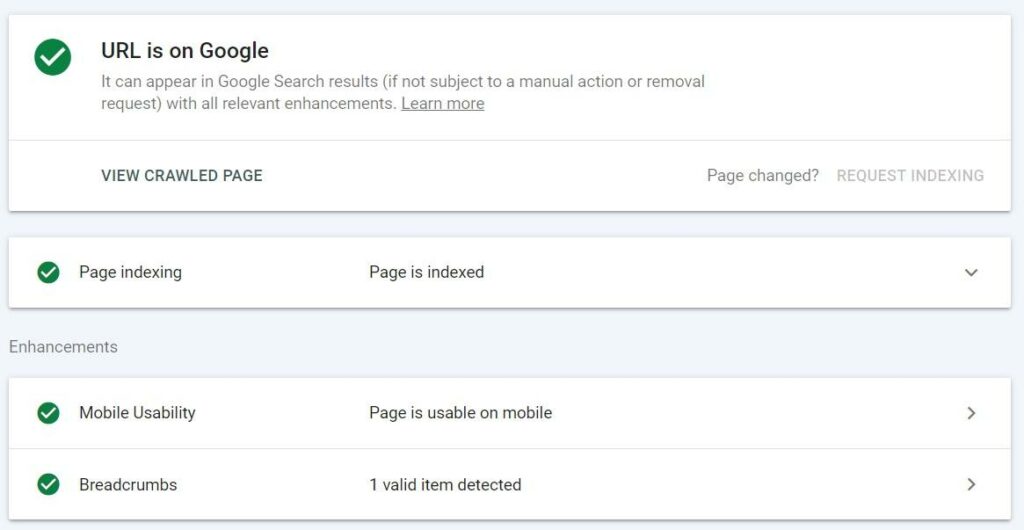

3.1.2.2. Outil d’inspection d’URL

L’outil d’inspection des URL disponible dans la Google Search Console est un autre excellent moyen de vérifier si les pages de votre site Web sont indexées par Google.

Lorsque vous exécutez cette fonctionnalité, elle vous présente de précieuses données comme :

- Le statut de présence : Le statut de présence d’une URL détermine si elle peut apparaître dans les résultats de recherche de Google. En outre, tout avertissement ou erreur détecté par Google sera également affiché ici ;

- Affichage de la page explorée : Cette option permet aux utilisateurs de voir le code HTML et la réponse HTTP que Google a reçus lors de sa dernière visite de la page ;

- Demande de l’indexation : Cette fonctionnalité vous permet de demander à Google de réexplorer et de réindexer votre URL. Bien qu’elle ne soit pas explicitement mentionnée dans la documentation de Google, elle est mentionnée comme un moyen de soumettre « quelques URL seulement ». Avec cette méthode, vous pouvez soumettre jusqu’à 50 URL par jour ;

- Améliorations : La section « Améliorations » indique si Google a trouvé des données structurées valides sur la page, en plus de l’utilisabilité mobile et des détails AMP ;

- Tester l’URL en direct : Les tests d’URL en direct vous permettent de tester les URL en temps réel afin de valider les modifications ou les correctifs.

L’outil d’inspection des URL peut vous aider à vérifier si votre site Web est indexé, mais cela peut prendre un certain temps en fonction du nombre de pages que vous avez. Si vous souhaitez faire une évaluation plus rapide, essayez plutôt d’échantillonner certaines de vos pages pour avoir une idée des problèmes que rencontre votre site.

Vous pouvez améliorer le classement de votre site Web en inspectant à la fois les URL qui ont été exclues de l’index de Google et celles qui devraient être indexées mais qui ne reçoivent pas de trafic organique.

3.1.2.3. API d’inspection d’URL

L’API d’inspection des URL a été la réponse de Google en 2022 aux personnes qui trouvaient les données de l’outil d’inspection des URL utiles mais ne pouvaient vérifier qu’une seule URL à la fois. L’API d’inspection des URL de Google vous permet de collecter des données pour un maximum de 2 000 requêtes par jour pour une seule propriété de Google Search Console à partir de 2022.

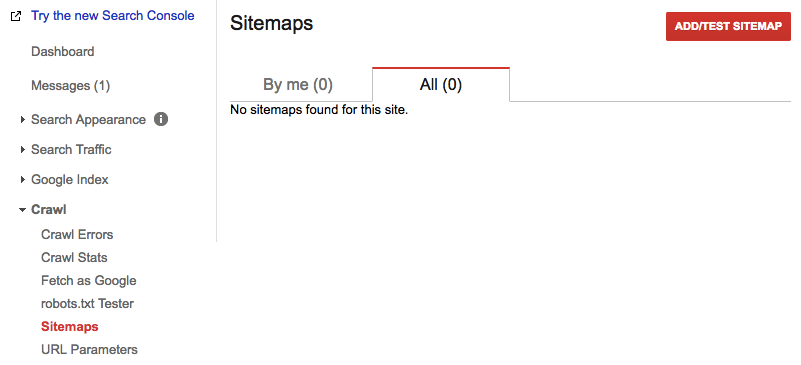

3.2. Créez un siteMap

Le sitemap, comme son nom l’indique, est une carte de votre site Web qui indique aux robots d’exploration les pages accessibles et indexables de votre site web.

Autrement dit, les sitemaps XML sont créés afin de communiquer efficacement avec ces robots.

Ils ont pour objectif de s’assurer que toutes les pages de grande valeur soient explorées et facilitent la recherche de nouveaux contenus.

La création d’un sitemap efficace est cruciale pour une indexation réussie.

Si vous n’avez pas de plan de site, Google peut mettre jusqu’à 24 heures pour indexer votre nouvel article de blog ou votre site Web.

Lorsque vous disposez d’un plan de site, toutefois, vous pouvez réduire ce délai de manière significative, à quelques minutes seulement.

Heureusement, il existe plusieurs outils pour créer un sitemap pour votre site web :

Le moyen le plus rapide et le plus efficace de créer un sitemap XML est d’utiliser l’outil SEO Spider de Screaming Frog.

Pour les sites de moins de 500 pages, le téléchargement de cet outil pour créer un sitemap est entièrement gratuit. Mais, si votre site contient plus de 500 pages, vous devrez penser à acheter une licence.

Google XML Sitemaps est un plugin gratuit pour les sites WordPress qui offre un moyen facile de générer des sitemaps personnalisés, tout comme ceux que vous pouvez créer avec Screaming Frog.

Après avoir défini vos préférences, vous obtiendrez votre plan de site sous forme de http://votredomaine.com/sitemap.xml.

3.3. Soumettez votre sitemap à Google Search Console

La soumission de votre sitemap à Search Console permet à Google de trouver toutes les pages que vous souhaitez indexer, ce qui est essentiel pour aider ses robots à identifier votre contenu le plus important.

Pour le faire, vous allez vous rendre sur la page d’accueil de votre Google search Console pour choisir le domaine que vous souhaitez utiliser.

Une fois que cela est fait, vous pouvez configurer votre sitemap, grâce aux options dans la barre latérale gauche, avant de le soumettre à Google.

Généralement, l’URL de votre sitemap se présente sous forme de http://yoururl.com/sitemap.xml.

Une fois que votre sitemap est validé, vous pouvez désormais connaître le nombre de pages que vous avez soumises par rapport à la quantité indexée par Google.

De cette façon, vous aurez un contrôle parfait de la quantité d’informations sur votre site que Google a conservées.

Il est essentiel de comprendre qu’un plan de site ne doit pas être créé puis oublié. Au fur et à mesure que vous ajoutez des pages et que vous modifiez votre site, celui-ci évolue, et votre sitemap doit également évoluer. En tenant Google au courant des modifications apportées à votre site, il peut l’explorer et l’indexer plus efficacement.

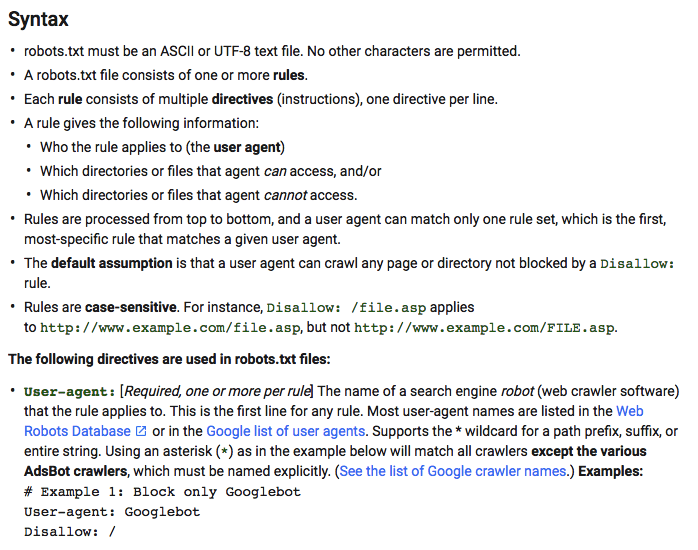

3.4. Créez un fichier robots.txt

Le nom « robots.txt » peut sembler technique et compliqué, mais ce fichier est en fait assez facile à comprendre.

Pour qu’un moteur de recherche puisse inclure votre site Web dans ses pages de résultats, vous devez d’abord disposer d’un fichier robots.txt qui indique au robot d’exploration le contenu à indexer et celui à ne pas inclure.

Ce document fournit essentiellement une liste de commandes qui indiquent à l’araignée où elle peut et ne peut pas aller sur votre site. Sans ce fichier, l’araignée passera simplement sur un autre site web.

Google parcourt votre site Web en suivant les instructions définies dans votre fichier robots.txt. Par défaut, cela permet à Google d’indexer tout le contenu de votre site.

Néanmoins, si vous avez des pages ou du contenu que vous ne voulez pas voir apparaître dans les résultats de recherche, vous pouvez les bloquer à l’aide de ce fichier.

D’ailleurs Google même l’a bien précisé, ‘’Nous proposons des outils pour les webmasters afin de donner aux propriétaires de sites des choix précis sur la façon dont Google explore leur site : ils peuvent fournir des instructions détaillées sur la façon de traiter les pages de leurs sites, peuvent demander une nouvelle exploration ou peuvent désactiver complètement l’exploration à l’aide d’un fichier appelé « robots.txt ».

Surtout lorsque vous avez plus de pages sur votre site web, le fichier robots.txt optimise l’indexation de votre site web en dictant les pages qui peuvent être indexées et en améliorant le contrôle.

Les fichiers Robots.txt sont des documents texte de base qui peuvent être facilement créés à l’aide de n’importe quel éditeur de texte brut, comme Notepad (pour Windows) ou TextEdit pour Mac. N’utilisez pas des programmes comme Microsoft Word, car ils ajoutent un formatage supplémentaire qui faussera votre fichier.

Si vous partez de zéro, la création d’un fichier robots.txt est facile, même si vous n’avez aucune expérience préalable. Une fois que vous avez terminé, stockez-le dans votre dossier racine sous forme http://votredomaine.com/robots.txt.

Cependant, avant de commencer le processus, vérifiez votre FTP pour voir si un tel fichier existe déjà, si c’est le cas, le télécharger et le réviser si nécessaire sera plus rapide que d’en créer un à partir de zéro.

Google propose un guide simple pour détailler tout le processus.

Les sites Web sont constamment explorés et indexés par les moteurs de recherche, mais vous pouvez aussi encourager accélérer ce processus en utilisant des liens internes.

En incluant des liens dans vos pages, vous aidez les bots à trouver plus facilement tout le contenu de votre site.

Un site Web bien conçu doit s’identifier par la façon dont les web les plus importantes sont liées entre elles.

Bien qu’elle soit souvent négligée, la structure de votre site Web peut en fait avoir une influence considérable sur différents aspects de votre référencement :

3.5. Assurez l’expérience utilisateur

Si vous voulez que les utilisateurs passent un moment agréable sur votre site Web, concevez une hiérarchie et un système de navigation clairs. Ainsi, chacun saura où se trouve chaque élément et pourra trouver ce qu’il cherche plus facilement.

Lorsque vous n’avez pas beaucoup de contenu sur votre site, il est vital de maintenir une structure de site simple. Bien que les méga-menus sophistiqués puissent être visuellement attrayants, ils ne sont pas nécessaires.

Il est préférable d’utiliser une mise en page simple et directe qui montre rapidement aux utilisateurs où cliquer pour trouver les informations dont ils ont besoin, cela en vaut de même pour les moteurs de recherche.

- Crawlers

Non seulement une architecture de site bien conçue facilite la navigation de vos utilisateurs, mais elle permet également aux robots d’exploration du Web d’accéder à votre contenu et de l’indexer plus efficacement.

En établissant une hiérarchie entre vos pages, vous aidez les robots d’exploration à comprendre les pages les plus importantes et comment elles sont liées les unes aux autres.

Les liens entre vos pages sont la meilleure façon d’aider les robots d’exploration à trouver vos nouveaux contenus. Toutes les pages devraient avoir quelques liens internes chacune afin que le processus d’exploration soit plus efficace.

- Pages du centre de contenu

Si votre site Web contient beaucoup de contenu, vous pouvez créer des « pages du centre de contenu » comme moyen efficace pour les utilisateurs et les moteurs de recherche de naviguer plus efficacement sur votre site.

Il existe plusieurs façons de structurer les contenus avec de nombreuses pages de contenu type de pages, mais les pages centrales servent essentiellement d’index pour des sujets spécifiques liés aux informations de l’ensemble de votre site Web.

Il est ainsi plus facile pour les internautes de trouver les produits ou services qu’ils recherchent, sans avoir à passer en revue tout le reste.

Cela permet d’augmenter les taux de conversion et de générer davantage de pistes et de ventes à partir du trafic organique entrant sur le site

Les pages hub regroupent généralement :

- Des contenu de blog sur des sujets similaires ;

- Des produits similaires, si vous gérez un site de commerce électronique ;

- Les contenus d’actualité connexes, si vous gérez un site éditorial ;

- Etc.

Google utilise ces pages pour déterminer la pertinence des pages individuelles et leur lien avec les autres pages de votre site. En outre, du point de vue de l’utilisateur, cela simplifie la recherche de contenu supplémentaire lié à la page qui l’intéresse.

Conclusion

Pour résumer, l’index des moteurs de recherche ne regroupe que les pages web qui sont facilement accessibles. En plus de l’accessibilité l’index se base sur plusieurs autres facteurs comme région et version de page pour afficher des résultats. Et pour vous assurer que vos pages répondent à toutes ces exigences, nous avons fourni dans cet article quelques astuces que vous pouvez pratiquer.

Merci le contenu de ce site web est très instructif.

Merci c’est gentil Aymar. 🙂