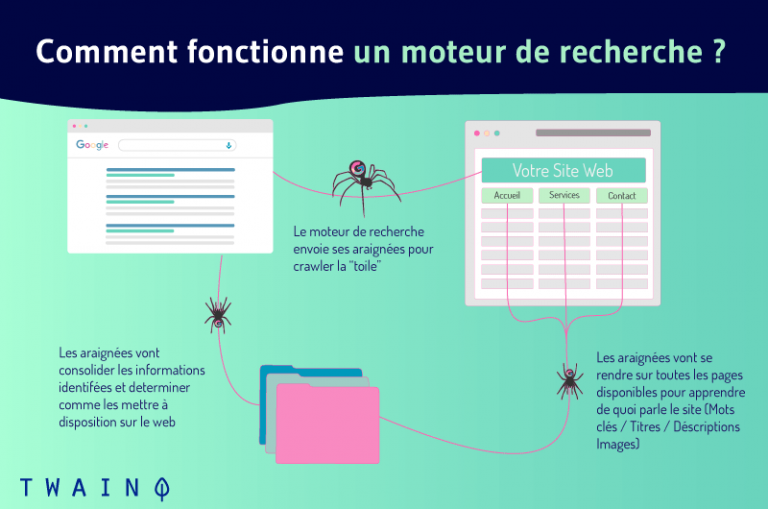

Um rastejador ou robô (também conhecido como “crawlers”, “aranhas”, ou “web spiders”) é um programa automatizado para navegar metodicamente na rede com o único propósito de indexar páginas da web e seu conteúdo. Esses robôs são usados por motores de busca para rastrear páginas da web a fim de renovar seu índice com novas informações. Assim, quando os internautas fazem um determinado pedido, eles podem encontrar fácil e rapidamente as informações mais relevantes.

Quando o senhor fizer uma pergunta em um mecanismo de busca, terá como resultado uma lista classificada de websites.

Antes que esses sites apareçam nos SERPs, um processo conhecido como rastejamento eindexação é feito nos bastidores pelos motores de busca

O ator principal no coração dessa maquinaria é o rastejador.

Neste caso :

- O que é um robô ou um rastejador?

- Como é que eles funcionam?

- Qual é a sua importância em SEO ?

- O que é indexação e que papel os robôs realmente desempenham?

- Qual é a diferença entre os rastejadores de teia e o raspador de teia?

Todas essas são perguntas cujas respostas nos permitirão compreender claramente a definição de rastejador e tudo o que o rodeia.

Vamos!

Capítulo 1: O que realmente queremos dizer com Crawler ou crawler?

Unidades funcionais de motores de busca, rastejadores ou robôs estão no centro da grande maioria das ações e interações da rede

A compreensão da pesquisa na Internet requer claramente uma compreensão completa de seus conceitos

Assim, neste capítulo, explicarei em grande detalhe os robôs ou rastejadores.

1.1. Um Rastejador: O que é isso?

Antes de discutir o rastejador em seu funcionamento e aplicações, é essencial recordar suas origens e dar seu verdadeiro significado.

Dito isto, aqui está a história e depois o verdadeiro significado do rastejador.

1.1.1. Rastejadores ou robôs de indexação desde o advento da web

Os robôs de indexação são agora conhecidos por muitos nomes

- Crawler ;

- Bots de rastejadores ;

- Aranhas ;

- Aranha da teia ;

- Software dos motores de busca;

- E muitos outros nomes.

Originalmente, o primeiro rastejador foi chamado WWW Wanderer (abreviação de World Wild Web Wanderer)

Esse robô de indexação, projetado e baseado no Perl (uma linguagem de programação estável e transversal), foi incumbido de avaliar a expansão da Internet, que ainda estava em sua infância, em junho de 1993

Na época, o robô Wanderer da WWW estava vasculhando a Internet em busca de dados que registrou no índice do dia, o primeiro índice da Internet: oíndice Wandex

Em seus primórdios, Wanderer só se arrastava por servidores web. Pouco depois de sua introdução completa, começou então a rastrear URLs.

Ao contrário do que se poderia pensar, Wanderer com seu índice Wandex não foi o primeiro motor de busca na Internet. Foi, na verdade, o mecanismo de busca arcaico desenvolvido por Alan Emtage

No entanto, com seu índice Wandex, Wanderer era definitivamente o que mais se aproximava de um motor de busca de uso geral, como os atuais motores de busca Google e Bing.

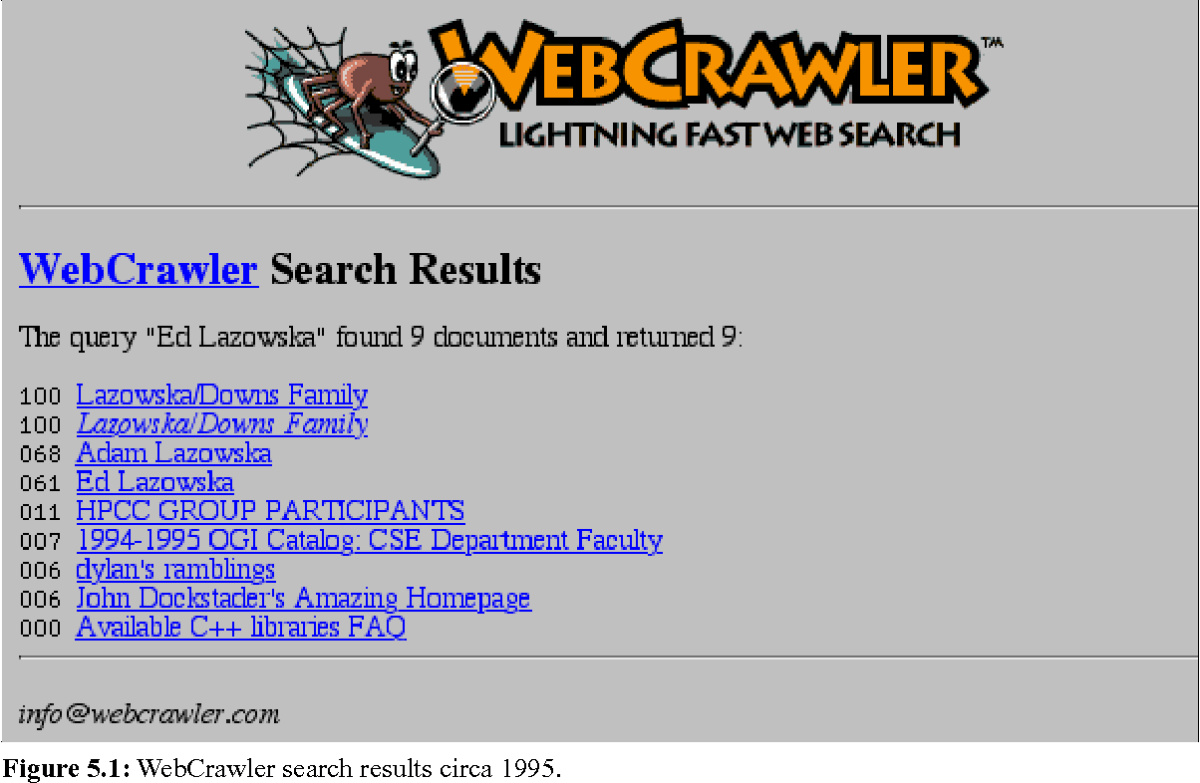

Após a WWW Wanderer, em 1994, apareceu o primeiro web browser: o Webcrawler. Hoje, é o mais antigo motor de busca (motor de metabusca) ainda presente e funcional na Internet.

Na constante evolução da rede, muitas melhorias foram feitas e os motores de busca e seus robôs de indexação mudaram e melhoraram.

A história das buscas na Internet e dos rastreadores da web acaba de ser assim delineada.

No entanto, qual é o verdadeiro significado da palavra “rastejador”?

1.1.2. Um Rastejador: O que isso realmente significa?

Com o nome do mecanismo de busca mais antigo existente (Webcrawler), crawler é uma palavra inglesa que literalmente significa “rastejar”, “rastejar”, “escanear”… Tantas correspondências oportunas que expressam claramente a própria essência da indexação de robôs

Com o risco de nos repetirmos, um robô de indexação é um programa de computador, um programa de software que escaneia a Internet de maneira controlada, localizando e analisando páginas da Internet com um propósito específico

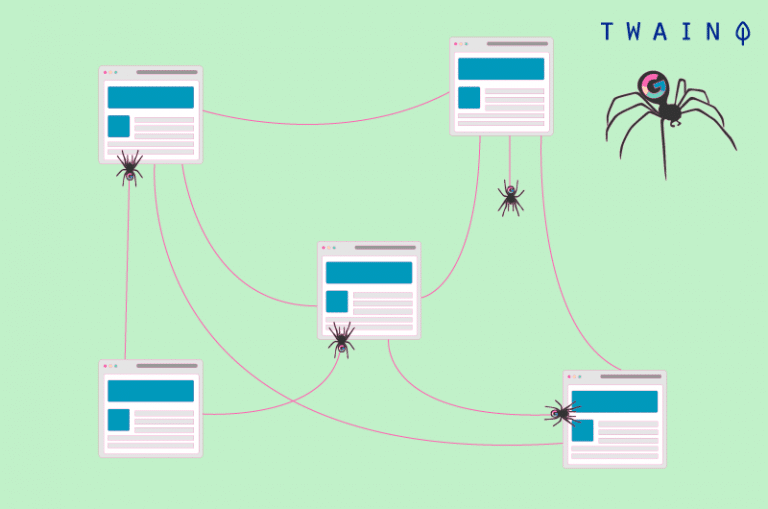

Como uma aranha com sua teia, o rastejador explora e analisa a teia. Essa análise diz respeito às diversas páginas da Internet, ao seu conteúdo e a todas as suas ramificações

O rastejador, em busca de dados, registrará e armazenará as diversas informações coletadas em índices e/ou bancos de dados

Portanto, é fácil compreender por que esses robôs também são chamados de aranhas ou aranhas da teia.

Esses robôs de indexação são, em 99% dos casos, ainda utilizados pelos motores de busca. Eles permitem aos motores de busca construir índices estruturados e otimizar seu desempenho como motores de busca (por exemplo, apresentação de novos resultados relevantes).

No 1% restante dos casos, os rastreadores são usados para pesquisar e coletar informações de contato e perfil (endereços de e-mail, feeds RSS e similares) para fins de marketing.

Em termos simples, tomemos o famoso exemplo do bibliotecário. Nesse exemplo, o motor de busca bot é um bibliotecário encarregado de fazer o inventário de todos os livros e documentos (websites e páginas) em uma enorme e completamente desorganizada biblioteca (a web).

O bot tem que criar uma tabela de resumo (índice do mecanismo de busca) que permita aos leitores (usuários da Internet) ter acesso rápido e fácil aos livros (informações) que estão procurando

Para ordenar e classificar (indexar) os livros (websites) por áreas de interesse e depois fazer um inventário, o bibliotecário (crawler) terá que pedir cada livro, seu título, seu resumo e o assunto de que trata

Mas, ao contrário de uma biblioteca, na Internet, os websites estão conectados entre si por hiperlinks, que são usados pelos bots para se moverem de um site ou página da Internet para outro.

Em suma, é isso que o rastejador é e pelo que é responsável. Tudo o que resta é saber como funciona.

1.2) Como funciona um robô de indexação ou um rastejador?

O rastejador é acima de tudo um programa, roteiros e algoritmos cujo conjunto de tarefas e comandos são definidos antecipadamente

Como um bom soldadinho, ele segue assiduamente as instruções e funções predefinidas em seu código, de maneira automática, contínua e repetitiva

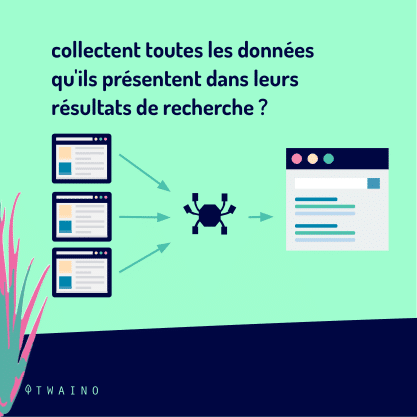

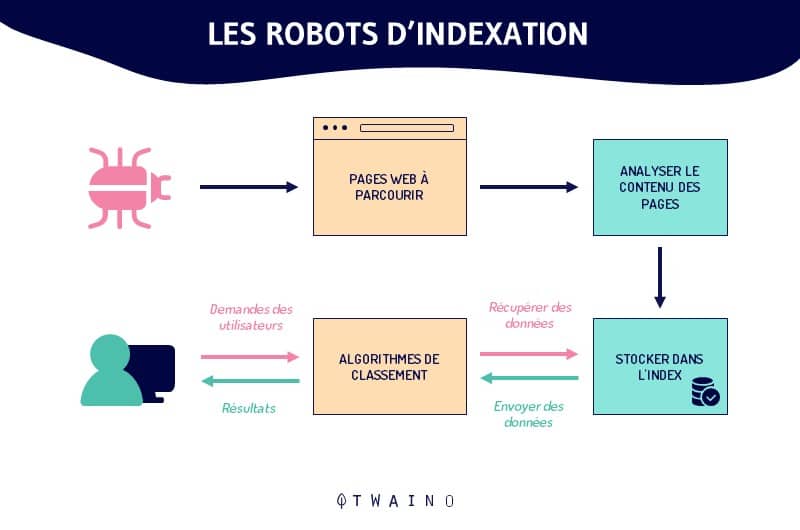

Ao navegar na rede através de hiperlinks (de sites existentes para novos), os spiders indexam tanto o conteúdo quanto as URLs. Eles analisam palavras-chave e hashtags e asseguram que o código HTML e os links dos sites indexados são recentes.

Como diz o famoso provérbio africano: “É no fim da corda velha que se tece a nova”

Como a rede está em constante crescimento, é impossível avaliar com precisão o número total de páginas na Internet

No desempenho de suas tarefas, os rastejadores começam a exploração a partir de uma lista de URLs conhecidos

Portanto, o rastejamento segue um padrão muito simples

URLs antigas conhecidas => páginas web indexadas => hyperlinks => novas URLs a serem rastreadas => páginas web a serem indexadas => assim por diante..

Longe de trabalharem aleatoriamente, os robôs de indexação obedecem a certas regras que lhes dão uma meticulosa seletividade na escolha das páginas a serem indexadas, bem como na ordem e freqüência da indexação dessas páginas.

Assim, um robô de indexação determina a página a ser indexada primeiro de acordo com

- O número de backlinks o número de backlinks que conduzem à página (o número de páginas externas às quais esta página está ligada);

- O link interno (os links entre as diferentes páginas de um mesmo site);

- Tráfico de páginas (o número de visitantes da página em questão);

- Elementos que atestam a qualidade, relevância e frescor das informações contidas na página (o Mapa do site, o meta-tagsmeta-tags, as URLs canônicass, etc.);

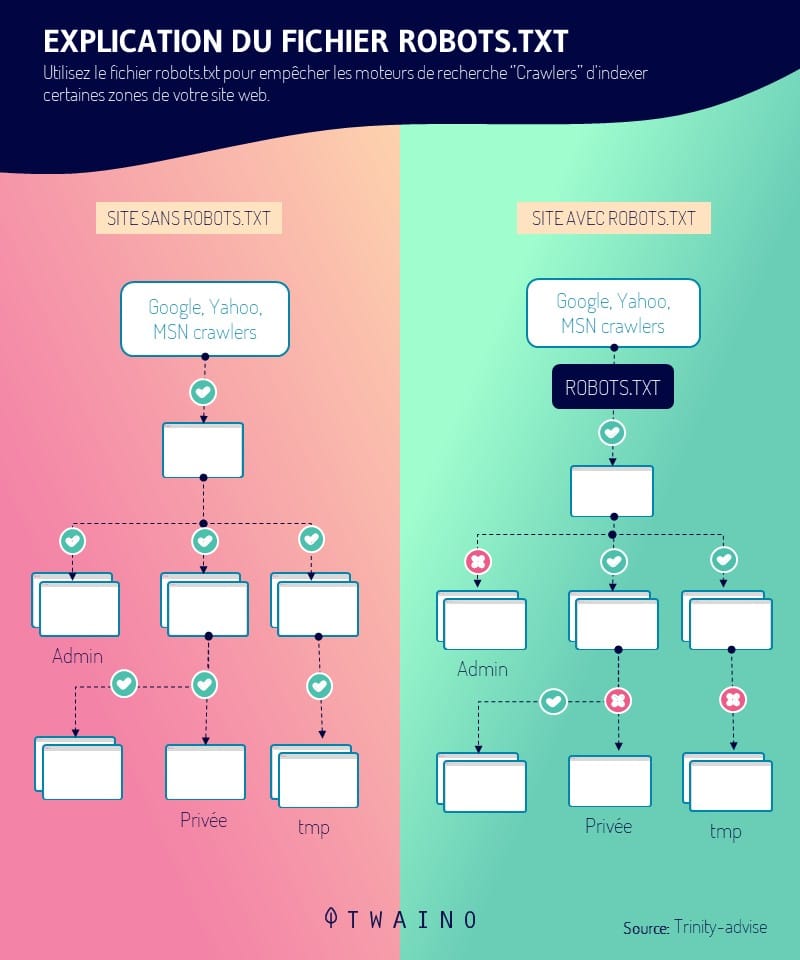

- O robôs.txt (o arquivo contendo os grupos de diretrizes para os bots) ;

- Etc.

Dependendo do mecanismo de busca, esses fatores são considerados de maneira diferente. É compreensível, portanto, que nem todos os motores de busca se comportem da mesma maneira.

1.3. Quais são os diferentes tipos de rastejadores?

Partilhando os mesmos princípios gerais de funcionamento, os rastejadores diferem principalmente em seu foco e alcance

Sim, além dos rastejadores de motores de busca, há muitas outras categorias de rastejadores.

1.3.1. Bots de motores de busca

Esses rastejadores são sem dúvida os primeiros rastejadores que já existiram

Eles são conhecidos como “searchbots”. Um nome justificado pelo fato de terem sido projetados com a intenção de servir aos motores de busca na otimização de seu campo de ação e, especialmente, de seu banco de dados.

Entre os mais famosos estão os seguintes barcos de busca:

- Googlebot do Google: o mais usado na rede e o que tem o índice mais rico;

- O Bingbot de Bingo motor de busca da Microsoft;

- Slurpbot do Yahoo;

- A Aranha Baidu do motor de busca chinês Baidu

- A garrafa Yandex de Yandexo motor de busca russo

- O DuckDuckBot de DuckDuckGo ;

- Facebot do Facebook ;

- Alexa Crawler da Amazônia ;

- E mais.

1.3.2. Rastejadores de mesa

Estes são mini rastejadores com funcionalidade muito limitada. Sua limitada área de competência é compensada por seu custo relativamente insignificante

São bots que podem ser executados diretamente de um laptop ou PC pessoal e só podem processar uma quantidade muito pequena de dados.

1.3.3. Rastejadores pessoais da web

Uma categoria de rastejadores projetados para empresas e que são usados, por exemplo, especificamente para fornecer informações sobre a freqüência do uso de certas hashtags/palavras-chave

Exemplos incluem:

- O VoilaBot da empresa de telecomunicações Orange

- O OmniExplorer_Bot da companhia OmniExplorer

- E muitos outros.

1.3.4. Rastejadores comerciais

Essas são soluções algorítmicas oferecidas com base em assinaturas a companhias que precisam pessoalmente de um rastejador. Os rastejadores atuam como ferramentas pagas que permitem às companhias economizar a enorme quantidade de tempo e dinheiro necessários para projetar seu próprio rastejador.

Exemplos de software de rastreamento pago incluem o seguinte:

- Botificar ;

- SEMRush ;

- Oncrawl ;

- Rastejamento profundo ;

- Etc

1.3.5. O site está na nuvem

A particularidade desses rastejadores do site reside no fato de que eles são capazes de armazenar os dados coletados na nuvem

Isso é uma grande vantagem sobre outros rastreadores que simplesmente armazenam as informações em servidores locais, baseados em taxas, de companhias de TI.

Além disso, o acesso aos dados e às ferramentas de análise é muito melhor. Chega de preocupações com a localização e a compatibilidade logística.

1.4. O que devemos lembrar sobre a indexação (Google) na busca na Internet?

A parte da rede que é acessível ao público e que na verdade é rastreada por robôs permanece indeterminada

Estima-se que apenas 40-70% da rede está indexada para busca, o que representa vários bilhões de URLs.

Se tomarmos o exemplo do bibliotecário acima, a ação de prospecção, classificação e catalogação dos livros (sites e páginas da Internet) da biblioteca representou a indexação da pesquisa na Internet.

Indexação é, portanto, um termo prático que designa todos os processos pelos quais o rastreador varredura, analisa, organiza e organiza as páginas dos websites antes de propô-los nos SERPs

É um aspecto decisivo do referenciamento naturalpois consiste na inserção e consideração de páginas da web no índice do motor de busca

Embora essa primeira etapa de referência orgânica seja decisiva, ela está longe de ser suficiente para o aparecimento e posicionamento de páginas da web nas SERPs.

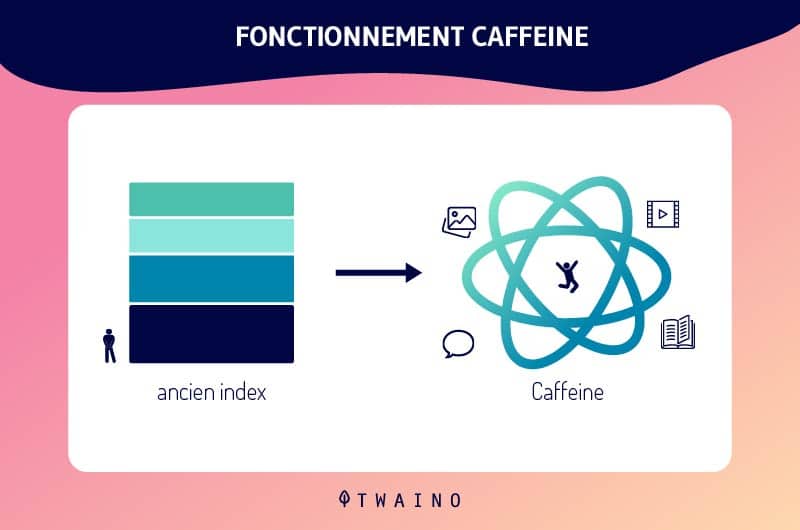

Graças às contínuas atualizações do índice Google, e especialmente com a implementação do Cafeínaa indexação do Google evoluiu mais

Como resultado, novos conteúdos e/ou novas páginas da web são prontamente indexadas e sua aparição nos SERPs é direta.

Tudo isso à parte, é crucial lembrar que as páginas e o conteúdo de seu site não serão indexados pelo Googlebot até que ele os tenha encontrado. Essa etapa crucial da indexação do Google é controlável.

Na verdade, há várias soluções para tornar seus recursos visíveis para o Google. O próprio mecanismo de busca oferece alternativas interessantes e eficientes sobre o assunto.

Capítulo 2: Um Crawler em aplicação: O que ele faz?

Agora que as introduções foram feitas, passemos à questão da mesquinhez do assunto.

Quais são as contribuições, vantagens e importância de SEO dos rastejadores?

2.1. Na prática, como funcionam os rastejadores?

Como vimos, o comportamento dos rastejadores é predefinido e integrado em suas linhas de código. Os fatores que regem a indexação das páginas da web são assim ponderados de acordo com os bots e de acordo com a boa vontade dos motores de busca.

Na prática, a ação dos bots de indexação é decidida em várias etapas.

Primeiro, os motores de busca precisam determinar o alvo e/ou as preferências desses bots. As políticas de rastreamento de websites, em particular os tipos de URLs a serem indexados, serão, portanto, especificadas na parte de dados que serve como salvaguarda chamada fronteira de rastreamento

Numa segunda etapa, os beneficiários dos rastejadores alocam uma lista de “sementes” para seus robôs, que servirá como ponto de partida para a indexação. Esta é uma série de URLs antigas conhecidas ou novas a serem rastreadas.

Em seguida, os motores de busca acrescentam ao programa dos robots a freqüência de exploração e processamento a ser dada a cada URL.

Finalmente, os rastreadores são treinados para respeitar as diretrizes do arquivo robots.txt e/ou as tags HTML nofollow, ao contrário dos spambots

Assim, o rastejador, de acordo com as diretrizes do robôs.txtprotocolo, será instruído a evitar a totalidade ou parte de um website.

2.2. Um robô de indexação: O que ele faz?

O rastejador em suas aplicações oferece várias vantagens em muitas áreas.

A primeira vantagem do rastejador é sua simplicidade de uso e sua capacidade de assegurar para assegurar a coleta e o processamento contínuo e completo dos dados.

Seu eficiência inigualável no desempenho de suas funções de exploração e indexação de conteúdo da web é também uma vantagem valiosa

Ao fazer a prospecção, análise e indexação da web em vez de humanos, os robôs economizam uma quantidade incrível de tempo e dinheiro.

Do ponto de vista de SEO (Search Engine Optimisation), o rastejador ajuda a aumentar o tráfego orgânico de um website e a se destacar da concorrência

Para isso, ele fornece informações sobre os termos de busca e palavras-chave mais populares.

Além dessas vantagens principais, os rastejadores também são úteis em muitas outras disciplinas, tais como

- Otimização do e-marketing através da análise da base de clientes da companhia;

- A prospecção de dados e a publicidade dirigida através da coleta de e-mails públicos e/ou endereços postais de empresas;

- Avaliação e análise dos dados dos clientes e da companhia com o objetivo de melhorar as estratégias de marketing da companhia;

- Criação de bancos de dados;

- A busca de vulnerabilidades através do monitoramento contínuo dos sistemas;

- E muitos outros.

Capítulo 3: Qual é a importância e o papel dos rastejadores na SEO?

O papel e a importância dos rastejadores na indexação não está mais em questão. No entanto, suas divisões e interesses na estratégia de SEO continuam um pouco obscuros até agora.

3.1. O lugar dos rastejadores na SEO

A importância dos rastejadores para o referenciamento natural está intimamente ligada à sua capacidade de estabelecer as condições necessárias para que um website apareça nas SERPs

O objetivo da SEO é obter um tráfego orgânico considerável gerado por resultados naturais.

Em outras palavras: estar entre os principais resultados dos motores de busca.

O rastreamento e a indexação das páginas da web por rastejadores é a base para aparecer nos resultados do mecanismo de busca. Na realidade, não basta aparecer nas SERPs, mas é um passo essencial.

3.como é que o web crawler ajuda os especialistas em SEO?

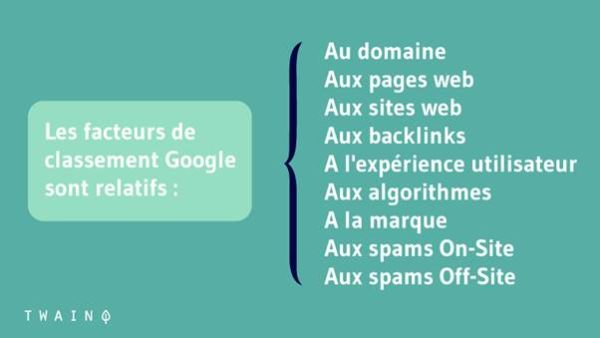

A otimização dos motores de busca visa melhorar a classificação de um website nos SERPs. Isso é feito através da otimização dos fatores técnicos e não técnicos da página para esses motores de busca.

As implicações de SEO do rastreador da web são enormes, pois é trabalho deles indexar seu site antes que os algoritmos determinem se ele merece um lugar na primeira página

Aqui estão duas (02) dicas para que possam indexar suas importantes páginas de maneira eficiente:

3.2.1. Ligação interna

Ao colocar novos backlinks e links internos adicionais, o profissional de SEO assegura que os rastejadores descubram as páginas da web a partir dos links extraídos para assegurar que todas as páginas do website acabem nas SERPs.

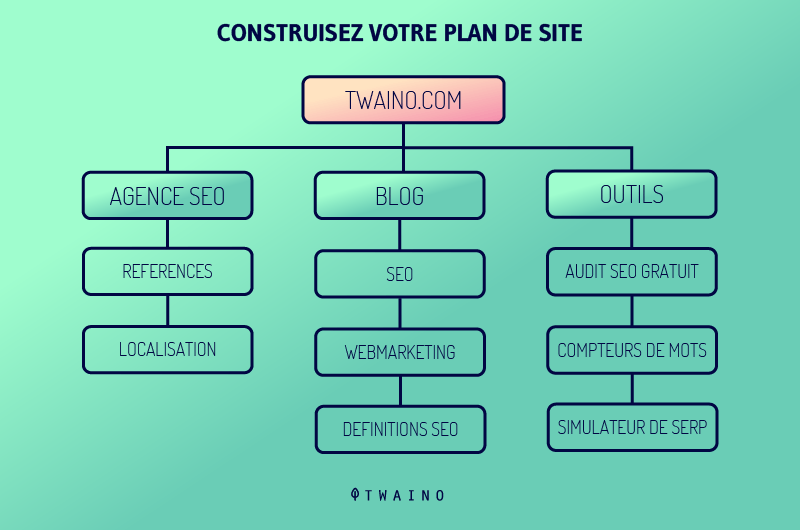

3.2.2. Envio do mapa do site

Criar sitesmaps e submetê-los aos motores de busca ajuda a SEO, pois esses sitesmaps contêm listas de páginas a serem rastejadas

Os rastejadores poderão facilmente descobrir o conteúdo escondido no fundo do site e rastreá-lo em pouco tempo, produzindo assim uma presença das páginas importantes do site nos resultados da busca.

3.3. Melhores práticas para melhorar sua SEO com rastejadores

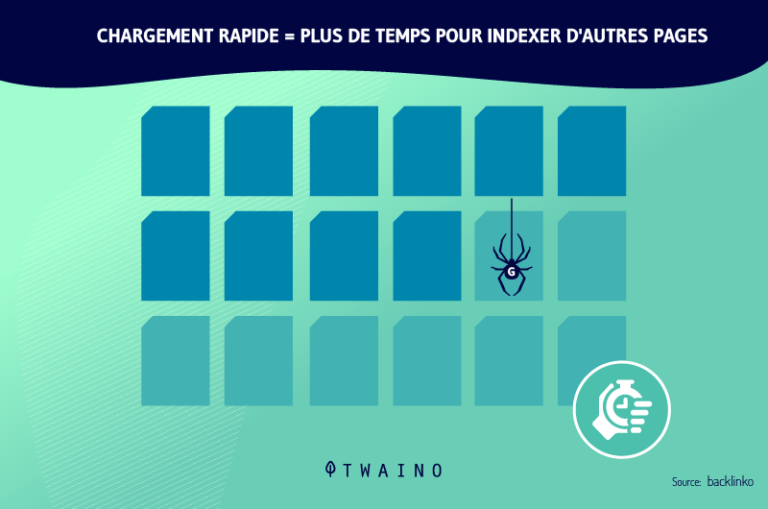

A otimização de sua estratégia de SEO envolve principalmente a otimização de seu orçamento de rastejamento (o orçamento de rastejamento ou exploração). Este é o período de tempo bem como o quantia de páginas da web que os rastejadores podem explorar e analisar para um website.

A otimização desse orçamento envolve a melhoria da navegação, arquitetura e aspectos técnicos do website. É aconselhável, portanto, adotar, entre outros, o as boas práticas melhores práticas:

- Enviar um mapa do site XML via GSC (Console de busca do Google). Esta é uma diretriz não-padrão em robôs.txtque orienta os rastejadores para páginas que devem ser rastejadas e indexadas primeiro.

- Faça um auditoria completa do site. O objetivo é melhorar fatores como as palavras-chave, a velocidade de carregamento das páginas do site, etc.

- Construir uma estratégia ótima de interligação líquida com backlinks e forte ligação interna. Por um lado, isso consiste em obter links de outros sites que já estão indexados e que têm uma alta freqüência de rastreamento. Por outro lado, trata-se de ligar inteligentemente as diferentes páginas do site para permitir que os rastejadores possam se mover facilmente de uma página para outra.

- Inspecionar URLs, conteúdo e código HTML com o objetivo de remover ou atualizar elementos obsoletos, supérfluos, questionáveis ou irrelevantes.

- Optar por meta-tags explícitas e relevantes, conteúdo de qualidade, URLs canônicos..

- Evite conteúdo duplicadoevitar duplicidade de conteúdo camuflagem e todas as práticas de BlackHat SEO.

- Assegure-se de que o servidor que hospeda o site seja acessível a pesquisadores.

- Identificar e corrigir os diversos elementos que bloqueiam a indexação das páginas da web.

- Esteja ciente das atualizações e mudanças nos algoritmos dos mecanismos de busca, para que o senhor esteja sempre ciente dos critérios atuais de SEO.

3.4. Outros usos de rastejadores além dos motores de busca

O Google começou a usar o rastreador da web para pesquisar e indexar conteúdo para facilmente descobrir websites por palavras-chave e frases

Os motores de busca e os sistemas de computador criaram seus próprios rastreadores de web programados com diferentes algoritmos. Estes rastejam a rede, analisam o conteúdo e criam uma cópia das páginas visitadas para posterior indexação

O resultado é visível, porque hoje o senhor pode encontrar facilmente todas as boas informações ou dados que existem na rede.

Podemos usar rastejadores para coletar tipos específicos de informações de páginas da web, tais como

- Revisões indexadas de um pedido de agregação de alimentos; Informações para pesquisa acadêmica

- Informações para pesquisas acadêmicas;

- Pesquisa de mercado para encontrar as tendências mais populares;

- Melhores serviços ou locais para uso pessoal;

- Empregos ou oportunidades corporativas;

- Etc.

Outros casos de uso para rastejadores incluem:

- Rastreamento de mudanças de conteúdo;

- Detecção de websites maliciosos;

- Recuperar automaticamente os preços dos websites dos concorrentes para a estratégia de preços;

- Identificação de potenciais bestsellers para uma plataforma de comércio eletrônico através do acesso a dados de concorrentes;

- Classificando a popularidade dos líderes ou estrelas de cinema;

- Acesso a dados alimentados por milhares de marcas similares;

- Indexação dos vínculos mais freqüentemente compartilhados nas redes sociais;

- Acesso e indexação das listas de empregos com base nas revisões e salários dos funcionários;

- Aferição de preços e catalogação do código postal para os varejistas;

- Acesso a dados de mercado e sociais para construir um mecanismo de recomendação financeira;

- Descobrindo salas de bate-papo relacionadas com o terrorismo;

- Etc.

Se o senhor sabe sobre Raspagem da webo senhor pode estar confundindo isso com a teia. Agora vamos ver a diferença:

3.5. Rastejador de Web contra raspador de Web: Comparação

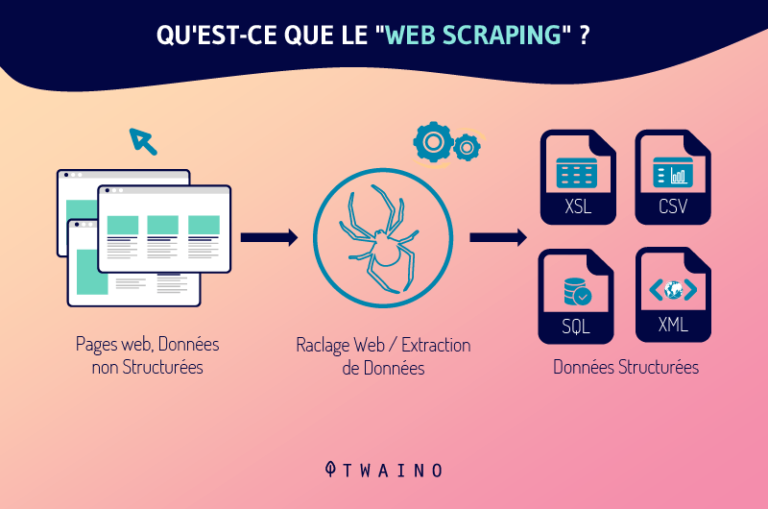

Como o rastejador, o raspador é um robô responsável pela coleta e processamento de dados na rede. Mas não se enganem, os rastejadores e raspadores não são o mesmo tipo de robôs.

O raspador de teias é para o raspador de teias o que yin é para yang, preto para branco, mal para bem..

Um serve aos legítimos e aos justos, enquanto o outro às vezes serve ao lado obscuro

Na realidade, o raspador é um bot programado para localizar e duplicar em sua totalidade, geralmente sem autorização, dados específicos pertencentes ao conteúdo de um website

Depois de extrair esses dados, o raspador os acrescenta como estão ou como foram modificados em bancos de dados para uso posterior.

Embora semelhantes, os dois bots são claramente diferentes em vários aspectos:

- Sua função principal

A função do rastreador consiste exclusivamente em explorar, analisar e indexar o conteúdo da web através da consulta contínua de URLs antigos e novos. Os raspadores, por outro lado, só existem para copiar dados de sites da Internet, seguindo URLs específicos.

- O impacto deles nos servidores da rede:

Ao contrário dos rastreadores de motores de busca, que seguem as diretrizes dos arquivos robots.txt e estão satisfeitos com os metadados, os raspadores não seguem nenhuma regra.

Vejamos um rápido estudo de caso sobre o conceito de raspagem da rede:

Estudo de caso

- Em primeiro lugar, por referente a para Termos de uso de 7 de junho de 2017o Linkedin declara o seguinte através da seção 8.2.k

“O senhor concorda em não: […] desenvolver, suportar ou usar qualquer software, dispositivos, scripts, bots ou qualquer outro meio ou processo (incluindo, sem limitação, crawlers, plug-ins e add-ons de navegador, ou qualquer outra tecnologia ou trabalho físico) para sucatear os Serviços ou copiar perfis e outros dados dos Serviços”.

Apesar disso, em uma batalha legal entre o Linkedin e uma empresa americana em início de operação chamada HiQ Labs (sobre o uso de práticas de “web scraping” para coletar exclusivamente informações pertencentes aos perfis públicos do LinkedIn dos funcionários de uma empresa), o tribunal decidiu o seguinte

Os dados que estão presentes nos perfis dos usuários são públicos uma vez publicados na rede e podem, nesse caso, ser livremente coletados através de raspagem na web.

- Em segundo lugar, referindo-se a digital-factorya raspagem da web seria considerada sob o artigo 323-3 do Código Penal francês como “Roubo de dados”. Este artigo diz:

“O fato de introduzir dados fraudulentamente em um sistema de processamento automatizado, extraindo, retendo, reproduzindo, transmitindo, apagando ou modificando fraudulentamente os dados que contém é punível com cinco anos de prisão e uma multa de 150.000 euros. Quando essa ofensa tiver sido cometida contra um sistema automatizado de processamento de dados pessoais implementado pelo Estado, a pena é aumentada para sete anos de prisão e uma multa de 300.000 euros

Agora cabe ao senhor tirar sua conclusão a partir desse conceito de raspagem da rede.

Capítulo 4: Outras perguntas feitas sobre os rastejadores da web

4.1. O que é um rastejador?

Um web crawler é um software projetado pelos motores de busca para automaticamente rastrear e indexar a web.

4.2 O que está rastejando no Google?

Rastejar é o processo pelo qual o Googlebot (também conhecido como um robô ou aranha) visita as páginas a fim de adicioná-las ao índice do Google. O mecanismo de busca usa uma vasta gama de computadores para recuperar (ou “rastejar”) bilhões de páginas na rede

4.3. Quando está rastejando?

O rastreamento ocorre quando o Google ou outro mecanismo de busca envia um robô (ou aranha) para uma página da web ou publicação na web para rastrear a página da web

Esses rastejadores então extraem links das páginas que visitam para descobrir páginas adicionais no site

4.4 Como funciona o crawler do Google?

Os rastreadores da Web iniciam seu processo de rastreamento baixando o arquivo robot.txt do site. O arquivo inclui mapas de sites que listam as URLs que o mecanismo de busca pode rastrear. Quando os rastejadores começam a rastejar uma página, eles descobrem novas páginas através de links

Assim, eles acrescentam os URLs recém-descobertos à fila de rastejamento para que possam ser rastreados mais tarde. Com essa técnica, esses rastejadores podem indexar todas as páginas que estão ligadas a outras.

Uma vez que as páginas mudam regularmente, os motores de busca rastejam usar vários algoritmos para decidir sobre fatores como a freqüência com que uma página existente deve ser rastreada e quantas páginas de um site devem ser indexadas.

4.5. O que é o anti-rastejador?

O anti-rastejador é uma técnica para proteger contra rastejadores ou indexadores de seu website. Se seu website contiver imagens valiosas, informações sobre preços e outras informações importantes que o cliente não queira que sejam rastreadas, o cliente poderá usar etiquetas de meta robôs.

4.6. Como o Google trabalha para fornecer resultados relevantes às consultas dos usuários?

O Google rastreia a web, categoriza os milhões de páginas que existem e as acrescenta ao seu índice. Assim, quando um usuário faz uma pergunta, em vez de rastrear toda a web, o Google pode simplesmente rastrear seu índice mais organizado para obter resultados relevantes rapidamente.

4.7. O que são aplicações de web crawling?

O rastreamento da web é comumente usado para indexar páginas para motores de busca. Isso permite que os motores de busca forneçam resultados relevantes para as consultas dos usuários.

O “web crawling” também é usado para descrever o “web scraping”, a extração de dados estruturados de páginas da web e similares.

4.8. Quais são os exemplos de Crawler?

Cada mecanismo de busca usa o seu próprio crawler da rede para coletar dados da Internet e indexar os resultados da busca

Por exemplo:

- Amazonbot é um web crawler da Amazon para identificação de conteúdo da web e descoberta de backlink

- Baiduspider para Baidu ;

- Motor de busca Bingbot para Bing pela Microsoft ;

- DuckDuckBot para DuckDuckGo ;

- Exabot para o motor de busca francês Exalead;

- Googlebot para Google ;

- Yahoo! Slurp para Yahoo ;

- Yandex Bot para Yandex ;

- Etc.

4.9. Qual é a diferença entre o raspador de teia e o raspador de teia?

Em geralrastejando na teia é praticada pelos motores de busca através de robôs que consistem em rastejar e criar uma cópia da página no índice

Ao contrário dos rastejantes raspagem da teia é usado por um humano, sempre através de um bot, para extrair dados particulares, geralmente de um website, para uma possível análise ou para criar algo novo

Em resumo

Rastejadores e indexação são agora conceitos cujo significado e implicações o senhor domina. Lembre-se de que esses conceitos são a vida cotidiana e a própria essência dos motores de busca

O rastejador, em sua função de prospecção e arquivamento da web, determina a presença e a posição dos websites nos resultados do mecanismo de busca

No entanto, os robôs de indexação, as aranhas ou o que quer que o senhor queira chamar-lhes, também são usados em muitos outros campos e disciplinas

Desde o funcionamento dos diferentes protagonistas da busca pela Internet até as melhores práticas para sua otimização, o senhor tem agora uma idéia bastante clara de todo o assunto.

Aplique os conhecimentos que o senhor adquiriu de maneira inteligente

Partilhe conosco seus comentários e suas descobertas sobre o assunto

Até breve!